要旨

あらゆるネットワークのエッジでは、サーバー、プロセッサー、およびデータ ストレージ アレイを、それらを最大限に活用できる人のできるだけ近くに配置する機会があります。 電子の速度は基本的に一定であるため、距離を縮めることができれば、待ち時間を最小限に抑えることができます。 エッジで使用するように設計されたネットワークは、この最小限の距離を利用して、サービスを迅速化し、価値を生み出します。

エッジでの使用を目的とした最新の通信ネットワーク (たとえば、5G ワイヤレス ネットワーク) では、2 つの可能な戦略が使用されます。

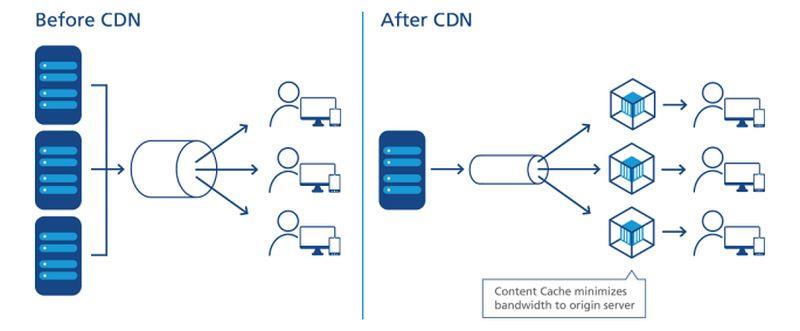

- データ ストリーム、オーディオ、およびビデオは、サーバーがユーザーから最小限の中間ルーティング ポイント、または「ホップ」によって隔てられている場合、より速く、より少ない休止時間 (できればまったくない) で受信される可能性があります。 Akamai、Cloudflare、および NTT Communications などのプロバイダーによるコンテンツ配信ネットワーク (CDN) は、この戦略に基づいて構築されています。

アプリケーションによっては、どちらか一方または両方のエッジ戦略が採用された場合、これらのサーバーは実際にはネットワークの一方の端またはもう一方の端に配置される可能性があります。 インターネットは昔の電話網のようには構築されていないため、ルーティングの便宜上「近い」ということは、必ずしも地理的な距離が近いということではありません。 また、パブリッククラウドアプリケーションプロバイダー(SaaS)、アプリプラットフォームプロバイダー(PaaS)、リース型インフラプロバイダー(IaaS)、コンテンツ配信ネットワークなど、組織が契約しているサービスプロバイダーの種類によっては、複数のIT不動産が常に「端」を争っている可能性がある。

Schneider Electric マイクロデータセンターのキャビネット内部

Scott Fulton

企業ネットワークの現在のトポロジー

ほとんどの企業は独自のアプリケーションとサービスを展開および管理する傾向がある 3 か所を挙げています。

- オンプレミス

- では、データ センターに複数のサーバー ラックがあり、電源と冷却に必要なリソースが備わっており、外部リソースへの専用接続があります

- コロケーション施設では、顧客の機器が完全に管理された建物でホストされ、電源、冷却、および電源があります

。

- クラウド サービス プロバイダー。顧客のインフラストラクチャはある程度仮想化され、サービスおよびアプリケーションは使用ごとに提供されるため、運用は資本支出ではなく運用費として計上できます

エッジ コンピューティングの設計者は、このリストに 4 番目のカテゴリとして設計を追加しようとします。 より小さく、よりモジュール化されたサーバーを備えた、より小さくコンテナ化された設備の可搬性を活用し、ネットワーク内の処理ポイントと機能の消費ポイント間の距離を短縮するものです。 彼らの計画がうまくいけば、次のようなことが実現できます。

潜在的な利点

- 最小の待機時間。 現在のクラウド コンピューティング サービスの問題は、特に人工知能に対応したワークロードの場合、速度が遅いということです。 これは、リアルタイムの証券市場の予測、自律走行車の操縦、および輸送交通のルーティングなどの決定論的アプリケーションにおいて、クラウドを本格的に使用するには本質的に不適格です。 プロセッサーは、そのプロセスが使用される場所に近い小規模データセンターに設置され、これまでクラウドプロバイダーが対応できなかったコンピューティングサービスに新しい市場を開拓することができます。 IoT シナリオでは、スタンドアロンのデータ収集アプライアンスのクラスターが広く分散していますが、それらのアプライアンスのサブグループまたはクラスターに近いところにプロセッサーを配置すると、処理時間を大幅に改善し、より詳細なレベルでリアルタイム分析を実現することができます。 トラックやメンテナンス車の一団を現場のロケーションに派遣することにそれほど苦労しない企業にとって、マイクロ データ センター (μDC) は、最大のアクセス性、モジュール性、および適度な可搬性を持つように設計されています。 マイクロデータセンターは、ピックアップトラックの荷台に収まるほど小さな筐体で、タイムクリティカルな機能をホストするのに十分なサーバーをサポートし、ユーザーの近くに配置することができます。 考えられるのは、現在データ センター資産を地下に収容し、電力供給し、冷却しているビルにおいて、そのオペレーション全体を駐車場のどこかにある 3、4 台の µDC に置き換えることは、実際に改善されるかもしれないということです。 大規模なデータ センターの場合、冷却に使用される毎月の電力コストは、処理に使用される電力コストを簡単に上回ることがあります。 この 2 つの比率は、電力使用効率 (PUE) と呼ばれます。 時には、これがデータセンターの効率を測る基準となってきました(ただし、近年の調査では、この比率が実際に何を意味するのかを知っているITオペレーターは少なくなっています)。 理論的には、1つの大きなデータセンターで冷房や空調を行うよりも、複数の小さなデータセンターで冷房や空調を行う方が、ビジネスコストは低くなります。 さらに、一部の電力サービスエリアでは課金処理の方法が特殊なため、同じサーバーラックを1つの大きな施設ではなく複数の小さな施設でホストした場合、キロワット当たりのコストが全体的に下がる可能性があります。 Schneider Electricが発表した2017年のホワイトペーパーでは、従来のデータセンターとマイクロデータセンターの構築に関連する大小すべてのコストを評価しています。 企業が従来の 1 MW の施設を建設するために 700 万ドル弱の資本経費がかかるのに対し、200 の 5 KW の施設を促進するためには 400 万ドル強の経費がかかります。

- Climate conscience (気候的良心)。 巨大な超大規模施設に電力を集中させ、接続のために広帯域の光ファイバー リンクに依存するのとは対照的に、より広い地理的領域にわたって顧客にコンピューティング パワーを配布するという考えには、常に一定の環境的な魅力があります。 エッジコンピューティングの初期のマーケティングは、小規模な施設ほど消費電力が少ないというリスナーの常識的な印象に依存しています。 しかし、それが実際に正しいかどうかについては、まだ審査が行われていません。 スロバキアのコシツェ工科大学の研究者が2018年に行った研究では、IoTシナリオにおけるエッジコンピューティングの展開をシミュレーションし、エッジのエネルギー効果は、そこで行われる計算の精度と効率にほぼ完全に依存すると結論付けています。

これらのことが実現可能なほど複雑なシステムに思えるなら、現在の形では、パブリック クラウド コンピューティング モデルは長期的に維持できないかもしれないことを覚えておいてください。 このモデルでは、加入者はアプリケーション、データ ストリーム、コンテンツ ストリームを、州、地方、国全体をサービス エリアとする超巨大複合施設に接続されたパイプを通じてプッシュし続けなければなりません – ワイヤレス音声プロバイダーがあえて試みることのないシステムです。

潜在的な落とし穴

にもかかわらず、エッジ コンピューティング モデルで完全に作り直されたコンピューティング世界は、石油燃料から完全に離脱した交通機関の世界と同じくらい素晴らしく、同じくらい遠いものです。 短期的には、エッジ コンピューティング モデルはいくつかの重要な障害に直面しており、そのうちのいくつかは、克服するのがまったく容易ではありません。

- 三相電源がリモートで利用可能であること。 クラウドのようなリモート サービスを商用顧客に提供できるサーバーは、それがどこにあるかにかかわらず、マルチテナントを可能にするために、高出力プロセッサとインメモリ データを必要とします。 おそらく例外なく、高電圧の三相電力にアクセスする必要がある。 比較的遠隔地の地方では、不可能ではないにせよ、高電圧の三相電力を得ることは非常に困難です。 (通信事業者の基地局は、これまでこのレベルの電力を必要としなかったし、マルチテナント型の商業利用を想定していないのであれば、三相電力が必要になることはないかもしれない。 電力系統を改修する理由は、エッジコンピューティングが実現できる場合だけでしょう。 しかし、ミシシッピ州での遠隔心臓モニターの試験のような、広く分散した Internet-of-Things アプリケーションでは、十分な電力インフラの欠如が、「持つ者」と「持たざる者」を再び分断することになりかねません。 5G への移行を安価に行うには、通信事業者はエッジ コンピューティングからさらなる収益を得る必要があります。 エッジ コンピューティングの進化を 5G に結びつけるというアイデアを生み出したのは、商用機能と運用機能が同じサーバー上に共存できるという考え方でした。これは、Central Office Re-architected as a Datacenter (CORD) (元は “Re-imagined” )が導入した概念で、現在その一形態は 5G Wireless の主要な促進因子と見なされています。 問題は、通信ネットワークの基本的なオペレーションと顧客の機能を同じシステム上で共存させることさえ合法でない可能性があることです。答えは、法律家が「システム」の新しい定義を理解できるかどうかにかかっています。 その日が来るまでは(来るとしても)、3GPP(5Gの標準を管理する業界団体)はネットワークスライシングという概念を採用しています。これは、通信ネットワークサーバを非常に低いレベルの仮想サーバに切り分け、例えばVMwareのような一般的な仮想化環境よりもはるかに大きな分離を行う方法です。 考えられるのは、顧客向けのネットワークスライスを通信事業者ネットワークのエッジに配備し、限られた顧客にサービスを提供することです。 しかし、一部の大企業は、価値提案が主に希望に基づいている新しいシステムに投資するよりも、たとえそれが自社の施設に展開することであっても、つまりエッジを自社の敷地内に移動することであっても、自社のネットワーク スライスを管理することを望んでいます。 5G 無線アクセス ネットワーク (RAN) とそれに接続された光ファイバー ケーブルを商用顧客サービスに活用する場合、何らかの種類のゲートウェイを設置して、通信事業者のトラフィックから個人顧客のトラフィックを吸い上げる必要があります。 このようなゲートウェイのアーキテクチャはすでに存在し、3GPPで正式に採用されています。 これはローカルブレイクアウトと呼ばれ、ETSI標準化団体のマルチアクセスエッジコンピューティング(MEC)の公式宣言の一部にもなっています。 つまり、技術的にはこの問題は解決されたのです。 問題は、特定の通信事業者が、顧客トラフィックが通常通る経路から自社のデータセンターに転送されるのを阻止することに関心を持っている可能性があることです。 今日のインターネット・ネットワークのトポロジーは3層構造になっています。 Tier1のサービスプロバイダーは互いにのみピアリングを行い、Tier2のISPは通常、顧客と向き合っています。 第3の層は、よりローカルなレベルの小規模な地域ISPを可能にします。 グローバル規模のエッジコンピューティングは、ローカルレベルの ISP が、おそらく一種の「チェーンストア」を通じて提供するパブリッククラウド型サービスの触媒となる可能性があります。 しかし、これは、第2階層を管理する通信事業者が、受信ネットワーク トラフィックを第3階層に分割させ、自分たちのために簡単に主張できる市場での競争を可能にすることを望んでいる場合です。

場所、場所、場所が企業にとって再び重要になる場合、企業コンピューティング市場全体がひっくり返る可能性があります。 クラウド データ センターの超大規模、集中型、電力消費型という性質は、小規模で軽快、かつコスト効率のよい運用モデルが、計画通りにいけばタンポポのように、より広範囲に分散した場所で生まれ、結局は不利に働く可能性があります。

技術分析会社 Marko Insights の代表である Kurt Marko 氏は、ZDNet に対するメモで、「エッジ展開への関心は、主に『スマート』デバイス、センサー、ユーザー、特にモバイル/ワイヤレス ユーザーが生成する大量のデータを処理する必要性によって高まっていると思う」と述べています。 実際、5Gネットワークのデータレートとスループットは、顧客のデータ利用がエスカレートするのに伴い、モバイル基地局がミニデータセンターになることが必要になります。”

「エッジ コンピューティング」とは何を意味するのでしょうか?

どのような通信ネットワークにおいても、エッジとは、その設備やサービスが顧客に向かって最も遠くに到達しているところを指します。 エッジ コンピューティングのコンテキストでは、エッジは、サーバーが最も迅速に顧客に機能を提供できる地球上の場所です。

CDN はどのように道を切り開いたか

Industrial Internet Consortium が描いたデータ センターと Internet-of-Things デバイス間の関連図です。

インターネットに関して、コンピューティングまたは処理は、ネットワーク図の中心または焦点に近い形状 (たとえば、雲) で表されるコンポーネントであるサーバーによって実行されます。 データは、この図の端にあるデバイスから収集され、処理のために中心に向かって引き寄せられます。 処理されたデータは、精製所から出る石油のように、配送のために再び端の方に送り出されます。 CDNは、近隣のユーザーのための「充填所」として機能することで、このプロセスを迅速化します。 ネットワークサービスの典型的な製品ライフサイクルには、この「ラウンドトリップ」プロセスが含まれ、データは効率的に採掘、出荷、精製、そして再び出荷されます。 そして、物流を伴う他のプロセスと同様に、輸送には時間がかかる。

データ配信プロセスにおける CDN サーバーの配置を正確に図式化したもの。

NTT Communictions

重要なのは、CDN が常に図の中央に存在するかどうかは、誰の図を見ているかに依存するということです。 CDN プロバイダーが作成した場合、中央に大きな「CDN」クラウドがあり、一方の端に企業ネットワーク、もう一方の端にユーザー機器デバイスがある可能性があります。 ただし、NTTの場合は例外で、上の図は簡略化されていますが、より正確には、データアクセスのポイントとユーザーの間にCDNサーバーが入り込んでいることを示しています。 CDNは、データやコンテンツの制作者、つまり配信事業者の視点から見ると、サプライチェーンの末端、つまりユーザーがデータを受信する前の最後のステップに位置することになります。

過去 10 年間で、主要な CDN プロバイダーは、配信ポイントに常駐するコンピューティング サービスの導入を開始しました。 ガソリンスタンドがそれ自身の精製所であると想像していただければ、イメージが湧くのではないでしょうか。 このサービスの価値提案は、CDNが中心ではなく、エッジで認識されることに依存する。 このサービスにより、一部のデータは輸送の必要性を回避し、処理されて再び輸送されるようになります。

分散化の傾向

CDN は、サービスとしてのエッジ コンピューティングの有効性をまだ証明していないとしても、少なくともビジネスとしての価値を実証しています。 企業は、一部のデータがネットワークの中心、つまり「コア」に到達する前に処理されるように、保険料を支払うことになります。

昨年 2 月の記者会見で、Dell Technologies の戦略および計画担当上級副社長である Matt Baker は、「私たちはかなり長い間、集中化を進めてきました」と説明しています。 “そして、世界がデジタルトランスフォーメーションへの取り組みを通じて、ますますリアルタイムのデジタル体験を提供しようとする中、IT に対する高度に集中化されたアプローチを維持する能力は、かなり破壊され始めています。”

エッジ コンピューティングは、5G ワイヤレス技術によって実現可能になる有利な新市場の 1 つとして注目されています。 4G から 5G への世界的な移行が多くの電気通信会社にとって経済的に実現可能であるためには、新世代が新しい、開拓可能な収益チャネルを開く必要があります。 5Gでは、送信機と基地局にデジタルデータへの即時アクセスを供給するために、(皮肉にも)有線、光ファイバー接続の広大で新しいネットワーク(バックホール)を必要とします。 その結果、新しいタイプのコンピューティングサービスプロバイダーが、無線アクセスネットワーク(RAN)タワーに隣接して複数のµDCを配備する機会が生まれます(おそらく通信会社の基地局に隣接するか、同じ建物を共有することになるでしょう)。 これらのデータセンターは、Amazon、Microsoft Azure、Google Cloud Platformなどのハイパースケールクラウドプロバイダーと同等の機能、料金で、特定の顧客にクラウドコンピューティングサービスを提供することができます。

理想的には、おそらく 10 年ほどの進化の後、エッジ コンピューティングにより、最寄りのワイヤレス基地局の近くにいる顧客に高速サービスを提供できるようになるでしょう。 必要なバックホールを供給するために巨大な光ファイバー管が必要になりますが、エッジ コンピューティング サービスからの収益は、その建設資金に充てられる可能性があり、自給自足が可能になります。

サービス

最終的な分析では (実際に分析が最終的であるならば)、ネットワーク エッジでのデータ センターの成功または失敗は、サービス レベル目標 (SLO) を満たす能力によって決定されるでしょう。 これは、サービス契約書に明記された、サービス料金を支払う顧客の期待値です。 エンジニアは、ネットワーク・コンポーネントのパフォーマンスを記録し、分析するために使用する測定基準を持っています。 顧客はこうした測定基準を避け、代わりにアプリケーションの観測可能なパフォーマンスを優先する傾向があります。 もしエッジの展開がハイパースケールの展開より明らかに速くなければ、エッジというコンセプトは初期段階で死んでしまうかもしれません。

「私たちが気にすることは何でしょうか? と、VMware のネットワークおよびセキュリティ担当上級副社長である Tom Gillis は、最近の同社のカンファレンスで説明しました。 「アプリケーションがどのように応答するかを特徴付けることができ、そのアプリケーション応答を提供するために動作している個々のコンポーネントを見ることができれば、実際に自己回復インフラストラクチャを作成し始めることができます」。

レイテンシーの削減と処理速度の向上 (量的にはるかに少ないタスクに専念する新しいサーバー) は、SLO の利点につながるはずです。 少なくともパンデミックまでは、1 日または 2 日のイベントとそれに続く回復期間として認識されていました。

しかし、最も重要なのはメンテナンスと維持管理に関係する、バランスをとるための要因があることです。 典型的な Tier-2 データ センター施設は、緊急事態 (パンデミックなど) では、わずか 2 人のオンサイト担当者とオフサイトのサポート スタッフで維持管理できます。 一方、μDCは、常時スタッフを配置しなくても機能するように設計されている。 内蔵されたモニタリング機能は、理論的にはパブリッククラウドにあるセントラルハブに継続的にテレメトリーを送ります。 μDCがSLOを満たしている限り、個人的に立ち会う必要はないのです。

ここで、エッジ コンピューティング モデルの実行可能性がまだ十分に検証されていない点があります。 一般的なデータ センター プロバイダーの契約では、SLO は、プロバイダーの担当者が未解決の問題をどれだけ早く解決できるかによって測定されることがよくあります。 一般的に、担当者がトラックでトラブルポイントに行く必要がない場合、解決時間は低く抑えることができます。 エッジ展開モデルがコロケーション展開モデルと競争力を持つには、その自動修復能力が異常に優れている必要があります。

階層型ネットワーク

データ ストレージ プロバイダー、クラウド ネイティブ アプリケーション ホスト、モノのインターネット (IoT) サービス プロバイダー、サーバー メーカー、不動産投資信託 (REIT) および組み立て済みサーバー エンクロージャー メーカーはすべて、顧客と各社にとってエッジとなることを約束するものの間に高速ルートを敷設しようとしています。

彼らが本当に求めているものは、競争上の優位性です。 エッジという考え方は、プレミアム サービスの展望に新たな希望をもたらします。つまり、特定のクラスのサービスが他よりも高い料金を要求する、確かで正当な理由です。 エッジが最終的にクラウド全体を包含する可能性があるという話をどこかで読んだり聞いたりしたことがある人は、それが実はあまり意味をなさないことを理解しているかもしれません。 すべてがプレミアムになれば、何もプレミアムにはなりません。

「エッジ コンピューティングはどうやら完璧なテクノロジー ソリューションになりそうで、ベンチャー キャピタルは数十億ドルの技術市場になると言っています」と、データ センター サービス機器プロバイダーでマイクロ データ センター シャーシ メーカーでもある Schneider Electric の CTO 兼イノベーション担当上級副社長の Kevin Brown は指摘します。 「それが何であるかは誰も知らないのです。

Schneider Electric の Kevin Brown:「それが何かは誰も実際に知らないのだ」と。「

Brown 氏は、エッジ コンピューティングがその歴史を Akamai のような先駆的 CDN に帰するものかもしれないことを認めました。 しかし、彼は「HPEにはHPEの、CiscoにはCiscoの、それぞれ異なるレイヤーがあります」と続けました。 . . 私たちはそのどれにも意味を見出せませんでした。 私たちのエッジに対する考え方は、非常に単純化されたものです。 将来的には、世界には3種類のデータセンターが存在することになり、それについて心配する必要があります。

2019年2月にマサチューセッツの本社で行われたプレスイベントでBrown氏が描いた絵は、3層構造のインターネットに対する再浮上した見方であり、ますます多くのテクノロジー企業に共有されています。 従来の2層モデルでは、Tier-1ノードは他のTier-1ノードとのピアリングに限定され、Tier-2ノードは地域レベルでのデータ配信を担当する。 インターネットが始まって以来、Tier-3は、よりローカルなレベルでのアクセスに指定されています。 (携帯電話の無線アクセスネットワークの仕組みとは対照的で、トラフィックの分配は1層構造になっています)。

「ネットワークに接続する最初のポイントは、私たちがローカル エッジと考えるものです」と、Brown は説明します。 今日の技術に当てはめると、今日のエッジ コンピューティング設備の 1 つは、配線クローゼットの間に合わせのラックに押し込まれたサーバーの中にあるかもしれないと、彼は続けました。

「私たちの目的では、そこがアクションのある場所だと考えています」と彼は続けました。

「長年、エッジは、エクイニクスやコアサイトのような Tier-1 キャリア ホテルでした。 エッジインフラストラクチャサービスプロバイダのStackPathのCTOであるWen Temitim氏は、「彼らは基本的に1つのネットワークを別のネットワークに接続し、それをエッジとみなしていました」と説明します。 「しかし、消費者行動やCOVID-19、在宅勤務など、さまざまな利用形態の変化に伴い、サービスプロバイダーにとってより適切な、より深いエッジが求められるようになっています」。

地図上でエッジを見つける

エッジ コンピューティングは、誰がサービスを提供するかだけでなく、どこで提供するかを企業が決定するにあたり、データセンターのアーキテクチャとサービスの議論にサービス品質 (QoS) を取り戻すための取り組みです。

「運用テクノロジー エッジ」

データ センター機器メーカーの HPE は、エッジ コンピューティングへの主要な投資家ですが、運用インフラにおける次の大きな飛躍は、ハードウェアやインフラへの個人投資やトレーニングをあまり受けていないスタッフや契約社員によって調整、指導されると考えています。 彼女の会社では、このような人材をオペレーショナル・テクノロジー(OT)と呼んでいます。 HPEは、ITと運用が「DevOps」のような形で融合すると考える人々とは異なり、エッジコンピューティングの顧客には3つのクラスがあると見ています。 HPEの見解では、これらのクラスはそれぞれ独自のエッジコンピューティングプラットフォームを維持するだけでなく、このHPEの図に描かれているように、これらのプラットフォームの地理は収束するのではなく、互いに分離することになるのです。

ここに、3 種類の異なる顧客層が存在しますが、それぞれはHPE によって広くエッジにおける自身のセグメントとして分類されたものです。 ここでいうOTクラスとは、エッジ コンピューティングに管理者を配置する可能性が高い顧客のことで、ITに関する直接的な経験が少なく、主に主要製品が情報通信そのものでないことが原因です。 このクラスには、「OTエッジ」が割り当てられています。 企業が産業として情報により直接的に投資している場合、またはビジネスの構成要素として情報に大きく依存している場合、HPEはその企業に “ITエッジ “を割り当てます。 その中間で、地理的に分散しており、物流(情報がより論理的な要素を持つ)に依存しているビジネス、つまりInternet of Thingsについては、HPEは “IoTエッジ “とします。

Dell の三者間ネットワーク

2017年、Dell Technologiesは初めて、コンピュータ市場全体に対して、”コア””クラウド””エッジ “に分ける3層式のトポロジーを提供しました。 デルの初期のプレゼンテーションのこのスライドが示すように、この区分は、少なくとも当初は根本的にシンプルに見えました。 顧客のIT資産は、1)自社で所有し、自社スタッフで保守するもの、2)サービスプロバイダに委託し、保守を依頼するもの、3)自社の施設を越えて現場に配備し、運用専門家(アウトソーシングする場合もしない場合もある)が保守するものに、それぞれ分けることができるのである。

2018年11月に開催されたLinux FoundationのEmbedded Linux Conference Europeのプレゼンテーションで、CTO for IoT and Edge ComputingのJason Shepherd氏はこのようにシンプルな事例を紹介しています。 IoT向けに多くのネットワーク接続されたデバイスやアプライアンスが計画されているため、パブリッククラウドを取り込む場合も含めて、それらの管理を一元化することは技術的に不可能でしょう。

「妻と私は3匹の猫を飼っています」と、Shepherd氏は聴衆に語りました。 携帯電話のストレージ容量が大きくなったので、猫の動画を送り返すことができるようになりました」。

“Cat videos explain the need for edge computing,” he continues to: “猫の動画は、エッジ コンピューティングの必要性を説明しています。 「もし私が自分のビデオをオンラインに投稿して、それがヒットし始めたら、クラウドにあるもっと多くのサーバーにキャッシュしなければなりません。 さらに、「もし、その動画がバイラル化したら、そのコンテンツをできるだけ加入者の近くに持っていかなければなりません。 通信事業者であれ、Netflixであれ、最も近いところにあるのはクラウドエッジ、つまりセルタワーの下、インターネット上の重要なポイントなのです。 これがMEC(Multi-access Edge Computing)のコンセプトで、コンテンツを加入者に近づけるというものです。 しかし、もし何十億人もの猫に電話をかけているとしたら、パラダイムは完全に逆転しています。 そうなると、コンピュートをさらに下に押しやらなければならなくなります。

新たな「エッジ クラウド」

シェパードが怖がる子猫を世界初公開して以来、Dell のエッジの概念は、ニュアンスのある層の集合からより基本的な分散化倫理へと、いくらか固まりました。

「私たちは、エッジは必ずしも特定の場所や特定のテクノロジーによって定義されるのではないと見ています」と、Dell の Matt Baker は昨年 2 月に述べています。 「その代わりに、IT 環境の分散化が進んでいるため、IT インフラストラクチャソリューションやソフトウェアなどをますます制約の多い環境に置くことになり、既存の IT 展開が複雑化することになるのです。 データセンターは、自分の好きな仕様で構築でき、十分な冷却が可能で、スペースも十分にあるため、ほとんど制約のない環境と言えます。 しかし、リアルタイムのデジタル体験を提供するために、より多くのテクノロジーを身の回りに置くようになると、何らかの形で制約のある場所に置かれることになります。

キャンパス ネットワークには、低帯域幅の接続性以外に、埃や汚れの多い機器が含まれていると Baker 氏は述べています。 通信事業者の環境には、非常に高密度のプロセッサを必要とする、奥行きの短いラックが含まれることがよくあります。 また、地図上で最も遠い地域では、熟練したIT労働者が少なく、「高度に分散した環境を無人状態で管理する能力に大きなプレッシャーをかけている」と述べています。

それにもかかわらず、データを最初に評価または作成された時点に近いところで処理することが、ますます多くの顧客に求められている、と彼は主張します。 つまり、2020年頃の「エッジ」の位置は、地図上のどの地点であれ、より良い表現はできませんが、データが燃えているのを見つけることができる場所なのです。

StackPathのTemitimは、その地点がエッジ クラウドと呼ばれる新しい概念であり、事実上、単一のプラットフォームにおける複数のエッジ デプロイメントの仮想集合体であると信じています。 このプラットフォームは、まず、独自の配信ネットワークを所有し、長期的なコスト削減を目指す多チャンネルビデオ配信事業者(MVPD、通常は既存のケーブル会社ですが、一部の通信事業者も含みます)に対して販売されるでしょう。 しかし、これらのプロバイダーは、追加の収入源として、SaaSアプリケーションや仮想サーバーホスティングなど、パブリッククラウドに似たサービスを商用クライアントに代わって提供することができます。

このような「エッジ クラウド」市場は、世界の中規模 Tier-2 および Tier-3 データ センターと直接競合する可能性があります。 これらの施設のオペレーターは、通常、それぞれの地域の通信会社のプレミアム顧客であるため、これらの通信会社は、エッジ クラウドを、自社の 5G ワイヤレス計画に対する競争上の脅威と認識する可能性があります。 あるエッジインフラ・ベンダーが言うように、これはまさに「物理的な土地の奪い合い」です。 そして、その争奪戦はまだ始まったばかりなのです。

詳細 – CBS Interactive Network

- How edge computing may revamp, revitalize commercial real estate by Larry Dignan, Between the Lines

- It’s a race to the edge, and the end of cloud computing as we know it by Scott M. Fulton, III, Scale

- Make edge computing a key investment for 2020 by Forrester Research

他の場所

- The Data Center That’s a Coffee Table by Scott M. B. Fulton, III, Scale

- The Data Center That’s a Coffee Table by Scott M. B. Fulton, III, Inc. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com