- Resumo executivo

- A topologia actual das redes empresariais

- Potenciais benefícios

- Potenciais armadilhas

- O que significa “computação de ponta”?

- Como os CDNs abriram a trilha

- A tendência para a descentralização

- Objetivos de nível de serviço

- A rede em camadas

- Localizando a borda em um mapa

- A “tecnologia de ponta operacional”

- rede tripartida da Dell

- A emergente ‘nuvem de borda’

- Aprenda mais – Da CBS Interactive Network

- Outro lugar

Resumo executivo

Na borda de qualquer rede, há oportunidades para posicionar servidores, processadores e matrizes de armazenamento de dados o mais próximo possível daqueles que podem fazer melhor uso deles. Onde você pode reduzir a distância, sendo a velocidade dos elétrons essencialmente constante, você minimiza a latência. Uma rede projetada para ser usada na borda aproveita essa distância mínima para agilizar o serviço e gerar valor.

Em uma rede de comunicações moderna projetada para uso na borda – por exemplo, uma rede sem fio 5G – há duas estratégias possíveis em ação:

- Os fluxos de dados, áudio e vídeo podem ser recebidos mais rapidamente e com menos pausas (de preferência nenhuma) quando os servidores estão separados de seus usuários por um mínimo de pontos intermediários de roteamento, ou “hops”. Redes de entrega de conteúdos (CDN) de provedores como Akamai, Cloudflare e NTT Communications e são construídas em torno desta estratégia.

- As aplicações podem ser aceleradas quando os seus processadores estão estacionados mais próximos do local onde os dados são recolhidos. Isto é especialmente verdadeiro para aplicações de logística e fabricação em larga escala, bem como para a Internet das Coisas (IoT), onde sensores ou dispositivos de coleta de dados são numerosos e altamente distribuídos.

Dependente da aplicação, quando uma ou ambas as estratégias de borda são empregadas, esses servidores podem na verdade acabar em uma ponta da rede ou na outra. Como a Internet não é construída como a antiga rede telefônica, “mais próxima” em termos de expediente de roteamento não é necessariamente mais próxima em termos de distância geográfica. E, dependendo de quantos tipos diferentes de provedores de serviços a sua organização contratou – provedores de aplicativos em nuvem pública (SaaS), provedores de plataforma de aplicativos (PaaS), provedores de infraestrutura arrendados (IaaS), redes de entrega de conteúdo – pode haver vários tipos de imóveis de TI que estão “na ponta” a qualquer momento.

Inside a Schneider Electric micro data center cabinet

Scott Fulton

A topologia actual das redes empresariais

Existem três locais onde a maioria das empresas tende a implementar e gerir as suas próprias aplicações e serviços:

- On-premises, onde os centros de dados abrigam múltiplos racks de servidores, onde estão equipados com os recursos necessários para alimentá-los e resfriá-los, e onde há conectividade dedicada a recursos externos

- li> Instalações de collocation, onde os equipamentos dos clientes são hospedados em um edifício totalmente gerenciado, onde a energia, a refrigeração, e a conectividade são fornecidos como serviços/ul>

- Latência mínima. O problema com os serviços de computação em nuvem hoje em dia é que eles são lentos, especialmente para cargas de trabalho habilitadas para inteligência artificial. Isso essencialmente desqualifica a nuvem para uso sério em aplicações determinísticas, tais como previsão de mercados de valores mobiliários em tempo real, pilotagem autônoma de veículos e roteamento de tráfego de transporte. Processadores estacionados em pequenos data centers mais próximos de onde seus processos serão usados poderiam abrir novos mercados para serviços de computação que os provedores da nuvem não têm sido capazes de resolver até agora. Em um cenário de IOT, onde clusters de appliances autônomos de coleta de dados são amplamente distribuídos, ter processadores mais próximos até mesmo de subgrupos ou clusters desses appliances poderia melhorar muito o tempo de processamento, tornando a análise em tempo real viável em um nível muito mais granular.

- Manutenção simplificada. Para uma empresa que não tem muita dificuldade em despachar uma frota de caminhões ou veículos de manutenção para locais de campo, os micro data centers (µDC) são projetados para máxima acessibilidade, modularidade e um grau razoável de portabilidade. São caixas compactas, algumas pequenas o suficiente para caber na parte de trás de uma caminhonete, que podem suportar apenas servidores suficientes para hospedar funções críticas de tempo, que podem ser implantadas mais perto de seus usuários. É concebível, para um prédio que atualmente abriga, alimenta e resfria seus ativos do data center em seu porão, substituir toda essa operação por três ou quatro µDCs em algum lugar do estacionamento poderia ser realmente uma melhoria.

- Refrigeração mais barata. Para grandes complexos de centros de dados, o custo mensal da eletricidade usada no resfriamento pode facilmente exceder o custo da eletricidade usada no processamento. A relação entre os dois é chamada de eficiência de uso de energia (PUE). Por vezes, esta tem sido a medida de base da eficiência do centro de dados (embora nos últimos anos, as pesquisas tenham mostrado que menos operadores de TI sabem o que esta relação realmente significa). Teoricamente, pode custar menos a uma empresa esfriar e condicionar vários espaços de centro de dados menores do que um grande. Além disso, devido à forma peculiar como algumas áreas de serviço de eletricidade lidam com o faturamento, o custo por kilowatt pode diminuir de forma generalizada para os mesmos racks de servidor hospedados em várias instalações pequenas em vez de uma grande. Um white paper de 2017 publicado pela Schneider Electric avaliou todos os custos maiores e menores associados à construção de centros de dados tradicionais e micro. Enquanto uma empresa poderia incorrer em pouco menos de $7 milhões em despesas de capital para construir uma instalação tradicional de 1 MW, ela gastaria pouco mais de $4 milhões para facilitar 200 instalações de 5 KW.

- Disponibilidade remota de energia trifásica. Servidores capazes de fornecer serviços remotos em forma de nuvem aos clientes comerciais, independentemente da sua localização, necessitam de processadores de alta potência e dados in-memory, para permitir a multi-tenancy. Provavelmente, sem exceção, eles exigirão acesso a eletricidade trifásica de alta voltagem. Isso é extremamente difícil, se não impossível, de alcançar em locais relativamente remotos e rurais. (A corrente normal de 120V AC é monofásica.) As estações base das telecomunicações nunca precisaram deste nível de energia até agora, e se nunca foram projetadas para serem aproveitadas para uso comercial multitenant, então elas podem nunca precisar de energia trifásica de qualquer forma. A única razão para adaptar o sistema de energia seria se a computação de ponta for viável. Mas para aplicações de Internet das coisas amplamente distribuídas, como os testes de monitores cardíacos remotos do Mississippi, a falta de infraestrutura de energia suficiente poderia acabar dividindo mais uma vez os “have-not’s” dos “have-not’s”.”

- Trinchando servidores em fatias virtuais protegidas. Para que a transição de 5G seja acessível, as empresas de telecomunicações devem colher receitas adicionais da computação de ponta. O que fez com que a idéia de ligar a evolução da computação de borda para 5G fosse a noção de que funções comerciais e operacionais poderiam coexistir nos mesmos servidores – um conceito introduzido pelo Central Office Re-architected as a Datacenter (CORD) (originalmente “Re-imagined”), uma forma da qual é agora considerada um facilitador chave do 5G Wireless. O problema é que pode nem mesmo ser legal para operações fundamentais para a rede de telecomunicações co-residir com funções de clientes nos mesmos sistemas – as respostas dependem de se os legisladores são capazes de entender a nova definição de “sistemas”. Até esse dia (se vier), o 3GPP (a organização do setor que rege os padrões 5G) adotou um conceito chamado fatiamento de rede, que é uma forma de esculpir servidores de rede de telecomunicações em servidores virtuais em um nível muito baixo, com uma separação muito maior do que em um ambiente típico de virtualização, digamos, VMware. É possível que uma fatia de rede voltada para o cliente possa ser implantada no limite das redes de telecomunicações, atendendo a um número limitado de clientes. Entretanto, algumas empresas maiores prefeririam se encarregar de suas próprias fatias de rede, mesmo que isso signifique implantá-las em suas próprias instalações – deslocando a borda para suas instalações – do que investir em um novo sistema cuja proposta de valor se baseia em grande parte na esperança.

- Telcos defendendo seus territórios de origem das rupturas locais. Para que a rede de acesso de rádio 5G (RAN), e os cabos de fibra óptica a ela ligados, sejam alavancados para o serviço comercial ao cliente, algum tipo de gateway tem de estar instalado para desviar o tráfego de clientes privados do tráfego de telecomunicações. A arquitetura para tal gateway já existe , e foi formalmente adotada pelo 3GPP. É chamada de breakout local, e também faz parte da declaração oficial do órgão de normas ETSI de computação de borda de multi-acesso (MEC). Portanto, tecnicamente, este problema foi resolvido. O problema é que certas empresas de telecomunicações podem ter interesse em evitar o desvio do tráfego de clientes para fora do curso que normalmente tomariam: para os seus próprios centros de dados. A topologia atual da rede de Internet tem três camadas: Os fornecedores de serviços de nível 1 só fazem pares entre si, enquanto os ISPs de nível 2 são normalmente voltados para o cliente. O terceiro nível permite ISPs menores e regionais em um nível mais local. A computação de ponta em escala global pode se tornar o catalisador para serviços públicos no estilo nuvem, oferecidos pelos ISPs em nível local, talvez através de uma espécie de “cadeia de lojas”. Mas isso supondo que as empresas de telecomunicações, que gerenciam o Tier-2, estão dispostas a deixar apenas o tráfego de entrada de rede ser dividido em uma terceira camada, permitindo a concorrência em um mercado que elas poderiam muito facilmente reivindicar para si mesmas.

- Como a computação de borda pode renovar, revitalizar os imóveis comerciais por Larry Dignan, Between the Lines

- É uma corrida para a borda, e o fim da computação de borda como a conhecemos por Scott M. Fulton, III, Scale

- O Centro de Dados que é uma Mesa de Café por Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com

- ###### provedores de serviços em nuvem, onde a infra-estrutura do cliente pode ser virtualizada até certo ponto, e os serviços e aplicações são fornecidos numa base de per-use, permitindo que as operações sejam contabilizadas como despesas operacionais em vez de despesas de capital

Os arquitetos da computação de ponta procurariam adicionar seu projeto como uma quarta categoria a esta lista: uma que aproveite a portabilidade de instalações menores, contentorizadas com servidores menores e mais modulares, para reduzir as distâncias entre o ponto de processamento e o ponto de consumo da funcionalidade na rede. Se os seus planos se concretizarem, eles procuram realizar o seguinte:

Potenciais benefícios

- li> Consciência climática. Sempre houve um certo apelo ecológico à idéia de distribuir poder de computação para clientes em uma área geográfica mais ampla, ao contrário de centralizar essa energia em instalações gigantescas, de hiperescala, e contar com links de fibra óptica de alta largura de banda para conectividade. A comercialização precoce da computação de ponta depende das impressões de senso comum dos ouvintes de que instalações menores consomem menos energia, mesmo coletivamente. Mas o júri ainda está fora de questão se isso é realmente verdade. Um estudo de 2018 realizado por pesquisadores da Universidade Técnica de Kosice, Eslováquia, usando implantações simuladas de computação de borda em um cenário de IdC, concluiu que a eficiência energética da borda depende quase que inteiramente da precisão e da eficiência dos cálculos ali realizados. Se tudo isso parece ser um sistema complexo demais para ser viável, tenha em mente que, em sua forma atual, o modelo de computação em nuvem pública pode não ser sustentável a longo prazo. Esse modelo teria subscritores continuando a empurrar aplicativos, fluxos de dados e fluxos de conteúdo através de tubos ligados a complexos de hiperescala cujas áreas de serviço abrangem estados, províncias e países inteiros – um sistema que provedores de voz sem fio nunca ousariam tentar.

Potenciais armadilhas

Não obstante, um mundo da computação inteiramente refeito no modelo de computação de ponta é tão fantástico – e tão remoto – como um mundo dos transportes que se desmamou inteiramente de combustíveis petrolíferos. A curto prazo, o modelo de computação de ponta enfrenta alguns obstáculos significativos, vários dos quais não serão totalmente fáceis de superar:

Se a localização, localização, localização importa novamente para a empresa, então todo o mercado de computação empresarial pode ser virado em seu ouvido. A natureza hiperescala, centralizada e sedenta de energia dos centros de dados em nuvem pode acabar trabalhando contra eles, à medida que modelos operacionais menores, mais ágeis e mais econômicos surgem – como dentes-de-leão, se tudo correr como planejado – em locais mais amplamente distribuídos.

“Acredito que o interesse em implementações de borda”, comentou Kurt Marko, diretor da empresa de análise tecnológica Marko Insights, em uma nota para a ZDNet, “é impulsionado principalmente pela necessidade de processar grandes quantidades de dados gerados por dispositivos, sensores e usuários ‘inteligentes’ – particularmente usuários móveis/sem fio. De fato, as taxas de dados e o rendimento das redes 5G, juntamente com a crescente utilização de dados pelos clientes, exigirão que as estações base móveis se tornem mini data centers”.

O que significa “computação de ponta”?

Em qualquer rede de telecomunicações, a borda é o maior alcance das suas instalações e serviços para os seus clientes. No contexto da computação de ponta, a ponta é o local no planeta onde os servidores podem fornecer funcionalidade aos clientes da forma mais conveniente.

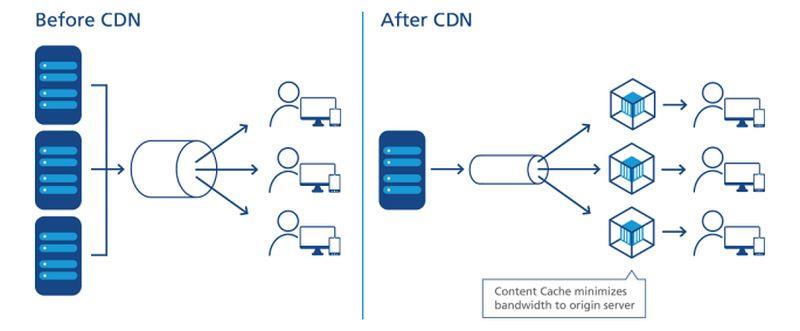

Como os CDNs abriram a trilha

Diagrama da relação entre os centros de dados e os dispositivos da Internet das coisas, conforme retratado pelo Industrial Internet Consortium.

Com respeito à Internet, a computação ou processamento é realizada por servidores – componentes geralmente representados por uma forma (por exemplo, uma nuvem) perto do centro ou ponto focal de um diagrama de rede. Os dados são coletados de dispositivos nas extremidades deste diagrama, e puxados em direção ao centro para processamento. Os dados processados, como o óleo de uma refinaria, são bombeados de volta em direção à borda para entrega. Os CDNs agilizam este processo agindo como “estações de enchimento” para os usuários em suas proximidades. O ciclo de vida típico do produto para serviços de rede envolve este processo de “ida e volta”, onde os dados são efetivamente minerados, enviados, refinados e enviados novamente. E, como em qualquer processo que envolva logística, o transporte leva tempo.

uma colocação figurativa precisa dos servidores CDN no processo de entrega de dados.

NTT Communictions

Importante, se o CDN reside sempre no centro do diagrama, depende de qual diagrama você está olhando. Se o provedor do CDN o desenhou, pode haver uma grande nuvem “CDN” no centro, com redes empresariais ao longo das bordas de um lado, e dispositivos de equipamento do usuário ao longo das outras bordas. Uma exceção vem da NTT, cujo diagrama simplificado mas mais preciso acima mostra servidores CDN se injetando entre o ponto de acesso aos dados e os usuários. Do ponto de vista dos produtores de dados ou conteúdo, ao contrário dos agentes de entrega, os CDNs residem no final da cadeia de suprimentos – o passo seguinte ao último para os dados antes que o usuário os receba.

Ao longo da última década, os principais fornecedores de CDN começaram a introduzir serviços informáticos que residem no ponto de entrega. Imagine se uma estação de abastecimento pudesse ser a sua própria refinaria, e você fica com a ideia. A proposta de valor para este serviço depende de os CDNs serem percebidos não no centro, mas no limite. Ele permite que alguns dados possam contornar a necessidade de transporte, apenas para serem processados e transportados de volta.

A tendência para a descentralização

Se os CDNs ainda não tinham provado a eficácia do edge computing como um serviço, eles pelo menos demonstraram o valor do mesmo como um negócio: As empresas pagarão prêmios para que alguns dados sejam processados antes que cheguem ao centro, ou “núcleo”, da rede.

“Estamos em um período bastante longo de centralização”, explicou Matt Baker, vice-presidente sênior de estratégia e planejamento da Dell Technologies, durante uma coletiva de imprensa em fevereiro passado. “E à medida que o mundo procura oferecer experiências digitais cada vez mais em tempo real através de suas iniciativas de transformação digital, a capacidade de manter essa abordagem altamente centralizada de TI está começando a se fraturar bastante”.

Edge computing foi considerado um dos lucrativos e novos mercados viabilizados pela tecnologia sem fio 5G. Para que a transição global de 4G para 5G seja economicamente viável para muitas empresas de telecomunicações, a nova geração deve abrir novos e exploráveis canais de receita. 5G requer uma vasta e nova rede de conexões (ironicamente) com fio e fibra ótica para fornecer transmissores e estações rádio-base com acesso instantâneo a dados digitais (o backhaul). Como resultado, surge uma oportunidade para uma nova classe de provedores de serviços de computação implantar vários µDCs adjacentes a torres de rede de acesso via rádio (RAN), talvez ao lado ou compartilhando o mesmo prédio com estações rádio-base de telecomunicações. Esses centros de dados poderiam oferecer coletivamente serviços de computação em nuvem para selecionar clientes a taxas competitivas e com recursos comparáveis aos provedores de nuvem em hiperescala, como a Amazon, Microsoft Azure e Google Cloud Platform.

Idealmente, talvez depois de uma década ou mais de evolução, a computação de ponta traria serviços rápidos aos clientes tão próximos quanto suas estações rádio-base mais próximas. Precisaríamos de tubos de fibra óptica maciça para fornecer o backhaul necessário, mas a receita dos serviços de computação de ponta poderia, concebivelmente, financiar sua construção, permitindo que ela se pague por si mesma.

Objetivos de nível de serviço

Na análise final (se, de fato, alguma análise já foi final), o sucesso ou fracasso dos centros de dados nas bordas da rede será determinado pela sua capacidade de atender aos objetivos de nível de serviço (SLO). Estas são as expectativas dos clientes que pagam pelos serviços, conforme codificado em seus contratos de serviço. Os engenheiros têm métricas que utilizam para registrar e analisar o desempenho dos componentes da rede. Os clientes tendem a evitar essas métricas, optando, em vez disso, por favorecer o desempenho observável de suas aplicações. Se uma implementação de borda não for visivelmente mais rápida do que uma implementação em hiperescala, então a borda como conceito pode morrer na sua infância.

“Com o que nos preocupamos? É o tempo de resposta dos aplicativos”, explicou Tom Gillis, vice-presidente sênior de rede e segurança da VMware, durante uma conferência recente da empresa. “Se pudermos caracterizar como o aplicativo responde e observar os componentes individuais que trabalham para fornecer essa resposta de aplicativo, podemos realmente começar a criar essa infraestrutura auto-regenerativa”.

A redução da latência e a melhoria da velocidade de processamento (com servidores mais recentes dedicados a muito menos tarefas quantitativamente) deve beneficiar os SLOs. Alguns também apontaram como a ampla distribuição de recursos por uma área contribui para a redundância de serviços e até mesmo para a continuidade do negócio – que, pelo menos até a pandemia, eram percebidos como eventos de um ou dois dias, seguidos de períodos de recuperação.

Mas haverá fatores de equilíbrio, o mais importante dos quais tem a ver com a manutenção e a manutenção. Uma instalação típica do centro de dados Tier-2 pode ser mantida, em circunstâncias de emergência (como uma pandemia), por tão poucas quanto duas pessoas no local, com pessoal de suporte fora do local. Enquanto isso, um µDC é projetado para funcionar sem ter pessoal perpétuo. Suas funções de monitoramento embutidas enviam continuamente telemetria para um hub central, que teoricamente poderia estar na nuvem pública. Enquanto um µDC estiver reunindo seus SLOs, ele não precisa ser atendido pessoalmente.

Aqui é onde a viabilidade do modelo de computação de borda ainda tem que ser completamente testada. Com um contrato típico de provedor de centro de dados, um SLO é frequentemente medido pela rapidez com que o pessoal do provedor pode resolver um problema pendente. Normalmente, os tempos de resolução podem permanecer baixos quando o pessoal não tem que alcançar pontos problemáticos por caminhão. Para que um modelo de implantação de borda seja competitivo com um modelo de implantação de colocação, é melhor que seus recursos de remediação automatizada sejam assustadoramente bons.

A rede em camadas

Provedores de armazenamento de dados, hosts de aplicativos nativos da nuvem, provedores de serviços de Internet das coisas (IoT), fabricantes de servidores, trusts de investimento imobiliário (REIT) e fabricantes de caixas de servidores pré-montadas, estão todos pavimentando rotas expressas entre seus clientes e o que promete, para cada um deles, ser a borda.

O que todos eles realmente procuram é vantagem competitiva. A ideia de uma borda lança uma nova esperança nas perspectivas de um serviço premium – uma razão sólida e justificável para que certas classes de serviço comandem taxas mais elevadas do que outras. Se você leu ou ouviu em outro lugar que a vantagem pode eventualmente subsumir toda a nuvem, você pode entender agora que isso não faria muito sentido. Se tudo fosse premium, nada seria premium.

“A computação de ponta será aparentemente a solução tecnológica perfeita, e os capitalistas de risco dizem que será um mercado tecnológico multibilionário”, comentou Kevin Brown, CTO e vice-presidente sênior de inovação para o fornecedor de equipamentos de serviço de data center e fabricante de chassis de micro data center, Schneider Electric. “Ninguém realmente sabe o que é.”

Schneider Electric’s Kevin Brown: “Ninguém realmente sabe o que é.”

Brown reconheceu que o edge computing pode atribuir a sua história aos CDNs pioneiros, como a Akamai. Ainda assim, ele continuou, “você tem todas estas diferentes camadas – HPE tem a sua versão, Cisco tem a sua. . . Não podíamos dar sentido a nada disso”. A nossa visão do limite está realmente a tomar uma visão muito simplificada. No futuro, vai haver três tipos de centros de dados no mundo, com os quais você realmente tem que se preocupar”.

A imagem que Brown desenhou, durante um evento de imprensa na sede da empresa em Massachusetts, em fevereiro de 2019, é uma visão reemergente de uma Internet de três níveis, e é compartilhada por um número crescente de empresas de tecnologia. No modelo tradicional de duas camadas, os nós de camada 1 são restritos a peering com outros nós de camada 1, enquanto os nós de camada 2 lidam com a distribuição de dados em nível regional. Desde o início da Internet, existe uma designação para o Tier-3 – para acesso a um nível muito mais local. (Contraste isto com o esquema da Rede de Acesso Rádio celular, cuja distribuição do tráfego é de camada única).

“O primeiro ponto que você está se conectando à rede, é realmente o que consideramos o limite local”, explicou Brown. Mapeado na tecnologia de hoje, ele continuou, você pode encontrar uma das facilidades de computação de ponta de hoje em qualquer servidor empurrado para um rack improvisado em um armário de fiação.

“Para os nossos propósitos”, prosseguiu ele, “achamos que é aí que está a acção”.

“O limite, durante anos, foram os hotéis Tier-1 como o Equinix e o CoreSite. Basicamente, eles iriam colocar uma rede conectada a outra, e isso era considerado uma borda”, explicou Wen Temitim, CTO do provedor de serviços de infra-estrutura StackPath. “Mas o que estamos vendo, com todas as diferentes mudanças no uso com base no comportamento do consumidor, e com o COVID-19 e trabalhando a partir de casa, é uma nova e mais profunda vantagem que está se tornando mais relevante com os prestadores de serviços”.

Localizando a borda em um mapa

Edge computing é um esforço para trazer a qualidade do serviço (QoS) de volta para a discussão da arquitetura e serviços do data center, já que as empresas decidem não apenas quem irá fornecer seus serviços, mas também onde.

A “tecnologia de ponta operacional”

Fabricante de equipamentos de data center HPE – um grande investidor em computação de ponta – acredita que o próximo salto gigantesco em infra-estrutura operacional será coordenado e liderado por funcionários e empreiteiros que podem não ter muito, ou nenhum, investimento pessoal ou treinamento em hardware e infra-estrutura – pessoas que, até agora, têm sido em grande parte encarregadas da manutenção, manutenção e suporte de software. Sua empresa chama a competência para esta classe de tecnologia operacional de pessoal (OT). Ao contrário daqueles que percebem a TI e as operações convergindo de uma forma ou de outra de “DevOps”, a HPE percebe três classes de clientes de computação de ponta. Não só cada uma destas classes, em sua visão, manterá sua própria plataforma de computação de borda, mas a geografia destas plataformas se separará umas das outras, não convergirá, como mostra este diagrama da HPE.

Aqui, existem três classes distintas de clientes, cada uma das quais o HPE dividiu o seu próprio segmento da borda em geral. A classe OT aqui se refere a clientes mais propensos a designar gerentes para a computação de ponta que têm menos experiência direta com TI, principalmente porque seus principais produtos não são informação ou comunicação em si. Essa classe é rateada como uma “borda OT”. Quando uma empresa tem mais investimento direto em informação como indústria, ou depende muito da informação como componente do seu negócio, a HPE atribui a ela uma “vantagem em TI”. No meio, para aqueles negócios que estão geograficamente dispersos e dependentes da logística (onde a informação tem um componente mais lógico) e, portanto, a Internet das Coisas, HPE lhe dá uma “borda de TI”.

rede tripartida da Dell

Em 2017, a Dell Technologies ofereceu pela primeira vez a sua topologia de três níveis para o mercado informático em geral, dividindo-a em “core”, “cloud” e “edge”. Como este slide de uma apresentação inicial da Dell indica, esta divisão parecia radicalmente simples, pelo menos no início: Os ativos de TI de qualquer cliente poderiam ser divididos, respectivamente, em 1) o que ele possui e mantém com seu próprio pessoal; 2) o que ele delega a um provedor de serviços e o contrata para manter; e 3) o que ele distribui além de suas instalações domésticas no campo, para ser mantido por profissionais de operações (que podem ou não ser terceirizados).

Em uma apresentação para a Linux Foundation’s Embedded Linux Conference Europe, CTO para IoT e Edge Computing Jason Shepherd fez este simples caso: Como muitos dispositivos e appliances de rede estão sendo planejados para o IoT, será tecnologicamente impossível centralizar seu gerenciamento, inclusive se nos alistarmos na nuvem pública.

“Minha esposa e eu temos três gatos”, disse Shepherd ao seu público. “Temos maior capacidade de armazenamento em nossos telefones, para que pudéssemos enviar vídeos de gatos para frente e para trás”.

“Cat videos explain the need for edge computing”, ele continuou. “Se eu postar um dos meus vídeos online, e ele começar a receber hits, eu tenho que armazená-lo em cache em mais servidores, bem no fundo da nuvem. Se ficar viral, então eu tenho que mover esse conteúdo o mais próximo possível dos assinantes para que eu o consiga. Como um telco, ou como Netflix ou o que quer que seja, o mais próximo que posso chegar é na borda da nuvem – no fundo das minhas torres de celular, esses pontos-chave na Internet. Este é o conceito da MEC, Multi-access Edge Computing – trazendo o conteúdo mais próximo dos assinantes. Bem, agora, se eu tenho bilhões de pessoas conectadas, eu virei completamente o paradigma, e em vez de coisas tentando puxar para baixo, eu tenho todos esses dispositivos tentando empurrar para cima. Isso faz com que você tenha que empurrar o computador ainda mais para baixo.”

A emergente ‘nuvem de borda’

Desde a estreia mundial do gatinho assustado do Shepherd, o conceito de borda da Dell endureceu um pouco, desde uma montagem de camadas nuances até mais de uma ética básica de descentralização.

“Nós vemos a borda como realmente sendo definida não necessariamente por um lugar específico ou uma tecnologia específica”, disse Matt Baker da Dell em fevereiro passado. “Em vez disso, é uma complicação para a implantação existente de TI, pois estamos cada vez mais descentralizando nossos ambientes de TI, estamos descobrindo que estamos colocando soluções de infraestrutura de TI, software, etc., em ambientes cada vez mais restritos”. Um centro de dados é um ambiente sem restrições; você o constrói de acordo com a especificação que você gosta, você pode resfriá-lo adequadamente, há muito espaço. Mas à medida que colocamos mais e mais tecnologia no mundo à nossa volta, para facilitar a entrega destas experiências digitais em tempo real, encontramo-nos em locais que são desafiados de alguma forma”.

As redes do campus, disse Baker, incluem equipamentos que tendem a ser empoeirados e sujos, além de terem conectividade de baixa largura de banda. Os ambientes de telecomunicações muitas vezes incluem racks de profundidade muito curta que requerem uma população de processadores de densidade muito alta. E nos locais mais distantes do mapa, há uma escassez de mão-de-obra qualificada em TI, “o que coloca maior pressão sobre a capacidade de gerenciar ambientes altamente distribuídos em uma rede mãos-livres e não-tripulados”.

Não obstante, cabe a um número crescente de clientes processar os dados mais perto do ponto onde eles são avaliados ou criados pela primeira vez, argumentou ele. Isso coloca a localização da “borda”, por volta de 2020, em qualquer ponto do mapa onde você encontrará dados, por falta de uma melhor descrição, pegando fogo.

StackPath’s Temitim acredita que esse ponto é um conceito emergente chamado de nuvem de borda – efetivamente uma coleção virtual de implantações de múltiplas bordas em uma única plataforma. Esta plataforma seria inicialmente comercializada para distribuidores de vídeo multicanal (MVPDs, geralmente empresas de cabo estabelecidas, mas também algumas telcos) que procuram possuir suas próprias redes de distribuição, e cortar custos a longo prazo. Mas como uma fonte de receita adicional, estes fornecedores poderiam então oferecer serviços em nuvem pública, como aplicações SaaS ou mesmo hospedagem de servidores virtuais, em nome de clientes comerciais.

Tal mercado de “nuvens de borda” poderia competir diretamente contra os centros de dados Tier-2 e Tier-3 de tamanho médio do mundo. Uma vez que as operadoras dessas instalações são tipicamente clientes premium de suas respectivas regiões, essas operadoras poderiam perceber a nuvem de borda como uma ameaça competitiva aos seus próprios planos para a 5G Wireless. Na verdade, é, como diz um fornecedor de infra-estrutura de ponta, uma “pegada física de terra”. E a agarração começou agora mesmo.

Aprenda mais – Da CBS Interactive Network

- Faz da computação de ponta um investimento chave para 2020 por Forrester Research