- Samenvatting

- De huidige topologie van bedrijfsnetwerken

- Potentiële voordelen

- Potentiële valkuilen

- Wat betekent “edge computing”?

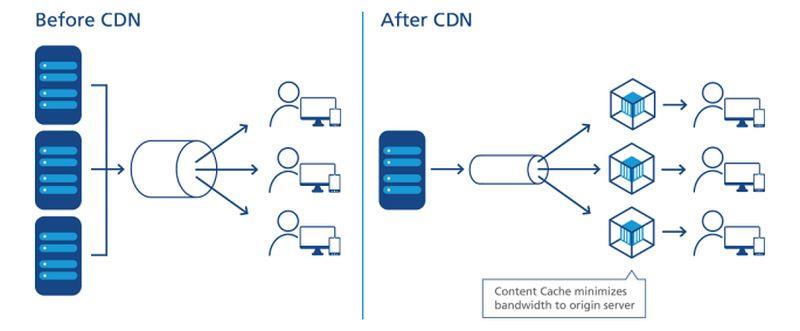

- Hoe CDN’s het pad hebben geëffend

- De trend naar decentralisatie

- Service-level objectives

- Het gelaagde netwerk

- Het lokaliseren van de edge op een kaart

- De “operationele technologische rand”

- Het drieledige netwerk van Dell

- De opkomende ‘edge cloud’

- Meer informatie – Van het CBS Interactive Network

- Elders

Samenvatting

Aan de rand van elk netwerk zijn er mogelijkheden om servers, processors en dataopslagarrays zo dicht mogelijk bij de mensen te plaatsen die er het beste gebruik van kunnen maken. Waar je de afstand kunt verkleinen, omdat de snelheid van elektronen in wezen constant is, minimaliseer je de latency. Een netwerk dat is ontworpen om aan de rand te worden gebruikt, benut deze minimale afstand om de service te versnellen en waarde te genereren.

In een modern communicatienetwerk dat is ontworpen voor gebruik aan de rand – bijvoorbeeld een draadloos 5G-netwerk – zijn er twee mogelijke strategieën aan het werk:

- Datastromen, audio en video kunnen sneller en met minder pauzes (bij voorkeur helemaal geen) worden ontvangen wanneer servers van hun gebruikers worden gescheiden door een minimum aan tussenliggende routingpunten, of “hops”. Content delivery networks (CDN) van providers als Akamai, Cloudflare en NTT Communications zijn rond deze strategie opgebouwd.

- Toepassingen kunnen sneller worden verwerkt wanneer de processors ervan zich dichter bij de plaats bevinden waar de gegevens worden verzameld. Dit geldt met name voor toepassingen op het gebied van logistiek en grootschalige productie, maar ook voor het Internet of Things (IoT), waarbij sensoren of apparaten die gegevens verzamelen talrijk en sterk gedistribueerd zijn.

Afhankelijk van de toepassing kunnen deze servers, wanneer een van beide of beide edge-strategieën worden gebruikt, aan de ene of de andere kant van het netwerk terechtkomen. Omdat het internet niet is opgebouwd zoals het oude telefoonnetwerk, is “dichterbij” in termen van routering niet noodzakelijkerwijs dichterbij in geografische afstand. En afhankelijk van het aantal verschillende soorten dienstverleners waarmee uw organisatie contracten heeft afgesloten – aanbieders van openbare cloudtoepassingen (SaaS), aanbieders van apps-platforms (PaaS), aanbieders van gehuurde infrastructuur (IaaS), content delivery-netwerken – kunnen er meerdere stukken IT-vastgoed zijn die met elkaar wedijveren om “the edge” te zijn op een bepaald moment.

Binnenin een microdatacenterkast van Schneider Electric

Scott Fulton

De huidige topologie van bedrijfsnetwerken

Er zijn drie plaatsen waar de meeste bedrijven hun eigen toepassingen en diensten implementeren en beheren:

- On-premises, waar datacenters meerdere rekken met servers huisvesten, waar ze zijn uitgerust met de middelen die nodig zijn om ze van stroom te voorzien en te koelen, en waar speciale connectiviteit is met externe bronnen

- Colocatiefaciliteiten, waar apparatuur van klanten wordt gehost in een volledig beheerd gebouw waar stroom, koeling, en connectiviteit als diensten worden geleverd

- Cloud service providers, waar de infrastructuur van de klant tot op zekere hoogte kan worden gevirtualiseerd en diensten en toepassingen per gebruik worden geleverd, zodat de activiteiten als operationele uitgaven kunnen worden geboekt in plaats van als kapitaaluitgaven

De architecten van edge computing zouden hun ontwerp als een vierde categorie aan deze lijst willen toevoegen: Een ontwerp dat gebruik maakt van de draagbaarheid van kleinere, containervoorzieningen met kleinere, meer modulaire servers, om de afstanden tussen het verwerkingspunt en het verbruikspunt van functionaliteit in het netwerk te verkleinen. Als hun plannen slagen, willen ze het volgende bereiken:

Potentiële voordelen

- Minimale latency. Het probleem met cloud computing-diensten is tegenwoordig dat ze traag zijn, vooral voor werklasten die op kunstmatige intelligentie zijn gebaseerd. Dit maakt de cloud in feite ongeschikt voor serieus gebruik in deterministische toepassingen, zoals realtime voorspellingen van effectenmarkten, autonome voertuigbesturing en verkeersroutering. Processoren die in kleine datacenters worden gestationeerd, dichter bij de plaats waar hun processen zullen worden gebruikt, zouden nieuwe markten voor computerdiensten kunnen openen die cloudproviders tot nu toe niet hebben kunnen bedienen. In een IoT-scenario, waar clusters van op zichzelf staande apparaten die gegevens verzamelen wijd verspreid zijn, kan de verwerkingstijd aanzienlijk worden verbeterd door processors zelfs dichter bij subgroepen of clusters van deze apparaten te plaatsen, waardoor realtime analyses op een veel granulairder niveau haalbaar worden.

- Vereenvoudigd onderhoud. Voor een onderneming die niet veel moeite heeft om een vloot vrachtwagens of onderhoudsvoertuigen naar locaties ter plaatse te sturen, zijn micro-datacenters (µDC) ontworpen voor maximale toegankelijkheid, modulariteit en een redelijke mate van draagbaarheid. Het zijn compacte behuizingen, sommige klein genoeg om in de achterbak van een pick-up truck te passen, die net genoeg servers kunnen ondersteunen voor het hosten van tijdkritische functies, die dichter bij hun gebruikers kunnen worden ingezet. Voor een gebouw dat momenteel zijn datacenters in de kelder huisvest, van stroom voorziet en koelt, zou de vervanging van die hele operatie door drie of vier µDC’s ergens op de parkeerplaats zelfs een verbetering kunnen zijn.

- Goedkopere koeling. Voor grote datacentercomplexen kunnen de maandelijkse kosten van de elektriciteit die wordt gebruikt voor koeling gemakkelijk hoger zijn dan de kosten van de elektriciteit die wordt gebruikt voor verwerking. De verhouding tussen deze twee wordt de effectiviteit van het stroomverbruik (PUE) genoemd. Soms is dit de basismaatstaf voor datacenterefficiëntie (hoewel de laatste jaren uit onderzoek is gebleken dat minder IT-operators weten wat deze verhouding eigenlijk betekent). Theoretisch kan het een bedrijf minder kosten om meerdere kleinere datacenterruimten te koelen en te conditioneren dan één grote datacenterruimte. Bovendien kunnen de kosten per kilowatt over de hele linie dalen voor dezelfde serverracks die in meerdere kleine faciliteiten worden gehost in plaats van in één grote, vanwege de eigenaardige manieren waarop sommige elektriciteitsvoorzieningsgebieden met facturering omgaan. In een door Schneider Electric gepubliceerde whitepaper uit 2017 zijn alle belangrijke en minder belangrijke kosten beoordeeld die gepaard gaan met het bouwen van traditionele en microdatacenters. Terwijl een onderneming iets minder dan 7 miljoen dollar aan kapitaaluitgaven zou kunnen doen voor het bouwen van een traditionele faciliteit van 1 MW, zou het iets meer dan 4 miljoen dollar uitgeven om 200 faciliteiten van 5 KW te faciliteren.

- Klimaatbewustzijn. Het idee om computercapaciteit te distribueren naar klanten in een groter geografisch gebied heeft altijd al een zekere ecologische aantrekkingskracht gehad, in tegenstelling tot het centraliseren van die capaciteit in gigantische, hyperscale faciliteiten en het gebruik van glasvezelverbindingen met hoge bandbreedte voor de connectiviteit. De eerste marketing voor edge computing is gebaseerd op het gezond verstand van de luisteraars dat kleinere faciliteiten minder stroom verbruiken, zelfs collectief. Maar de jury is er nog niet over uit of dat ook echt waar is. Een studie uit 2018 van onderzoekers van de Technische Universiteit van Kosice, Slowakije , met gesimuleerde edge computing-implementaties in een IoT-scenario, concludeerde dat de energie-efficiëntie van edge bijna volledig afhangt van de nauwkeurigheid en efficiëntie van de berekeningen die er worden uitgevoerd. Als dit alles klinkt als een systeem dat te complex is om haalbaar te zijn, bedenk dan dat het publieke cloud computing-model in zijn huidige vorm op de lange termijn wellicht niet houdbaar is. In dat model zouden abonnees toepassingen, datastromen en contentstromen moeten blijven pushen via pijpen die zijn verbonden met hyperscale complexen waarvan de servicegebieden hele staten, provincies en landen omvatten – een systeem dat aanbieders van draadloze spraak nooit hadden durven uitproberen.

Potentiële valkuilen

Niettemin is een computerwereld die volledig is herschapen in het edge computing-model ongeveer net zo fantastisch – en net zo ver weg – als een transportwereld die zich volledig heeft gesaneerd van aardoliebrandstoffen. Op de korte termijn stuit het edge computing-model op een aantal belangrijke obstakels, waarvan er verschillende niet gemakkelijk te overwinnen zullen zijn:

- Beschikbaarheid op afstand van driefasenstroom. Servers die op afstand cloud-achtige diensten kunnen leveren aan commerciële klanten, ongeacht waar ze zich bevinden, hebben krachtige processors en in-memory gegevens nodig om multi-tenancy mogelijk te maken. Waarschijnlijk zonder uitzondering hebben zij toegang nodig tot hoogspanning, driefasige elektriciteit. Dat is uiterst moeilijk, zo niet onmogelijk, te verkrijgen op relatief afgelegen, landelijke locaties. (Gewone 120 V wisselstroom is eenfasig.) Telco-basisstations hebben tot nu toe nooit dit stroomniveau nodig gehad, en als zij nooit bedoeld zijn om te worden gebruikt voor commercieel gebruik met meerdere huurders, dan hebben zij misschien toch nooit driefasige stroom nodig. De enige reden om het stroomsysteem aan te passen zou zijn als edge computing levensvatbaar is. Maar voor wijdverspreide Internet-of-Things-toepassingen, zoals de Mississippi-proef met hartmonitoren op afstand, zou een gebrek aan voldoende stroominfrastructuur opnieuw een scheiding kunnen veroorzaken tussen de “have’s” en de “have-not’s.”

- Het opdelen van servers in beschermde virtuele segmenten. Om de overgang naar 5G betaalbaar te houden, moeten telco’s extra inkomsten halen uit edge computing. Het idee om edge computing te koppelen aan 5G was dat commerciële en operationele functies naast elkaar konden bestaan op dezelfde servers – een concept dat werd geïntroduceerd door Central Office Re-architected as a Datacenter (CORD) (oorspronkelijk “Re-imagined”), waarvan één vorm nu wordt beschouwd als een belangrijke facilitator van 5G Wireless. Het probleem is dat het misschien niet eens legaal is om activiteiten die van fundamenteel belang zijn voor het telecommunicatienetwerk samen te laten werken met klantenfuncties op dezelfde systemen – de antwoorden hangen af van de vraag of wetgevers in staat zijn om de nieuwe definitie van “systemen” te doorgronden. Tot die dag (als die er ooit komt) heeft 3GPP (de industriële organisatie die de 5G-normen bepaalt) een concept aangenomen dat network slicing wordt genoemd, wat een manier is om netwerkservers van telco’s op te splitsen in virtuele servers op een zeer laag niveau, met een veel grotere scheiding dan in een typische virtualisatieomgeving van bijvoorbeeld VMware. Het is denkbaar dat een klantgericht netwerkdeel wordt ingezet aan de rand van het netwerk van de telco, om een beperkt aantal klanten te bedienen. Sommige grotere ondernemingen zouden echter liever hun eigen netwerkdeel in handen nemen, zelfs als dat betekent dat ze deze in hun eigen faciliteiten moeten implementeren – door de rand naar hun terrein te verplaatsen – dan te investeren in een nieuw systeem waarvan het waardevoorstel grotendeels op hoop is gebaseerd.

- Telco’s verdedigen hun thuisgebieden tegen lokale ontsnappingen. Als het 5G-radiotoegangsnetwerk (RAN) en de daaraan gekoppelde glasvezelkabels moeten worden gebruikt voor commerciële klantendiensten, moet er een soort gateway zijn om het verkeer van particuliere klanten af te scheiden van het telcoverkeer. De architectuur voor een dergelijke gateway bestaat reeds, en is formeel goedgekeurd door 3GPP. Het heet local breakout, en het maakt ook deel uit van de officiële verklaring van het ETSI normalisatie-orgaan voor multi-access edge computing (MEC). Dus technisch gezien is dit probleem opgelost. Het probleem is dat bepaalde telco’s er belang bij kunnen hebben te voorkomen dat het klantenverkeer wordt afgeleid van het traject dat het normaal zou volgen: naar hun eigen datacentra. De huidige internet-netwerktopologie heeft drie lagen: Tier-1 service providers peeren alleen met elkaar, terwijl Tier-2 ISP’s typisch klantgericht zijn. De derde laag biedt ruimte voor kleinere, regionale ISP’s op een meer lokaal niveau. Edge computing op wereldschaal zou de katalysator kunnen worden voor openbare cloud-achtige diensten, aangeboden door ISP’s op lokaal niveau, misschien via een soort “winkelketen”. Maar dat is in de veronderstelling dat de telco’s, die Tier-2 beheren, bereid zijn om inkomend netwerkverkeer gewoon naar een derde tier te laten gaan, waardoor concurrentie mogelijk wordt op een markt die zij heel gemakkelijk voor zichzelf zouden kunnen opeisen.

Als locatie, locatie, locatie weer belangrijk wordt voor de onderneming, dan kan de hele markt voor enterprise computing op zijn kop worden gezet. De hyperscale, gecentraliseerde en energieverslindende aard van clouddatacenters kan uiteindelijk in hun nadeel werken, omdat kleinere, behendigere en kosteneffectievere bedrijfsmodellen als paddestoelen uit de grond schieten – als alles volgens plan verloopt – op breder verspreide locaties.

“Ik geloof dat de belangstelling voor edge-implementaties,” merkte Kurt Marko, principal van technologie-analysebedrijf Marko Insights, in een notitie aan ZDNet, “voornamelijk wordt gedreven door de noodzaak om enorme hoeveelheden gegevens te verwerken die worden gegenereerd door ‘slimme’ apparaten, sensoren en gebruikers – met name mobiele/draadloze gebruikers. De datasnelheden en doorvoer van 5G-netwerken, samen met het escalerende datagebruik van klanten, zullen inderdaad vereisen dat mobiele basisstations mini-datacenters worden.”

Wat betekent “edge computing”?

In elk telecommunicatienetwerk is de edge het verste bereik van zijn faciliteiten en diensten richting zijn klanten. In de context van edge computing is de edge de locatie op de planeet waar servers het snelst functionaliteit aan klanten kunnen leveren.

Hoe CDN’s het pad hebben geëffend

Diagram van de relatie tussen datacenters en Internet-of-Things-apparaten, zoals afgebeeld door het Industrial Internet Consortium.

Wat het internet betreft, wordt het reken- of verwerkingsproces uitgevoerd door servers – componenten die gewoonlijk worden weergegeven door een vorm (bijvoorbeeld een wolk) in de buurt van het centrum of het brandpunt van een netwerkdiagram. Gegevens worden verzameld van apparaten aan de randen van dit diagram, en naar het centrum getrokken voor verwerking. De verwerkte gegevens worden, zoals olie uit een raffinaderij, teruggepompt naar de rand voor levering. CDN’s versnellen dit proces door te fungeren als “vulstations” voor gebruikers in hun omgeving. De typische productlevenscyclus voor netwerkdiensten omvat dit “rondreis”-proces, waarbij gegevens effectief worden gedolven, verzonden, geraffineerd en opnieuw verzonden. En zoals bij elk logistiek proces kost transport tijd.

Een nauwkeurige figuratieve plaatsing van CDN-servers in het gegevensleveringsproces.

NTT Communictions

Belangrijk is dat de vraag of het CDN zich altijd in het midden van het diagram bevindt, afhangt van wiens diagram je bekijkt. Als de CDN-provider het heeft opgesteld, is het mogelijk dat er een grote “CDN”-wolk in het midden staat, met bedrijfsnetwerken langs de randen van de ene kant en apparaten voor gebruikers langs de andere randen. Een uitzondering komt van NTT, wiens vereenvoudigde maar meer accurate diagram hierboven CDN-servers toont die zichzelf injecteren tussen het punt van gegevenstoegang en gebruikers. Vanuit het perspectief van de producenten van gegevens of inhoud, in tegenstelling tot de leveringsagenten, bevinden CDN’s zich aan het einde van de leveringsketen – de op één na laatste stap voor gegevens voordat de gebruiker ze ontvangt.

In de loop van het afgelopen decennium zijn grote CDN-aanbieders begonnen met de introductie van computing-diensten die zich op het afleverpunt bevinden. Stel je voor dat een benzinestation zijn eigen raffinaderij zou kunnen zijn, en je snapt het idee. Het waardevoorstel voor deze dienst hangt af van het feit dat CDN’s niet in het centrum, maar aan de rand worden gezien. Het stelt sommige gegevens in staat om de noodzaak van transport te omzeilen, alleen om te worden verwerkt en terug vervoerd.

De trend naar decentralisatie

Als CDN’s de effectiviteit van edge computing als dienst nog niet hadden bewezen, hebben ze in ieder geval de waarde ervan als bedrijf aangetoond: Ondernemingen zullen premies betalen om bepaalde gegevens te laten verwerken voordat ze het centrum, of de “kern”, van het netwerk bereiken.

“We hebben een vrij lange periode van centralisatie achter de rug,” verklaarde Matt Baker, senior vice president voor strategie en planning van Dell Technologies, tijdens een persconferentie afgelopen februari. “En nu de wereld via hun digitale transformatie-initiatieven steeds meer realtime digitale ervaringen wil leveren, begint het vermogen om vast te houden aan die sterk gecentraliseerde benadering van IT behoorlijk te breken.”

Edge computing is aangeprezen als een van de lucratieve, nieuwe markten die haalbaar worden door 5G Wireless-technologie. Om de wereldwijde overgang van 4G naar 5G voor veel telecommunicatiebedrijven economisch haalbaar te maken, moet de nieuwe generatie nieuwe, exploiteerbare inkomstenkanalen openen. 5G vereist een uitgebreid, nieuw netwerk van (ironisch genoeg) bekabelde, glasvezelverbindingen om zenders en basisstations te voorzien van onmiddellijke toegang tot digitale gegevens (de backhaul). Als gevolg hiervan ontstaat er een kans voor een nieuwe klasse aanbieders van computerdiensten om meerdere µDC’s in te zetten naast torens van het radiotoegangsnetwerk (RAN), misschien naast, of in hetzelfde gebouw als, basisstations van telco’s. Deze datacenters zouden gezamenlijk cloud computing-diensten kunnen aanbieden aan geselecteerde klanten tegen tarieven die concurrerend zijn met, en functies die vergelijkbaar zijn met, hyperscale cloud-aanbieders zoals Amazon, Microsoft Azure, en Google Cloud Platform.

Op termijn, misschien na een tiental jaren van evolutie, zou edge computing snelle diensten kunnen brengen naar klanten zo dicht mogelijk bij hun dichtstbijzijnde draadloze basisstations. We zouden enorme glasvezelbuizen nodig hebben om de noodzakelijke backhaul te leveren, maar de inkomsten uit edge computing-diensten zouden denkbaar de aanleg ervan kunnen financieren, waardoor het zichzelf zou kunnen terugbetalen.

Service-level objectives

In de uiteindelijke analyse (als er al ooit een definitieve analyse is geweest), zal het succes of falen van datacenters aan de randen van het netwerk worden bepaald door hun vermogen om te voldoen aan service-level objectives (SLO). Dit zijn de verwachtingen van klanten die voor diensten betalen, zoals vastgelegd in hun servicecontracten. Ingenieurs hebben metrieken die zij gebruiken om de prestaties van netwerkcomponenten vast te leggen en te analyseren. Klanten hebben de neiging om deze metingen te vermijden en kiezen in plaats daarvan voor de waarneembare prestaties van hun applicaties. Als een edge-implementatie niet merkbaar sneller is dan een hyperscale-implementatie, dan kan het edge-concept in zijn kinderschoenen komen te staan.

“Waar maken we ons druk om? De reactietijd van applicaties”, verklaarde Tom Gillis, senior vice president networking en security van VMware, tijdens een recente bedrijfsconferentie. “Als we kunnen karakteriseren hoe de applicatie reageert en kunnen kijken naar de individuele componenten die werken om die applicatiereactie te leveren, kunnen we daadwerkelijk beginnen met het creëren van die zelfherstellende infrastructuur.”

De vermindering van de latentie en de verbetering van de verwerkingssnelheid (met nieuwere servers die kwantitatief voor veel minder taken worden ingezet) zouden in het voordeel van SLO’s moeten spelen. Sommigen hebben er ook op gewezen hoe de brede spreiding van de middelen over een gebied bijdraagt tot de redundantie van de dienstverlening en zelfs tot de bedrijfscontinuïteit – die, althans tot aan de pandemie, werden beschouwd als gebeurtenissen van één of twee dagen, gevolgd door herstelperioden.

Maar er zijn evenwichtsfactoren, waarvan de belangrijkste te maken heeft met onderhoud en instandhouding. Een typische Tier-2 datacenterfaciliteit kan in noodsituaties (zoals een pandemie) worden onderhouden door slechts twee mensen ter plaatse, met ondersteunend personeel buiten de locatie. Ondertussen is een µDC ontworpen om te functioneren zonder voortdurend bemand te zijn. De ingebouwde bewakingsfuncties sturen voortdurend telemetrie naar een centrale hub, die zich in theorie in de publieke cloud zou kunnen bevinden. Zolang een µDC aan zijn SLO’s voldoet, hoeft het niet persoonlijk te worden bijgestaan.

Hier moet de levensvatbaarheid van het edge computing-model nog grondig worden getest. Bij een typisch contract met een datacenter provider wordt een SLO vaak afgemeten aan hoe snel het personeel van de provider een openstaand probleem kan oplossen. Doorgaans kan de oplostijd laag blijven als het personeel niet per vrachtwagen naar de probleempunten hoeft te rijden. Als een edge-implementatiemodel wil kunnen concurreren met een colocatie-implementatiemodel, dan moeten de geautomatiseerde remediëringscapaciteiten wel erg goed zijn.

Het gelaagde netwerk

Data storage providers, cloud-native applications hosts, Internet of Things (IoT) service providers, server manufacturers, real estate investment trusts (REIT), en pre-assembled server enclosure manufacturers, zijn allemaal bezig met het effenen van snelle routes tussen hun klanten en wat voor elk van hen de edge belooft te zijn.

Waar ze allemaal echt naar op zoek zijn, is concurrentievoordeel. Het idee van een voorsprong geeft nieuwe hoop op de vooruitzichten van premium service – een solide, gerechtvaardigde reden voor bepaalde klassen van dienstverlening om hogere tarieven te vragen dan anderen. Als u elders hebt gelezen of gehoord dat de edge uiteindelijk de hele cloud zou kunnen omvatten, begrijpt u nu misschien dat dit eigenlijk niet veel zin zou hebben. Als alles premium zou zijn, zou niets premium zijn.

“Edge computing wordt blijkbaar de perfecte technologische oplossing, en durfkapitalisten zeggen dat het een technologiemarkt van meerdere miljarden dollars wordt,” merkte Kevin Brown op, CTO en senior vice president voor innovatie bij de leverancier van datacenterserviceapparatuur, en fabrikant van microdatacenterchassis, Schneider Electric. “Niemand weet eigenlijk wat het is.”

Schneider Electric’s Kevin Brown: “Niemand weet eigenlijk wat het is.”

Brown erkende dat edge computing zijn geschiedenis kan toeschrijven aan de pionierende CDN’s, zoals Akamai. Toch, zo vervolgde hij, “heb je al die verschillende lagen – HPE heeft hun versie, Cisco heeft de hunne. . . We konden daar geen wijs uit worden. Onze kijk op de edge is echt een zeer vereenvoudigde kijk. In de toekomst zullen er drie soorten datacenters in de wereld zijn, waar je je echt zorgen over moet maken.”

Het beeld dat Brown schetste, tijdens een persevenement op het hoofdkantoor van het bedrijf in Massachusetts in februari 2019, is een opnieuw opkomende visie op een internet met drie niveaus, en wordt gedeeld door een groeiend aantal technologiebedrijven. In het traditionele two-tiered model zijn Tier-1 nodes beperkt tot peering met andere Tier-1 nodes, terwijl Tier-2 nodes de datadistributie op regionaal niveau verzorgen. Sinds het begin van het Internet is er een aanduiding voor Tier-3 – voor toegang op een veel lokaler niveau. (Dit in tegenstelling tot het cellulaire Radio Access Network, waar het verkeer op één niveau wordt gedistribueerd).

“Het eerste punt waarop je verbinding maakt met het netwerk, is wat wij echt als de lokale rand beschouwen,” legt Brown uit. Afgemeten aan de technologie van vandaag, ging hij verder, zou je een van de edge computing-faciliteiten van vandaag kunnen vinden in een server die in een geïmproviseerd rek in een bedradingskast is geschoven.

“Voor onze doeleinden,” ging hij verder, “denken wij dat daar de actie zit.”

“The edge, for years, was the Tier-1 carrier hotels like Equinix and CoreSite. Ze legden een netwerk aan een ander netwerk, en dat werd beschouwd als een edge”, legt Wen Temitim uit, CTO van edge infrastructure services provider StackPath. “Maar wat we zien, met alle verschillende veranderingen in het gebruik op basis van consumentengedrag, en met COVID-19 en thuiswerken, is een nieuwe en diepere edge die relevanter wordt voor serviceproviders.”

Het lokaliseren van de edge op een kaart

Edge computing is een poging om quality of service (QoS) terug te brengen in de discussie over datacenterarchitectuur en -diensten, nu ondernemingen niet alleen beslissen wie hun diensten zal leveren, maar ook waar.

De “operationele technologische rand”

Datacenterapparatuurmaker HPE – een belangrijke investeerder in edge computing – gelooft dat de volgende reuzensprong in de operationele infrastructuur zal worden gecoördineerd en geleid door personeel en contractanten die misschien niet veel of geen persoonlijke investeringen of training in hardware en infrastructuur hebben – mensen die tot nu toe voornamelijk belast waren met onderhoud, instandhouding en softwareondersteuning. Haar bedrijf noemt het werkterrein voor deze personeelscategorie operationele technologie (OT). In tegenstelling tot degenen die IT en operations zien convergeren in de een of andere vorm van “DevOps”, ziet HPE drie klassen van edge computing-klanten. Niet alleen zal elk van deze klassen, in zijn visie, zijn eigen edge computing-platform behouden, maar de geografie van deze platforms zal van elkaar scheiden, niet convergeren, zoals dit HPE-diagram weergeeft.

Courtesy HPE Hier zijn drie verschillende klassen klanten, die HPE elk heeft ingedeeld in een eigen segment van de edge in het algemeen. De OT-klasse hier verwijst naar klanten die meer kans hebben om managers toe te wijzen aan edge computing en die minder directe ervaring hebben met IT, voornamelijk omdat hun belangrijkste producten niet de informatie of communicatie zelf zijn. Die klasse krijgt een “OT edge” toegewezen. Wanneer een onderneming meer direct investeert in informatie als bedrijfstak, of in hoge mate afhankelijk is van informatie als onderdeel van haar activiteiten, kent HPE haar een “IT edge” toe. Daartussenin, voor die bedrijven die geografisch verspreid zijn en afhankelijk zijn van logistiek (waar de informatie een meer logische component heeft) en dus het Internet of Things, geeft HPE het een “IoT edge.”

Het drieledige netwerk van Dell

Courtesy Dell Technologies In 2017 bood Dell Technologies voor het eerst zijn drieledige topologie aan voor de computermarkt in het algemeen, waarbij deze werd onderverdeeld in “core,” “cloud,” en “edge.” Zoals deze dia uit een vroege Dell-presentatie aangeeft, leek deze indeling radicaal eenvoudig, althans in eerste instantie: De IT-activa van elke klant konden respectievelijk worden verdeeld in 1) wat het bezit en onderhoudt met zijn eigen personeel; 2) wat het delegeert aan een serviceprovider en deze inhuurt om te onderhouden; en 3) wat het buiten zijn thuisfaciliteiten distribueert naar het veld, om te worden onderhouden door operationele professionals (die al dan niet kunnen worden uitbesteed).

In een presentatie van november 2018 voor de Linux Foundation’s Embedded Linux Conference Europe, maakte CTO voor IoT en Edge Computing Jason Shepherd deze eenvoudige casus: Aangezien er veel netwerkapparaten en -toestellen worden gepland voor IoT, zal het technologisch onmogelijk zijn om hun beheer te centraliseren, ook als we de openbare cloud inschakelen.

“Mijn vrouw en ik hebben drie katten,” vertelde Shepherd zijn publiek. “We kregen grotere opslagcapaciteiten op onze telefoons, zodat we kattenvideo’s heen en weer konden sturen.

Linux Foundation video “Kattenvideo’s verklaren de behoefte aan edge computing,” vervolgde hij. “Als ik een van mijn video’s online zet en er komen hits, dan moet ik hem op meerdere servers cachen, ver weg in de cloud. Als de video viraal gaat, moet ik die content zo dicht mogelijk bij de abonnees brengen als ik kan. Als telco, of als Netflix of wat dan ook, is het dichtstbijzijnde dat ik kan komen aan de rand van de cloud – aan de onderkant van mijn mobiele torens, deze sleutelpunten op het internet. Dit is het concept van MEC, Multi-access Edge Computing – inhoud dichter bij de abonnees brengen. Welnu, als ik nu miljarden aangesloten katbellers heb, heb ik het paradigma volledig omgedraaid, en in plaats van dingen naar beneden te trekken, heb ik nu al deze apparaten die naar boven proberen te duwen. Dat maakt dat je de compute nog verder naar beneden moet duwen.”

De opkomende ‘edge cloud’

Sinds de wereldpremière van Shepherd’s bange katje, is Dell’s concept van de edge enigszins verhard, van een genuanceerde assemblage van lagen naar meer een basis decentralisatie-ethiek.

“Wij zien de edge als echt gedefinieerd, niet noodzakelijkerwijs door een specifieke plaats of een specifieke technologie,” zei Dell’s Matt Baker afgelopen februari. “In plaats daarvan is het een complicatie voor de bestaande inzet van IT, omdat we onze IT-omgevingen steeds meer decentraliseren en we erachter komen dat we IT-infrastructuuroplossingen, software, enzovoort, in steeds beperktere omgevingen plaatsen. Een datacenter is een omgeving zonder beperkingen; je bouwt het volgens de specificaties die je wilt, je kunt het voldoende koelen, er is ruimte genoeg. Maar naarmate we meer en meer technologie in de wereld om ons heen plaatsen, om de levering van deze real-time digitale ervaringen te vergemakkelijken, bevinden we ons op locaties die op de een of andere manier worden uitgedaagd.”

Campusnetwerken, aldus Baker, bevatten apparatuur die stoffig en vies is, nog afgezien van de lage bandbreedte van connectiviteit. Telco-omgevingen hebben vaak racks met een zeer korte diepte die een processorbezetting met een zeer hoge dichtheid vereisen. En op de verste locaties op de kaart is er een tekort aan geschoolde IT-arbeid, “wat meer druk legt op het vermogen om sterk gedistribueerde omgevingen te beheren in een hands-off, onbemand .”

Niettemin is het de plicht van een groeiend aantal klanten om gegevens te verwerken dichter bij het punt waar ze voor het eerst worden beoordeeld of gecreëerd, stelde hij. Dat plaatst de locatie van “de rand”, rond 2020, op een punt op de kaart waar data, bij gebrek aan een betere beschrijving, vlam vatten.

StackPath’s Temitim denkt dat dat punt een opkomend concept is dat de edge cloud wordt genoemd – in feite een virtuele verzameling van meerdere edge-implementaties in één enkel platform. Dit platform zou in eerste instantie op de markt worden gebracht voor multichannel video-distributeurs (MVPD’s, meestal gevestigde kabelmaatschappijen maar ook sommige telco’s) die hun eigen distributienetwerken willen bezitten en op de lange termijn kosten willen besparen. Maar als extra inkomstenbron zouden deze aanbieders dan namens commerciële klanten public-cloud-achtige diensten kunnen aanbieden, zoals SaaS-applicaties of zelfs virtuele serverhosting.

Een dergelijke “edge cloud”-markt zou rechtstreeks kunnen concurreren met ’s werelds middelgrote Tier-2 en Tier-3 datacenters. Aangezien de exploitanten van deze faciliteiten doorgaans premiumklanten zijn van de telco’s in hun respectieve regio’s, zouden deze telco’s de edge cloud kunnen zien als een bedreiging voor hun eigen plannen voor draadloze 5G. Het is echt, zoals een leverancier van edge-infrastructuur het formuleerde, een “fysieke landroof”. En het graaien is eigenlijk nog maar net begonnen.

Meer informatie – Van het CBS Interactive Network

- Hoe edge computing commercieel vastgoed kan vernieuwen, nieuw leven kan inblazen door Larry Dignan, Between the Lines

- Het is een race naar de rand, en het einde van cloud computing zoals we dat kennen door Scott M. Fulton, III, Scale

- Maak van edge computing een belangrijke investering voor 2020 door Forrester Research

Elders

- The Data Center That’s a Coffee Table door Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com