- Rezumat

- Topologia actuală a rețelelor de întreprindere

- Beneficii potențiale

- Potențiale capcane

- Ce înseamnă „edge computing”?

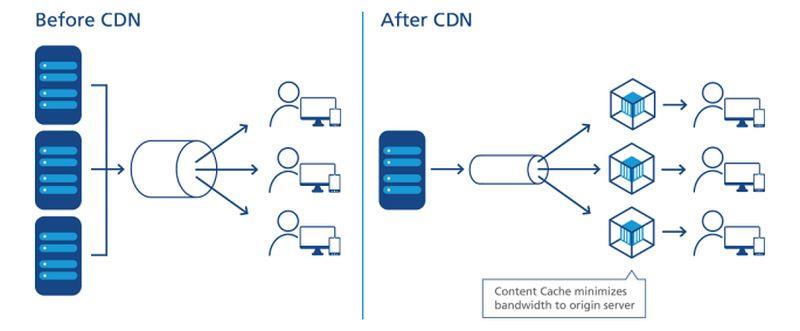

- Cum au deschis calea CDN-urile

- Tendința spre descentralizare

- Obiectivele la nivel de servicii

- Rețeaua stratificată

- Localizarea marginii pe o hartă

- „Marginea tehnologică operațională”

- Rețeaua tripartită a Dell

- „Norul de margine” emergent

- Aflați mai multe – De la CBS Interactive Network

- În altă parte

Rezumat

La marginea oricărei rețele, există oportunități de poziționare a serverelor, a procesoarelor și a rețelelor de stocare a datelor cât mai aproape de cei care le pot utiliza cel mai bine. Acolo unde se poate reduce distanța, viteza electronilor fiind în esență constantă, se minimizează latența. O rețea concepută pentru a fi utilizată la limită valorifică această distanță minimă pentru a accelera serviciile și a genera valoare.

Într-o rețea de comunicații modernă concepută pentru a fi utilizată la limită – de exemplu, o rețea fără fir 5G – există două strategii posibile la lucru:

- Fluxurile de date, audio și video pot fi recepționate mai rapid și cu mai puține pauze (de preferință deloc) atunci când serverele sunt separate de utilizatorii lor printr-un număr minim de puncte de rutare intermediare, sau „hamei”. Rețelele de livrare a conținutului (CDN) de la furnizori precum Akamai, Cloudflare și NTT Communications și sunt construite în jurul acestei strategii.

- Aplicațiile pot fi accelerate atunci când procesoarele lor sunt amplasate mai aproape de locul unde sunt colectate datele. Acest lucru este valabil în special pentru aplicațiile pentru logistică și producția pe scară largă, precum și pentru Internetul lucrurilor (IoT), unde senzorii sau dispozitivele de colectare a datelor sunt numeroase și foarte distribuite.

În funcție de aplicație, atunci când se utilizează una sau ambele strategii de margine, aceste servere pot ajunge, de fapt, la un capăt sau la celălalt al rețelei. Deoarece internetul nu este construit ca vechea rețea de telefonie, „mai aproape” din punct de vedere al oportunității de rutare nu este neapărat mai aproape ca distanță geografică. Și, în funcție de numărul de tipuri diferite de furnizori de servicii cu care organizația dvs. a încheiat contracte – furnizori de aplicații în cloud public (SaaS), furnizori de platforme de aplicații (PaaS), furnizori de infrastructură închiriată (IaaS), rețele de livrare de conținut – este posibil să existe mai multe suprafețe de terenuri IT care să concureze pentru a fi „marginea” la un moment dat.

În interiorul unui dulap de microcentru de date Schneider Electric

Scott Fulton

Topologia actuală a rețelelor de întreprindere

Există trei locuri în care majoritatea întreprinderilor tind să implementeze și să își gestioneze propriile aplicații și servicii:

- La fața locului, unde centrele de date găzduiesc mai multe rafturi de servere, unde sunt dotate cu resursele necesare pentru a le alimenta și răci și unde există o conectivitate dedicată la resurse externe

- Facilități de colocare, unde echipamentele clienților sunt găzduite într-o clădire complet gestionată, unde alimentarea, răcirea, și conectivitatea sunt furnizate ca servicii

- Furnizori de servicii cloud, unde infrastructura clienților poate fi virtualizată într-o anumită măsură, iar serviciile și aplicațiile sunt furnizate pe baza utilizării, permițând ca operațiunile să fie contabilizate ca cheltuieli operaționale mai degrabă decât ca cheltuieli de capital

Arhitecții de edge computing ar căuta să adauge proiectarea lor ca o a patra categorie la această listă: una care valorifică portabilitatea unor facilități mai mici, containerizate, cu servere mai mici și mai modulare, pentru a reduce distanțele dintre punctul de procesare și punctul de consum al funcționalității în rețea. Dacă planurile lor dau roade, ei caută să realizeze următoarele:

Beneficii potențiale

- Latență minimă. Problema cu serviciile de cloud computing în prezent este că sunt lente, în special pentru sarcinile de lucru bazate pe inteligență artificială. Acest lucru descalifică, în esență, cloud-ul pentru o utilizare serioasă în aplicațiile deterministe, cum ar fi prognoza în timp real a piețelor de valori mobiliare, pilotarea vehiculelor autonome și rutarea traficului de transport. Procesoarele staționate în centre de date mici, mai aproape de locul în care vor fi utilizate procesele lor, ar putea deschide noi piețe pentru serviciile de calcul pe care furnizorii de cloud computing nu au putut să le abordeze până în prezent. Într-un scenariu IoT, în care grupurile de aparate autonome de colectare a datelor sunt distribuite pe scară largă, faptul de a avea procesoare mai aproape chiar și de subgrupuri sau grupuri ale acestor aparate ar putea îmbunătăți considerabil timpul de procesare, făcând posibilă analiza în timp real la un nivel mult mai granular.

- Întreținere simplificată. Pentru o întreprindere care nu are prea multe probleme în a trimite o flotă de camioane sau vehicule de întreținere în locațiile de pe teren, microcentrele de date (µDC) sunt proiectate pentru accesibilitate maximă, modularitate și un grad rezonabil de portabilitate. Sunt incinte compacte, unele suficient de mici pentru a încăpea în spatele unei camionete, care pot susține doar suficiente servere pentru găzduirea funcțiilor critice din punct de vedere al timpului, care pot fi desfășurate mai aproape de utilizatorii lor. În mod conceptibil, pentru o clădire care în prezent găzduiește, alimentează și răcește activele centrului său de date în subsolul său, înlocuirea întregii operațiuni cu trei sau patru µDC undeva în parcare ar putea fi de fapt o îmbunătățire.

- Răcire mai ieftină. Pentru complexele mari de centre de date, costul lunar al energiei electrice utilizate pentru răcire poate depăși cu ușurință costul energiei electrice utilizate pentru procesare. Raportul dintre cele două se numește eficiența utilizării energiei (PUE). Uneori, aceasta a fost măsura de bază a eficienței centrelor de date (deși, în ultimii ani, sondajele au arătat că tot mai puțini operatori IT știu ce înseamnă de fapt acest raport). Teoretic, poate costa mai puțin pentru o întreprindere să răcească și să condiționeze mai multe spații mai mici ale unui centru de date decât unul mare. În plus, din cauza modalităților ciudate în care unele zone de servicii de electricitate gestionează facturarea, costul pe kilowatt poate scădea în general pentru aceleași rafturi de servere găzduite în mai multe spații mici decât într-unul mare. O carte albă din 2017 publicată de Schneider Electric a evaluat toate costurile majore și minore asociate cu construirea de centre de date tradiționale și microcentre de date. În timp ce o întreprindere ar putea suporta puțin sub 7 milioane de dolari în cheltuieli de capital pentru a construi o instalație tradițională de 1 MW, aceasta ar cheltui puțin peste 4 milioane de dolari pentru a facilita 200 de instalații de 5 KW.

- Conștiința climatică. Întotdeauna a existat un anumit farmec ecologic al ideii de distribuire a puterii de calcul către clienți pe o arie geografică mai largă, spre deosebire de centralizarea acestei puteri în instalații mamut, la scară uriașă, și care se bazează pe legături de fibră optică de mare lățime de bandă pentru conectivitate. Marketingul timpuriu pentru edge computing se bazează pe impresia de bun simț a ascultătorilor că instalațiile mai mici consumă mai puțină energie, chiar și în mod colectiv. Dar juriul încă nu a stabilit dacă acest lucru este într-adevăr adevărat. Un studiu realizat în 2018 de cercetătorii de la Universitatea Tehnică din Kosice, Slovacia , utilizând implementări simulate de edge computing într-un scenariu IoT, a concluzionat că eficiența energetică a edge computing-ului depinde aproape în întregime de precizia și eficiența calculelor efectuate acolo. Aceștia au constatat că, de fapt, cheltuielile generale suportate de calculele ineficiente ar fi amplificate de o programare proastă.

Dacă toate acestea sună ca un sistem prea complex pentru a fi fezabil, țineți cont de faptul că, în forma sa actuală, modelul de cloud computing public ar putea să nu fie sustenabil pe termen lung. Acest model ar trebui ca abonații să continue să împingă aplicații, fluxuri de date și fluxuri de conținut prin țevi conectate cu complexe hiperscale ale căror zone de servicii cuprind state, provincii și țări întregi – un sistem pe care furnizorii de servicii de voce wireless nu ar fi îndrăznit niciodată să îl încerce.

Potențiale capcane

Cu toate acestea, o lume a informaticii refăcută în întregime după modelul edge computing este la fel de fantastică – și la fel de îndepărtată – ca o lume a transporturilor care s-a înțărcat în întregime de combustibilii petrolieri. Pe termen scurt, modelul edge computing se confruntă cu câteva obstacole semnificative, dintre care câteva nu vor fi cu totul ușor de depășit:

- Disponibilitatea la distanță a energiei electrice trifazate. Serverele capabile să furnizeze servicii la distanță de tip cloud clienților comerciali, indiferent de locul în care se află, au nevoie de procesoare de mare putere și de date în memorie, pentru a permite multi-tenancy. Probabil fără excepție, acestea vor avea nevoie de acces la electricitate trifazică de înaltă tensiune. Acest lucru este extrem de dificil, dacă nu imposibil, de obținut în locații rurale relativ îndepărtate. (Curentul alternativ obișnuit de 120 V este monofazat.) Stațiile de bază Telco nu au necesitat niciodată până acum acest nivel de putere, iar dacă nu se intenționează ca acestea să fie folosite pentru o utilizare comercială cu mai mulți chiriași, atunci s-ar putea să nu aibă niciodată nevoie de curent trifazat, oricum. Singurul motiv pentru a moderniza sistemul de alimentare ar fi dacă edge computing este viabil. Dar pentru aplicațiile Internet-of-Things (Internetul lucrurilor) distribuite pe scară largă, cum ar fi testele efectuate de Mississippi pentru monitoarele cardiace de la distanță, lipsa unei infrastructuri energetice suficiente ar putea sfârși prin a diviza încă o dată „cei care au” de cei care nu au.”

- Sculptarea serverelor în felii virtuale protejate. Pentru ca tranziția 5G să fie accesibilă, companiile de telecomunicații trebuie să obțină venituri suplimentare din edge computing. Ceea ce a făcut ca ideea de a lega evoluția edge computing de 5G să fie legată de 5G a fost noțiunea că funcțiile comerciale și operaționale ar putea coexista pe aceleași servere – un concept introdus de Central Office Re-architected as a Datacenter (CORD) (inițial „Re-imagined”), una dintre formele sale fiind acum considerată un facilitator cheie al 5G Wireless. Problema este că s-ar putea să nu fie nici măcar legal ca operațiunile fundamentale pentru rețeaua de telecomunicații să coabiteze cu funcțiile clienților pe aceleași sisteme – răspunsurile depind de capacitatea legiuitorilor de a înțelege noua definiție a „sistemelor”. Până la acea zi (dacă va veni vreodată), 3GPP (organizația industrială care guvernează standardele 5G) a adoptat un concept numit „network slicing”, care este o modalitate de a decupla serverele rețelelor de telecomunicații în servere virtuale la un nivel foarte scăzut, cu o separare mult mai mare decât într-un mediu tipic de virtualizare de la, de exemplu, VMware. În mod conceptibil, o felie de rețea orientată spre client ar putea fi implementată la marginea rețelelor de telecomunicații, deservind un număr limitat de clienți. Cu toate acestea, unele întreprinderi mai mari ar prefera să se ocupe de propriile felii de rețea, chiar dacă acest lucru înseamnă să le implementeze în propriile instalații – mutând marginea în incinta lor – decât să investească într-un nou sistem a cărui propunere de valoare se bazează în mare parte pe speranță.

- Operatorii de telecomunicații care își apără teritoriile de origine de pătrunderile locale. Dacă rețeaua de acces radio 5G (RAN) și cablurile de fibră optică legate de aceasta vor fi valorificate pentru servicii comerciale pentru clienți, trebuie să existe un anumit tip de gateway pentru a sifona traficul clienților privați de la traficul telco. Arhitectura pentru un astfel de gateway există deja și a fost adoptată în mod oficial de 3GPP. Se numește „local breakout” și face parte, de asemenea, din declarația oficială a organismului de standardizare ETSI privind calculul de margine cu acces multiplu (MEC). Deci, din punct de vedere tehnic, această problemă a fost rezolvată. Problema este că anumite companii de telecomunicații ar putea fi interesate să împiedice devierea traficului clienților de la cursul pe care l-ar urma în mod normal: în propriile centre de date. Topologia actuală a rețelei Internet are trei niveluri: Furnizorii de servicii de nivel 1 au relații doar între ei, în timp ce furnizorii de servicii Internet de nivel 2 sunt de obicei orientați către clienți. Al treilea nivel permite existența unor furnizori de servicii Internet mai mici, regionali, la un nivel mai local. Edge computing la scară globală ar putea deveni catalizatorul pentru servicii publice de tip cloud, oferite de furnizorii de servicii de internet la nivel local, poate prin intermediul unui fel de „lanț de magazine”. Dar asta presupunând că operatorii de telecomunicații, care gestionează nivelul 2, sunt dispuși să lase pur și simplu traficul de intrare în rețea să fie împărțit într-un al treilea nivel, permițând concurența pe o piață pe care ar putea foarte ușor să o revendice doar pentru ei înșiși.

Dacă locația, locația, locația, locația contează din nou pentru întreprindere, atunci întreaga piață de informatică pentru întreprinderi poate fi întors pe dos. Caracterul hiperscalar, centralizat și avid de energie al centrelor de date în cloud ar putea sfârși prin a lucra împotriva lor, pe măsură ce modele de operare mai mici, mai agile și mai rentabile apar – ca niște păpădii, dacă totul decurge conform planului – în locații mai larg distribuite.

„Cred că interesul pentru implementările edge”, a remarcat Kurt Marko, director al firmei de analiză tehnologică Marko Insights, într-o notă pentru ZDNet, „este determinat în primul rând de necesitatea de a procesa cantități masive de date generate de dispozitive „inteligente”, senzori și utilizatori – în special utilizatori mobili/ fără fir. Într-adevăr, ratele și debitul de date ale rețelelor 5G, împreună cu escaladarea utilizării datelor de către clienți, vor necesita ca stațiile de bază mobile să devină mini-centre de date”.

Ce înseamnă „edge computing”?

În orice rețea de telecomunicații, marginea este cea mai îndepărtată distanță dintre instalațiile și serviciile sale și clienții săi. În contextul edge computing, marginea este locația de pe planetă în care serverele pot livra funcționalitatea către clienți în cel mai scurt timp.

Cum au deschis calea CDN-urile

Diagramă a relației dintre centrele de date și dispozitivele Internet-of-Things, așa cum este descrisă de Industrial Internet Consortium.

În ceea ce privește internetul, calculul sau procesarea este efectuată de servere – componente reprezentate, de obicei, printr-o formă (de exemplu, un nor) în apropierea centrului sau a punctului focal al unei diagrame de rețea. Datele sunt colectate de la dispozitivele de la marginile acestei diagrame și trase spre centru pentru procesare. Datele procesate, precum petrolul dintr-o rafinărie, sunt pompate înapoi spre margini pentru livrare. CDN-urile accelerează acest proces, acționând ca „stații de umplere” pentru utilizatorii din vecinătatea lor. Ciclul de viață tipic al produselor pentru serviciile de rețea implică acest proces „dus-întors”, în care datele sunt efectiv extrase, expediate, rafinate și expediate din nou. Și, ca în orice proces care implică logistică, transportul necesită timp.

O plasare figurativă precisă a serverelor CDN în procesul de livrare a datelor.

NTT Communictions

Important, dacă CDN-ul se află întotdeauna în centrul diagramei, depinde de diagrama la care vă uitați. Dacă a întocmit-o furnizorul CDN, este posibil să existe un nor mare „CDN” în centru, cu rețele de întreprindere de-a lungul marginilor unei laturi, iar dispozitivele echipamentelor utilizatorilor de-a lungul celorlalte margini. O excepție vine de la NTT, a cărei diagramă simplificată, dar mai precisă, de mai sus arată serverele CDN care se injectează între punctul de acces la date și utilizatori. Din punctul de vedere al producătorilor de date sau de conținut, spre deosebire de agenții de livrare, CDN-urile se află la capătul lanțului de aprovizionare – penultimul pas pentru date înainte ca utilizatorul să le primească.

De-a lungul ultimului deceniu, principalii furnizori CDN au început să introducă servicii de calcul care se află la punctul de livrare. Imaginați-vă dacă o stație de benzină ar putea fi propria sa rafinărie, și ați înțeles ideea. Propunerea de valoare pentru acest serviciu depinde de faptul că CDN-urile sunt percepute nu la centru, ci la margine. Aceasta permite ca unele date să ocolească necesitatea de transport, doar pentru a fi procesate și transportate înapoi.

Tendința spre descentralizare

Dacă CDN-urile nu au dovedit încă eficiența edge computing ca serviciu, au demonstrat cel puțin valoarea acestuia ca afacere: Întreprinderile vor plăti prime pentru ca unele date să fie procesate înainte de a ajunge în centrul, sau „nucleul”, rețelei.

„Am fost într-o perioadă destul de lungă de centralizare”, a explicat Matt Baker, vicepreședinte senior pentru strategie și planificare al Dell Technologies, în timpul unei conferințe de presă din februarie anul trecut. „Și, pe măsură ce lumea caută să ofere experiențe digitale din ce în ce mai mult în timp real prin inițiativele lor de transformare digitală, capacitatea de a menține această abordare foarte centralizată a IT-ului începe să se fractureze destul de mult.”

Edge computing a fost prezentată ca fiind una dintre piețele noi și profitabile, făcute posibile de tehnologia 5G Wireless. Pentru ca tranziția globală de la 4G la 5G să fie fezabilă din punct de vedere economic pentru multe companii de telecomunicații, noua generație trebuie să deschidă noi canale de venituri exploatabile. 5G necesită o nouă și vastă rețea (ironic) de conexiuni cablate, din fibră optică, pentru a furniza emițătoarelor și stațiilor de bază acces instantaneu la date digitale (backhaul). Ca urmare, apare o oportunitate pentru o nouă clasă de furnizori de servicii de calculatoare de a implementa mai multe µDC-uri adiacente turnurilor rețelei de acces radio (RAN), poate lângă sau în aceeași clădire cu stațiile de bază ale companiilor de telecomunicații. Aceste centre de date ar putea oferi în mod colectiv servicii de cloud computing unor clienți selecționați la tarife competitive și cu caracteristici comparabile cu cele ale furnizorilor de cloud la scară mare, cum ar fi Amazon, Microsoft Azure și Google Cloud Platform.

În cele din urmă, poate după un deceniu sau cam așa ceva de evoluție, edge computing ar aduce servicii rapide clienților la fel de aproape ca cele mai apropiate stații de bază wireless. Am avea nevoie de conducte masive de fibră optică pentru a furniza backhaul necesar, dar este de conceput că veniturile din serviciile de edge computing ar putea finanța construcția acestora, permițându-le să se autofinanțeze.

Obiectivele la nivel de servicii

În analiza finală (dacă, într-adevăr, vreo analiză a fost vreodată finală), succesul sau eșecul centrelor de date de la marginea rețelei va fi determinat de capacitatea lor de a îndeplini obiectivele la nivel de servicii (SLO). Acestea sunt așteptările clienților care plătesc pentru servicii, așa cum sunt codificate în contractele lor de servicii. Inginerii au metrici pe care le folosesc pentru a înregistra și analiza performanța componentelor rețelei. Clienții tind să evite aceste măsurători, alegând în schimb să favorizeze performanța observabilă a aplicațiilor lor. Dacă o implementare edge nu este vizibil mai rapidă decât o implementare hyperscale, atunci edge ca și concept poate muri în copilărie.

„Ce ne interesează? Este timpul de răspuns al aplicațiilor”, a explicat Tom Gillis, vicepreședinte senior al VMware pentru rețele și securitate, în timpul unei conferințe recente a companiei. „Dacă putem caracteriza modul în care răspunde aplicația și ne putem uita la componentele individuale care lucrează pentru a oferi acel răspuns al aplicației, putem începe de fapt să creăm acea infrastructură de auto-reparare.”

Reducerea latenței și îmbunătățirea vitezei de procesare (cu servere mai noi dedicate la mult mai puține sarcini din punct de vedere cantitativ) ar trebui să joace în beneficiul SLO-urilor. Unii au subliniat, de asemenea, modul în care distribuția largă a resurselor pe o zonă contribuie la redundanța serviciilor și chiar la continuitatea activității – care, cel puțin până la pandemie, erau percepute ca evenimente de una sau două zile, urmate de perioade de recuperare.

Dar vor exista și factori de echilibrare, dintre care cel mai important este cel legat de întreținere și mentenanță. O instalație tipică de centru de date de nivel 2 poate fi întreținută, în situații de urgență (cum ar fi o pandemie) de doar două persoane la fața locului, cu personal de sprijin în afara locului. Între timp, un µDC este conceput pentru a funcționa fără a avea personal permanent. Funcțiile sale de monitorizare integrate trimit în permanență telemetrie către un hub central, care, teoretic, ar putea fi în cloud-ul public. Atâta timp cât un µDC își îndeplinește SLO-urile, nu este necesar să fie asistat personal.

Aici este punctul în care viabilitatea modelului edge computing nu a fost încă testată temeinic. În cazul unui contract tipic cu un furnizor de centre de date, un SLO este adesea măsurat în funcție de rapiditatea cu care personalul furnizorului poate rezolva o problemă nerezolvată. De obicei, timpii de rezolvare pot rămâne scăzuți atunci când personalul nu trebuie să ajungă la punctele cu probleme cu camionul. Dacă se dorește ca un model de implementare de tip edge să fie competitiv cu un model de implementare colocation, ar fi bine ca capacitățile sale de remediere automată să fie extrem de bune.

Rețeaua stratificată

Furnizorii de stocare a datelor, gazdele aplicațiilor cloud-native, furnizorii de servicii Internet of Things (IoT), producătorii de servere, trusturile de investiții imobiliare (REIT) și producătorii de carcase de servere preasamblate, cu toții pavează rute expres între clienții lor și ceea ce promite, pentru fiecare dintre ei, să fie edge-ul.

Ce caută cu toții cu adevărat este avantajul competitiv. Ideea de avantaj dă o nouă speranță asupra perspectivelor serviciilor premium – un motiv solid și justificabil pentru ca anumite clase de servicii să impună tarife mai mari decât altele. Dacă ați citit sau ați auzit în altă parte că marginea ar putea, în cele din urmă, să subsumeze întregul cloud, s-ar putea să înțelegeți acum că acest lucru nu ar avea de fapt prea mult sens. Dacă totul ar fi premium, nimic nu ar fi premium.

„Edge computing se pare că va fi soluția tehnologică perfectă, iar capitaliștii de risc spun că va fi o piață tehnologică de mai multe miliarde de dolari”, a remarcat Kevin Brown, CTO și vicepreședinte senior pentru inovație al furnizorului de echipamente de servicii pentru centre de date și producător de șasiuri pentru microcentre de date, Schneider Electric. „Nimeni nu știe de fapt despre ce este vorba”.

Kevin Brown de la Schneider Electric: „Nimeni nu știe de fapt ce este.”

Brown a recunoscut că edge computing își poate atribui istoria CDN-urilor de pionierat, cum ar fi Akamai. Cu toate acestea, a continuat el, „aveți toate aceste straturi diferite – HPE are versiunea lor, Cisco o are pe a lor. . . Nu am reușit să înțelegem nimic din toate acestea. Punctul nostru de vedere cu privire la periferie are într-adevăr o viziune foarte simplificată. În viitor, vor exista trei tipuri de centre de date în lume, de care va trebui să vă faceți griji cu adevărat.”

Imaginea pe care Brown a desenat-o, în timpul unui eveniment de presă la sediul central al companiei din Massachusetts, în februarie 2019, este o viziune re-emergentă a unui internet pe trei niveluri și este împărtășită de un număr tot mai mare de firme de tehnologie. În modelul tradițional cu două niveluri, nodurile de nivel 1 sunt limitate la peering cu alte noduri de nivel 1, în timp ce nodurile de nivel 2 se ocupă de distribuția datelor la nivel regional. Încă de la începuturile internetului, a existat o denumire pentru nivelul 3 – pentru accesul la un nivel mult mai local. (Comparați acest lucru cu schema de rețea de acces radio celulară, a cărei distribuție a traficului se face pe un singur nivel).

„Primul punct în care te conectezi la rețea, este într-adevăr ceea ce noi considerăm marginea locală”, a explicat Brown. Cartografiat pe tehnologia de astăzi, a continuat el, ați putea găsi una dintre facilitățile de calcul de margine de astăzi în orice server înghesuit într-un rack improvizat într-un dulap de cabluri.

„Pentru scopurile noastre”, a continuat el, „credem că acolo este acțiunea”.

„Marginea, timp de ani de zile, a fost reprezentată de hotelurile operatorilor de nivel 1, cum ar fi Equinix și CoreSite. Practic, acestea suprapuneau o rețea care se conecta la alta, iar aceea era considerată o margine”, a explicat Wen Temitim, CTO al furnizorului de servicii de infrastructură de margine StackPath. „Dar ceea ce observăm, cu toate schimbările diferite în ceea ce privește utilizarea pe baza comportamentului consumatorilor și cu COVID-19 și lucrul de acasă, este o margine nouă și mai profundă care devine mai relevantă pentru furnizorii de servicii.”

Localizarea marginii pe o hartă

Edge computing este un efort de a readuce calitatea serviciilor (QoS) în discuția despre arhitectura și serviciile centrelor de date, pe măsură ce întreprinderile decid nu doar cine le va furniza serviciile, ci și unde.

„Marginea tehnologică operațională”

Producătorul de echipamente pentru centrele de date HPE – un investitor important în edge computing – consideră că următorul salt uriaș în infrastructura operațională va fi coordonat și condus de personal și contractori care s-ar putea să nu aibă prea multe, sau chiar deloc, investiții personale sau pregătire în hardware și infrastructură – oameni care, până acum, au fost în mare parte însărcinați cu întreținerea, mentenanța și asistența software. Compania sa numește domeniul de competență pentru această categorie de personal tehnologie operațională (OT). Spre deosebire de cei care percep convergența dintre IT și operațiuni într-o formă sau alta de „DevOps”, HPE percepe trei clase de clienți de edge computing. În opinia sa, nu numai că fiecare dintre aceste clase își va menține propria platformă de edge computing, dar geografia acestor platforme se va separa una de cealaltă, nu va converge, așa cum arată această diagramă HPE.

Aici, există trei clase distincte de clienți, fiecare dintre acestea fiind împărțită de HPE în propriul segment al edge-ului în general. Clasa OT se referă aici la clienții care au mai multe șanse de a desemna manageri pentru edge computing și care au mai puțină experiență directă în domeniul IT, în principal pentru că principalele lor produse nu sunt chiar informații sau comunicații. Această clasă este repartizată un „OT edge”. Atunci când o întreprindere are o investiție mai directă în informații ca industrie sau depinde în mare măsură de informații ca o componentă a activității sale, HPE îi atribuie o „margine IT”. Între cele două, pentru acele întreprinderi care sunt dispersate geografic și care depind de logistică (unde informația are o componentă mai mult logică) și, prin urmare, de Internetul lucrurilor, HPE îi atribuie o „margine IoT”.

Rețeaua tripartită a Dell

În 2017, Dell Technologies a oferit pentru prima dată topologia sa pe trei niveluri pentru piața de calcul la scară largă, împărțind-o în „core”, „cloud” și „edge”. După cum indică acest diapozitiv dintr-o primă prezentare Dell, această diviziune părea radical de simplă, cel puțin la început: Activele IT ale oricărui client ar putea fi împărțite, respectiv, în: 1) ceea ce deține și întreține cu propriul personal; 2) ceea ce deleagă unui furnizor de servicii și îl angajează pentru întreținere; și 3) ceea ce distribuie dincolo de facilitățile sale de acasă, pe teren, pentru a fi întreținut de profesioniști în operațiuni (care pot fi sau nu externalizați).

Într-o prezentare din noiembrie 2018 pentru Conferința Linux Embedded Linux Europe a Fundației Linux, CTO pentru IoT și Edge Computing, Jason Shepherd a prezentat acest caz simplu: La cât de multe dispozitive și aparate în rețea sunt planificate pentru IoT, va fi imposibil din punct de vedere tehnologic să centralizăm gestionarea lor, inclusiv dacă vom apela la cloudul public.

„Eu și soția mea avem trei pisici”, a spus Shepherd audienței sale. „Am obținut capacități de stocare mai mari pe telefoanele noastre, astfel încât să putem trimite videoclipuri cu pisici înainte și înapoi.

„Videoclipurile cu pisici explică nevoia de edge computing”, a continuat el. „Dacă postez unul dintre videoclipurile mele online și începe să primească vizualizări, trebuie să îl pun în cache pe mai multe servere, mult mai în spate, în cloud. Dacă devine viral, atunci trebuie să mut acel conținut cât mai aproape de abonați. În calitate de operator de telecomunicații sau de Netflix sau orice altceva, cel mai aproape pot ajunge este la marginea norului – în partea de jos a turnurilor mele de telefonie mobilă, în aceste puncte cheie de pe internet. Acesta este conceptul de MEC, Multi-access Edge Computing – aducerea conținutului mai aproape de abonați. Ei bine, acum, dacă am miliarde de apelanți de pisici conectate acolo, am răsturnat complet paradigma și, în loc ca lucrurile să încerce să tragă în jos, am toate aceste dispozitive care încearcă să împingă în sus. Asta te face să fii nevoit să împingi calculul și mai jos.”

„Norul de margine” emergent

De la premiera mondială a pisoiului speriat al lui Shepherd, conceptul de margine al lui Dell s-a întărit oarecum, de la o asamblare nuanțată a straturilor la o etică mai degrabă de descentralizare de bază.

„Noi considerăm că marginea este într-adevăr definită nu neapărat de un anumit loc sau de o anumită tehnologie”, a declarat Matt Baker de la Dell în februarie anul trecut. „În schimb, este o complicație a implementării existente a IT în sensul că, deoarece descentralizăm din ce în ce mai mult mediile noastre IT, constatăm că plasăm soluții de infrastructură IT, software etc., în medii din ce în ce mai constrânse. Un centru de date este un mediu în mare parte neconstrâns; îl construiești după specificațiile pe care le dorești, îl poți răci în mod adecvat, există suficient spațiu. Dar, pe măsură ce plasăm din ce în ce mai multă tehnologie în lumea din jurul nostru, pentru a facilita furnizarea acestor experiențe digitale în timp real, ne aflăm în locații care sunt provocate într-un anumit fel.”

Rețelele din campusuri, a spus Baker, includ echipamente care tind să fie prăfuite și murdare, pe lângă faptul că au o conectivitate cu lățime de bandă redusă. Mediile Telco includ adesea rafturi cu adâncime foarte mică care necesită o populație de procesoare de foarte mare densitate. Iar în cele mai îndepărtate locații de pe hartă, există o penurie de forță de muncă calificată în domeniul IT, „ceea ce pune o presiune mai mare asupra capacității de a gestiona mediile foarte distribuite într-un mod hands-off, fără personal.”

Cu toate acestea, este de datoria unui număr tot mai mare de clienți să proceseze datele mai aproape de punctul în care acestea sunt evaluate sau create pentru prima dată, a susținut el. Acest lucru plasează locația „marginii”, în jurul anului 2020, în orice punct de pe hartă în care veți găsi date, în lipsa unei descrieri mai bune, care să ia foc.

Temitim de la StackPath crede că acel punct este un concept emergent numit „edge cloud” – efectiv o colecție virtuală de mai multe implementări de margine într-o singură platformă. Această platformă ar fi comercializată la început către distribuitorii video multicanal (MVPD, de obicei companiile de cablu tradiționale, dar și unele companii de telecomunicații) care doresc să dețină propriile rețele de distribuție și să își reducă costurile pe termen lung. Dar, ca o sursă suplimentară de venituri, acești furnizori ar putea oferi apoi servicii de tip public-cloud, cum ar fi aplicații SaaS sau chiar găzduire de servere virtuale, în numele clienților comerciali.

O astfel de piață „edge cloud” ar putea concura direct cu centrele de date de dimensiuni medii de nivel 2 și 3 din lume. Având în vedere că operatorii acestor facilități sunt, de obicei, clienți premium ai companiilor de telecomunicații din regiunile respective, aceste companii de telecomunicații ar putea percepe „edge cloud” ca pe o amenințare concurențială la adresa propriilor lor planuri pentru 5G Wireless. Este cu adevărat, după cum a spus un furnizor de infrastructură de margine, o „acaparare fizică a terenului”. Iar această acaparare abia a început.

Aflați mai multe – De la CBS Interactive Network

- Cum edge computing poate moderniza, revitaliza imobiliarele comerciale de Larry Dignan, Between the Lines

- Este o cursă către edge, și sfârșitul cloud computing-ului așa cum îl cunoaștem de Scott M. Fulton, III, Scale

- Faceți din edge computing o investiție cheie pentru 2020 de către Forrester Research

În altă parte

- Centrul de date care este o masă de cafea de Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com