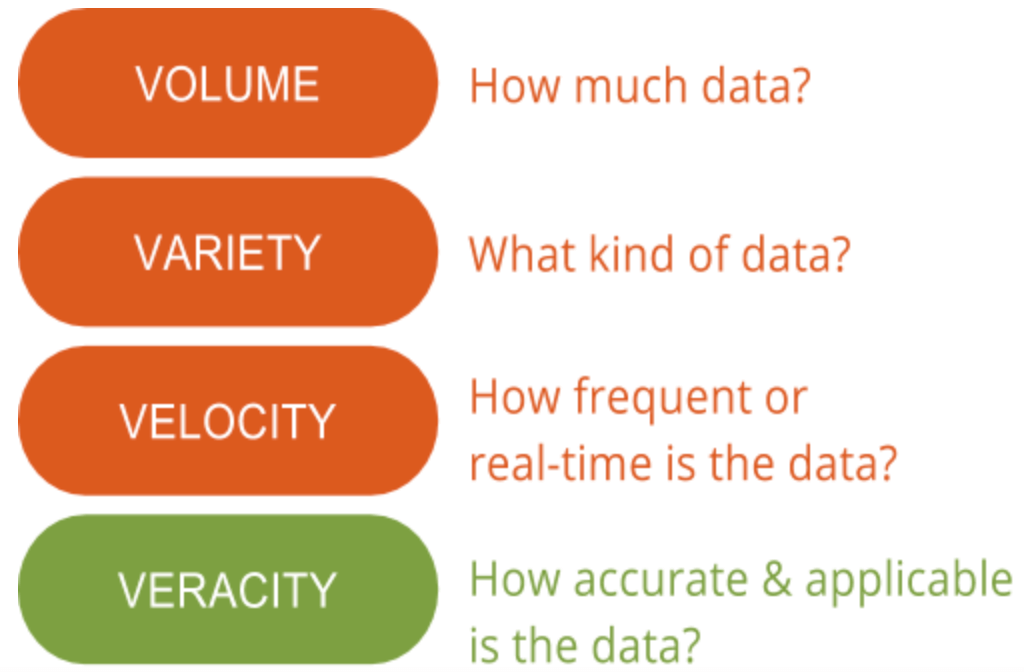

Hier bei GutCheck sprechen wir viel über die 4 V’s von Big Data: Volume, Variety, Velocity und Veracity. Es gibt ein „V“, dem wir mehr Bedeutung beimessen als allen anderen – Veracity. Die Datenwahrheit ist der Bereich, in dem noch Verbesserungspotenzial besteht und der die größte Herausforderung im Zusammenhang mit Big Data darstellt. Bei der großen Menge an Daten, die zur Verfügung stehen, ist die Sicherstellung ihrer Relevanz und Qualität der Unterschied zwischen denjenigen, die Big Data erfolgreich nutzen, und denjenigen, die Schwierigkeiten haben, sie zu verstehen.

Die Bedeutung der Datenwahrheit zu verstehen, ist der erste Schritt, um das Signal vom Rauschen zu unterscheiden, wenn es um Big Data geht. Mit anderen Worten: Datenwahrheit hilft dabei herauszufiltern, was wichtig ist und was nicht, und führt letztendlich zu einem tieferen Verständnis der Daten und ihrer Kontextualisierung, um Maßnahmen zu ergreifen.

Die Bedeutung der Datenwahrheit zu verstehen, ist der erste Schritt, um das Signal vom Rauschen zu unterscheiden, wenn es um Big Data geht. Mit anderen Worten: Datenwahrheit hilft dabei herauszufiltern, was wichtig ist und was nicht, und führt letztendlich zu einem tieferen Verständnis der Daten und ihrer Kontextualisierung, um Maßnahmen zu ergreifen.

Was ist Datenwahrheit?

Datenwahrheit bedeutet im Allgemeinen, wie genau oder wahrheitsgetreu ein Datensatz sein kann. Im Zusammenhang mit Big Data erhält sie jedoch eine etwas größere Bedeutung. Genauer gesagt, geht es bei der Genauigkeit von Big Data nicht nur um die Qualität der Daten selbst, sondern auch darum, wie vertrauenswürdig die Datenquelle, der Datentyp und die Verarbeitung der Daten sind. Die Beseitigung von Verzerrungen, Anomalien oder Inkonsistenzen, Duplizierung und Volatilität sind nur einige Aspekte, die zur Verbesserung der Genauigkeit von Big Data beitragen.

Leider liegt die Volatilität manchmal nicht in unserem Einflussbereich. Die Volatilität, die manchmal als ein weiteres „V“ von Big Data bezeichnet wird, ist die Änderungsrate und Lebensdauer der Daten. Ein Beispiel für hochvolatile Daten sind die sozialen Medien, in denen sich Stimmungen und aktuelle Themen schnell und häufig ändern. Weniger volatile Daten sind eher mit Wettertrends vergleichbar, die sich weniger häufig ändern und leichter vorherzusagen und zu verfolgen sind.

Die zweite Seite der Datenwahrheit besteht darin, sicherzustellen, dass die Verarbeitungsmethode der tatsächlichen Daten auf der Grundlage der Geschäftsanforderungen sinnvoll ist und die Ergebnisse den Zielen entsprechen. Dies ist natürlich besonders wichtig, wenn die primäre Marktforschung mit Big Data kombiniert wird. Die richtige Interpretation von Big Data gewährleistet, dass die Ergebnisse relevant und umsetzbar sind. Darüber hinaus bedeutet der Zugang zu Big Data, dass man Monate damit verbringen könnte, Informationen zu sortieren, ohne sich zu konzentrieren und ohne eine Methode zu haben, um zu erkennen, welche Datenpunkte relevant sind. Daher sollten die Daten zeitnah analysiert werden, was bei Big Data schwierig ist, da die Erkenntnisse sonst nicht von Nutzen sind.

Warum das wichtig ist

Big Data ist hochkomplex, und die Mittel zum Verstehen und Interpretieren dieser Daten sind noch nicht ganz ausgereift. Während viele glauben, dass maschinelles Lernen einen großen Nutzen für die Big-Data-Analyse haben wird, sind statistische Methoden nach wie vor erforderlich, um die Datenqualität und die praktische Anwendung von Big Data für Marktforscher sicherzustellen. Sie würden zum Beispiel keinen Branchenbericht aus dem Internet herunterladen und ihn nutzen, um Maßnahmen zu ergreifen. Stattdessen würden Sie ihn wahrscheinlich validieren oder als Grundlage für weitere Untersuchungen verwenden, bevor Sie Ihre eigenen Ergebnisse formulieren. Mit Big Data verhält es sich nicht anders: Sie können Big Data nicht so nehmen, wie sie sind, ohne sie zu validieren oder zu erläutern. Aber im Gegensatz zu den meisten Marktforschungspraktiken haben Big Data keine solide Grundlage in der Statistik.

Deshalb haben wir viel Zeit damit verbracht, Datenmanagementplattformen und Big Data zu verstehen, um weiterhin Methoden zu entwickeln, die Daten mit forschungsgerechter Präzision integrieren, aggregieren und interpretieren, wie wir es von den bewährten Methoden gewohnt sind. Zu diesen Methoden gehören die Indizierung und Bereinigung der Daten sowie die Verwendung von Primärdaten, um den Kontext zu verbessern und die Wahrhaftigkeit der Erkenntnisse zu erhalten.

Viele Unternehmen können nicht die nötige Zeit aufwenden, um wirklich zu erkennen, ob eine Big-Data-Quelle und eine Verarbeitungsmethode ein hohes Maß an Wahrhaftigkeit bieten. Die Zusammenarbeit mit einem Partner, der sich mit den Grundlagen von Big Data in der Marktforschung auskennt, kann hier helfen. In der folgenden Fallstudie erfahren Sie, wie einer unserer Kunden Erkenntnisse auf der Grundlage von Umfragen und Verhaltensdaten (Big Data) gewonnen hat. Sie werden auch sehen, wie sie die Punkte miteinander verbinden und die Macht der Publikumsintelligenz freisetzen konnten, um eine bessere Verbrauchersegmentierungsstrategie zu entwickeln.