- Zusammenfassung

- Die aktuelle Topologie von Unternehmensnetzwerken

- Potenzielle Vorteile

- Potenzielle Fallstricke

- Was bedeutet „Edge Computing“?

- Wie CDNs den Weg bahnten

- Der Trend zur Dezentralisierung

- Service-Level-Ziele

- Das mehrstufige Netzwerk

- Edge Computing auf einer Karte verorten

- Die „operative Technologiekante“

- Dells dreiteiliges Netzwerk

- Die entstehende ‚Edge Cloud‘

- Erfahren Sie mehr – Vom CBS Interactive Network

- Anderswo

Zusammenfassung

Am Rand eines jeden Netzwerks gibt es Möglichkeiten, Server, Prozessoren und Datenspeicher so nah wie möglich an denjenigen zu platzieren, die sie am besten nutzen können. Wo man die Entfernung verringern kann, da die Geschwindigkeit der Elektronen im Wesentlichen konstant ist, wird die Latenzzeit minimiert. Ein Netz, das für die Nutzung am Rande der Netze konzipiert ist, nutzt diese minimale Entfernung, um den Service zu beschleunigen und Mehrwert zu schaffen.

In einem modernen Kommunikationsnetz, das für den Einsatz am Rande konzipiert ist – zum Beispiel ein 5G-Mobilfunknetz – gibt es zwei mögliche Strategien:

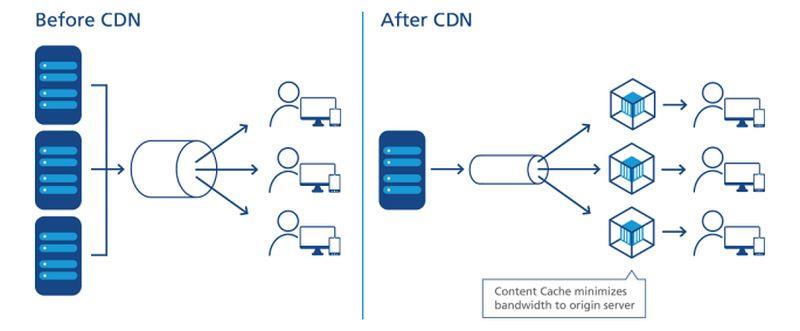

- Datenströme, Audio und Video können schneller und mit weniger (vorzugsweise gar keinen) Pausen empfangen werden, wenn die Server von ihren Nutzern durch ein Minimum an dazwischenliegenden Routingpunkten oder „Hops“ getrennt sind. Content Delivery Networks (CDN) von Anbietern wie Akamai, Cloudflare und NTT Communications basieren auf dieser Strategie.

- Anwendungen können beschleunigt werden, wenn ihre Prozessoren näher am Ort der Datenerfassung stationiert sind. Dies gilt vor allem für Anwendungen in der Logistik und der Großproduktion sowie für das Internet der Dinge (IoT), wo Sensoren oder Datenerfassungsgeräte zahlreich und weit verteilt sind.

Abhängig von der Anwendung können diese Server, wenn eine oder beide Edge-Strategien eingesetzt werden, am einen oder anderen Ende des Netzwerks stehen. Da das Internet nicht wie ein altes Telefonnetz aufgebaut ist, bedeutet „näher“ in Bezug auf die Zweckmäßigkeit der Weiterleitung nicht unbedingt näher in Bezug auf die geografische Entfernung. Und je nachdem, wie viele verschiedene Arten von Dienstanbietern Ihr Unternehmen unter Vertrag genommen hat – Anbieter von öffentlichen Cloud-Anwendungen (SaaS), Anbieter von Anwendungsplattformen (PaaS), Anbieter von gemieteter Infrastruktur (IaaS), Content-Delivery-Netzwerke – gibt es möglicherweise mehrere Bereiche von IT-Immobilien, die darum wetteifern, zu einem bestimmten Zeitpunkt „der Rand“ zu sein.

Innerhalb eines Schneider Electric Mikro-Rechenzentrumsschranks

Scott Fulton

Die aktuelle Topologie von Unternehmensnetzwerken

Es gibt drei Orte, an denen die meisten Unternehmen ihre eigenen Anwendungen und Dienste bereitstellen und verwalten:

- Vor Ort, wo Rechenzentren mehrere Server-Racks beherbergen, die mit den erforderlichen Ressourcen für die Stromversorgung und Kühlung ausgestattet sind und über eine dedizierte Anbindung an externe Ressourcen verfügen

- Colocation-Einrichtungen, in denen Kundengeräte in einem vollständig verwalteten Gebäude untergebracht sind, in dem Stromversorgung, Kühlung, Strom, Kühlung und Konnektivität als Dienste bereitgestellt werden

- Cloud-Service-Anbieter, bei denen die Kundeninfrastruktur bis zu einem gewissen Grad virtualisiert werden kann und Dienste und Anwendungen auf einer nutzungsabhängigen Basis bereitgestellt werden, so dass der Betrieb als Betriebskosten und nicht als Investitionsausgaben verbucht werden kann

Die Architekten des Edge Computing würden versuchen, ihr Design als vierte Kategorie in diese Liste aufzunehmen: Eine, die die Portabilität kleinerer, containerisierter Einrichtungen mit kleineren, modulareren Servern nutzt, um die Entfernungen zwischen dem Verarbeitungspunkt und dem Verbrauchspunkt der Funktionalität im Netz zu verringern. Wenn ihre Pläne aufgehen, wollen sie Folgendes erreichen:

Potenzielle Vorteile

- Minimale Latenz. Das Problem mit den heutigen Cloud-Computing-Diensten ist, dass sie langsam sind, insbesondere für Arbeitslasten, die mit künstlicher Intelligenz arbeiten. Dies disqualifiziert die Cloud für den ernsthaften Einsatz in deterministischen Anwendungen wie Echtzeitprognosen für Wertpapiermärkte, autonome Fahrzeugsteuerung und Verkehrslenkung. Prozessoren, die in kleinen Rechenzentren untergebracht sind, die näher am Einsatzort ihrer Prozesse liegen, könnten neue Märkte für Computing-Dienste erschließen, die Cloud-Anbieter bisher nicht bedienen konnten. In einem IoT-Szenario, in dem Cluster von eigenständigen, datenerfassenden Geräten weit verteilt sind, könnten Prozessoren, die sich näher an Untergruppen oder Clustern dieser Geräte befinden, die Verarbeitungszeit erheblich verbessern, wodurch Echtzeitanalysen auf einer viel granulareren Ebene möglich werden.

- Vereinfachte Wartung. Für ein Unternehmen, das keine großen Schwierigkeiten hat, eine Flotte von Lastwagen oder Wartungsfahrzeugen zu den Standorten zu schicken, sind Mikro-Rechenzentren (µDC) auf maximale Zugänglichkeit, Modularität und ein angemessenes Maß an Portabilität ausgelegt. Es handelt sich dabei um kompakte Gehäuse, von denen einige so klein sind, dass sie in den Kofferraum eines Pickups passen, und die gerade genug Server für zeitkritische Funktionen aufnehmen können, um in der Nähe ihrer Nutzer aufgestellt zu werden. Es ist denkbar, dass ein Gebäude, das seine Rechenzentrumsanlagen derzeit im Keller unterbringt, mit Strom versorgt und kühlt, den gesamten Betrieb durch drei oder vier µDCs irgendwo auf dem Parkplatz ersetzen könnte.

- Günstigere Kühlung. Bei großen Rechenzentrumskomplexen können die monatlichen Stromkosten für die Kühlung leicht die Kosten für den Stromverbrauch für die Verarbeitung übersteigen. Das Verhältnis zwischen beiden wird als Stromverbrauchseffektivität (PUE) bezeichnet. Zeitweise war dies das Basismaß für die Effizienz von Rechenzentren (obwohl in den letzten Jahren Umfragen gezeigt haben, dass immer weniger IT-Betreiber wissen, was dieses Verhältnis eigentlich bedeutet). Theoretisch kann es ein Unternehmen weniger kosten, mehrere kleinere Rechenzentren zu kühlen und zu klimatisieren, als ein großes Rechenzentrum. Außerdem können die Kosten pro Kilowatt aufgrund der besonderen Art und Weise, wie einige Stromversorgungsgebiete die Abrechnung handhaben, für dieselben Serverracks, die in mehreren kleinen Einrichtungen gehostet werden, insgesamt niedriger ausfallen als in einer großen Einrichtung. Ein 2017 von Schneider Electric veröffentlichtes Whitepaper bewertete alle größeren und kleineren Kosten, die mit dem Bau von herkömmlichen und Mikro-Rechenzentren verbunden sind. Während ein Unternehmen für den Bau einer traditionellen 1-MW-Anlage knapp 7 Millionen US-Dollar an Kapitalkosten aufwenden muss, wären es für die Einrichtung von 200 5-KW-Anlagen nur etwas mehr als 4 Millionen US-Dollar.

- Klimabewusstsein. Die Idee, Rechenleistung an Kunden in einem größeren geografischen Gebiet zu verteilen, hatte schon immer eine gewisse ökologische Anziehungskraft, im Gegensatz zur Zentralisierung dieser Leistung in riesigen Anlagen und dem Einsatz von Glasfaserkabeln mit hoher Bandbreite für die Konnektivität. Das frühe Marketing für Edge Computing stützt sich auf den gesunden Menschenverstand der Zuhörer, dass kleinere Anlagen weniger Strom verbrauchen, auch insgesamt. Doch ob das tatsächlich stimmt, ist noch nicht geklärt. Eine Studie von Forschern der Technischen Universität Kosice (Slowakei) aus dem Jahr 2018, die simulierte Edge-Computing-Einsätze in einem IoT-Szenario nutzte, kam zu dem Schluss, dass die Energieeffizienz von Edge fast ausschließlich von der Genauigkeit und Effizienz der dort durchgeführten Berechnungen abhängt. Der durch ineffiziente Berechnungen entstehende Overhead wird durch eine schlechte Programmierung sogar noch vergrößert.

Wenn all dies nach einem zu komplexen System klingt, um realisierbar zu sein, sollte man bedenken, dass das öffentliche Cloud-Computing-Modell in seiner derzeitigen Form möglicherweise langfristig nicht tragfähig ist. Bei diesem Modell müssten die Teilnehmer weiterhin Anwendungen, Datenströme und Inhaltsströme durch Rohre schieben, die mit Hyperscale-Komplexen verbunden sind, deren Versorgungsgebiete ganze Staaten, Provinzen und Länder umfassen – ein System, an das sich Mobilfunkanbieter niemals herantrauen würden.

Potenzielle Fallstricke

Dennoch ist eine völlig neu gestaltete Computerwelt nach dem Edge-Computing-Modell ungefähr so fantastisch – und so weit entfernt – wie eine Verkehrswelt, die sich vollständig von Erdölkraftstoffen verabschiedet hat. In naher Zukunft steht das Edge-Computing-Modell vor einigen erheblichen Hindernissen, von denen einige nicht ganz einfach zu überwinden sein werden:

- Fernverfügbarkeit von Dreiphasenstrom. Server, die in der Lage sind, Cloud-ähnliche Remote-Dienste für gewerbliche Kunden bereitzustellen, unabhängig davon, wo sie sich befinden, benötigen Hochleistungsprozessoren und In-Memory-Daten, um Multi-Tenancy zu ermöglichen. Wahrscheinlich benötigen sie ausnahmslos Zugang zu dreiphasigem Hochspannungsstrom. Das ist in relativ abgelegenen, ländlichen Gegenden äußerst schwierig, wenn nicht gar unmöglich zu erreichen. (Gewöhnlicher 120-V-Wechselstrom ist einphasig.) Telco-Basisstationen haben bisher noch nie eine derartige Stromversorgung benötigt, und wenn sie nie für eine kommerzielle Nutzung mit mehreren Mietparteien vorgesehen sind, werden sie möglicherweise ohnehin nie dreiphasigen Strom benötigen. Der einzige Grund für eine Nachrüstung des Stromversorgungssystems wäre, wenn Edge Computing realisierbar ist. Bei weit verbreiteten Internet-of-Things-Anwendungen wie den Versuchen von Mississippi mit ferngesteuerten Herzmonitoren könnte eine unzureichende Stromversorgungsinfrastruktur jedoch dazu führen, dass sich die „Habenden“ wieder einmal von den „Nichthabenden“ trennen. Damit der Übergang zu 5G erschwinglich ist, müssen Telekommunikationsunternehmen zusätzliche Einnahmen aus dem Edge-Computing erzielen. Die Idee, Edge Computing an 5G zu binden, entstand aus der Vorstellung, dass kommerzielle und betriebliche Funktionen auf denselben Servern koexistieren könnten – ein Konzept, das von Central Office Re-architected as a Datacenter (CORD) (ursprünglich „Re-imagined“) eingeführt wurde und von dem eine Form nun als ein wichtiger Wegbereiter für 5G Wireless gilt. Das Problem ist, dass es möglicherweise noch nicht einmal legal ist, dass für das Telekommunikationsnetz grundlegende Operationen gemeinsam mit Kundenfunktionen auf denselben Systemen residieren – die Antworten hängen davon ab, ob die Gesetzgeber in der Lage sind, die neue Definition von „Systemen“ zu ergründen. Bis es so weit ist (falls es jemals dazu kommt), hat 3GPP (die Branchenorganisation, die die 5G-Standards festlegt) ein Konzept namens Network Slicing eingeführt, mit dem Telco-Netzwerkserver auf einer sehr niedrigen Ebene in virtuelle Server unterteilt werden können, mit einer viel größeren Trennung als in einer typischen Virtualisierungsumgebung von, sagen wir, VMware. Es ist denkbar, dass ein kundenorientiertes Netzwerk-Slice am Rande des Telekommunikationsnetzes eingesetzt wird und eine begrenzte Anzahl von Kunden bedient. Einige größere Unternehmen würden jedoch lieber die Verantwortung für ihre eigenen Netzwerk-Slices übernehmen, selbst wenn dies bedeutet, dass sie sie in ihren eigenen Einrichtungen einsetzen und den Rand auf ihr Gelände verlagern, als in ein neues System zu investieren, dessen Wertversprechen weitgehend auf Hoffnung beruht.

- Telcos verteidigen ihre Heimatgebiete vor lokalen Ausbrüchen. Wenn das 5G-Funkzugangsnetz (RAN) und die damit verbundenen Glasfaserkabel für kommerzielle Kundendienste genutzt werden sollen, muss eine Art Gateway vorhanden sein, um den privaten Kundenverkehr vom Telco-Verkehr abzuschöpfen. Die Architektur eines solchen Gateways existiert bereits und wurde vom 3GPP formell angenommen. Sie wird als lokaler Breakout bezeichnet und ist auch Teil der offiziellen Erklärung des ETSI-Normengremiums zum Multi-Access Edge Computing (MEC). Technisch gesehen ist dieses Problem also gelöst. Das Problem ist, dass bestimmte Telekommunikationsunternehmen ein Interesse daran haben könnten, zu verhindern, dass der Kundenverkehr von dem Weg abgeleitet wird, den er normalerweise nehmen würde: in ihre eigenen Rechenzentren. Die heutige Netztopologie des Internets besteht aus drei Ebenen: Tier-1-Diensteanbieter arbeiten nur untereinander, während Tier-2-Diensteanbieter in der Regel Kundenkontakt haben. Die dritte Ebene ermöglicht kleinere, regionale ISPs auf lokaler Ebene. Edge-Computing auf globaler Ebene könnte zum Katalysator für Public-Cloud-ähnliche Dienste werden, die von ISPs auf lokaler Ebene angeboten werden, vielleicht durch eine Art „Kettenladen“. Das setzt allerdings voraus, dass die Telekommunikationsunternehmen, die die Stufe 2 verwalten, bereit sind, den eingehenden Netzverkehr in eine dritte Stufe aufzuteilen und damit den Wettbewerb auf einem Markt zu ermöglichen, den sie sehr leicht für sich beanspruchen könnten.

Wenn Standort, Standort, Standort für die Unternehmen wieder wichtig wird, kann der gesamte Markt für Unternehmensdatenverarbeitung auf den Kopf gestellt werden. Die zentralisierte, energiehungrige Natur von Cloud-Rechenzentren in Hyperscale-Größe könnte sich am Ende gegen sie richten, da kleinere, wendigere und kosteneffizientere Betriebsmodelle – wie Löwenzahn, wenn alles wie geplant läuft – an breiter verteilten Standorten entstehen.

„Ich glaube, dass das Interesse an Edge-Implementierungen“, so Kurt Marko, Leiter des Technologie-Analyseunternehmens Marko Insights, in einer Notiz an ZDNet, „in erster Linie von der Notwendigkeit getrieben wird, riesige Datenmengen zu verarbeiten, die von ‚intelligenten‘ Geräten, Sensoren und Nutzern – vor allem mobilen und drahtlosen Nutzern – erzeugt werden. In der Tat werden die Datenraten und der Durchsatz von 5G-Netzwerken, zusammen mit der eskalierenden Datennutzung der Kunden, erfordern, dass mobile Basisstationen zu Mini-Rechenzentren werden.“

Was bedeutet „Edge Computing“?

In jedem Telekommunikationsnetz ist der Rand die äußerste Reichweite seiner Einrichtungen und Dienste in Richtung seiner Kunden. Im Zusammenhang mit Edge Computing ist der Edge der Ort auf der Erde, an dem Server den Kunden am zweckmäßigsten Funktionen bereitstellen können.

Wie CDNs den Weg bahnten

Diagramm der Beziehung zwischen Rechenzentren und Internet-of-Things-Geräten, wie vom Industrial Internet Consortium dargestellt.

Im Internet wird die Datenverarbeitung von Servern durchgeführt – Komponenten, die normalerweise durch eine Form (z. B. eine Wolke) in der Nähe des Zentrums oder Brennpunkts eines Netzwerkdiagramms dargestellt werden. Die Daten werden von den Geräten an den Rändern dieses Diagramms gesammelt und zur Verarbeitung in die Mitte gezogen. Die verarbeiteten Daten werden wie Öl aus einer Raffinerie zur Auslieferung zurück an den Rand gepumpt. CDNs beschleunigen diesen Prozess, indem sie als „Tankstellen“ für die Benutzer in ihrer Nähe fungieren. Der typische Produktlebenszyklus für Netzwerkdienste beinhaltet diesen „Round-Trip“-Prozess, bei dem Daten effektiv abgebaut, verschickt, veredelt und wieder verschickt werden. Und wie bei jedem Prozess, der Logistik beinhaltet, braucht der Transport Zeit.

Eine genaue bildliche Darstellung der CDN-Server im Datenlieferprozess.

NTT Communictions

Ob sich das CDN immer in der Mitte des Diagramms befindet, hängt davon ab, wessen Diagramm Sie betrachten. Wenn der CDN-Anbieter das Diagramm erstellt hat, befindet sich vielleicht eine große „CDN“-Wolke in der Mitte, mit Unternehmensnetzwerken an den Rändern der einen Seite und Benutzergeräten an den anderen Rändern. Eine Ausnahme bildet NTT, dessen vereinfachtes, aber genaueres Diagramm oben zeigt, dass sich CDN-Server zwischen dem Punkt des Datenzugriffs und den Benutzern befinden. Aus der Sicht der Produzenten von Daten oder Inhalten, im Gegensatz zu den Zustellern, befinden sich CDNs am Ende der Lieferkette – der vorletzte Schritt für Daten, bevor der Benutzer sie erhält.

Im letzten Jahrzehnt begannen die großen CDN-Anbieter mit der Einführung von Datenverarbeitungsdiensten, die direkt am Ort der Bereitstellung angesiedelt sind. Stellen Sie sich vor, eine Tankstelle könnte ihre eigene Raffinerie sein, und Sie verstehen die Idee. Das Wertversprechen für diesen Service hängt davon ab, dass CDNs nicht als Zentrum, sondern als Rand wahrgenommen werden. Sie ermöglichen es, dass einige Daten nicht mehr transportiert, sondern nur noch verarbeitet und zurücktransportiert werden müssen.

Der Trend zur Dezentralisierung

Wenn die CDNs auch noch nicht die Effektivität des Edge Computing als Dienst bewiesen haben, so haben sie doch zumindest den Wert dieses Geschäfts bewiesen: Unternehmen zahlen Prämien für die Verarbeitung bestimmter Daten, bevor sie das Zentrum oder den „Kern“ des Netzwerks erreichen.

„Wir haben eine ziemlich lange Phase der Zentralisierung hinter uns“, erklärte Matt Baker, Senior Vice President für Strategie und Planung bei Dell Technologies, auf einer Pressekonferenz im vergangenen Februar. „Und da die Welt durch ihre digitalen Transformationsinitiativen zunehmend digitale Erfahrungen in Echtzeit liefern will, beginnt die Fähigkeit, an diesem stark zentralisierten IT-Ansatz festzuhalten, ziemlich zu bröckeln.“

Edge Computing wird als einer der lukrativen, neuen Märkte angepriesen, die durch die 5G Wireless-Technologie möglich werden. Damit der weltweite Übergang von 4G zu 5G für viele Telekommunikationsunternehmen wirtschaftlich machbar ist, muss die neue Generation neue, nutzbare Umsatzkanäle eröffnen. 5G erfordert ein riesiges, neues Netz von (ironischerweise) kabelgebundenen Glasfaserverbindungen, um Sender und Basisstationen mit unmittelbarem Zugang zu digitalen Daten zu versorgen (der Backhaul). Daraus ergibt sich für eine neue Klasse von Anbietern von Datenverarbeitungsdiensten die Möglichkeit, mehrere µDCs in der Nähe von Türmen des Funkzugangsnetzes (RAN) zu errichten, vielleicht in der Nähe von oder im selben Gebäude wie die Basisstationen der Telekommunikationsunternehmen. Diese Rechenzentren könnten gemeinsam Cloud-Computing-Dienste für ausgewählte Kunden anbieten, und zwar zu Preisen, die mit denen von Hyperscale-Cloud-Anbietern wie Amazon, Microsoft Azure und Google Cloud Platform vergleichbar sind, und mit vergleichbaren Funktionen.

Nach etwa einem Jahrzehnt der Entwicklung könnte Edge Computing den Kunden schnelle Dienste bis in die Nähe ihrer nächsten Mobilfunkbasisstationen bringen. Wir bräuchten riesige Glasfaserkabel, um den notwendigen Backhaul bereitzustellen, aber die Einnahmen aus Edge-Computing-Diensten könnten deren Bau finanzieren, so dass sie sich selbst tragen könnten.

Service-Level-Ziele

In der endgültigen Analyse (falls es überhaupt jemals eine endgültige Analyse gegeben hat) wird der Erfolg oder Misserfolg von Rechenzentren an den Netzrändern von ihrer Fähigkeit abhängen, Service-Level-Ziele (SLO) zu erfüllen. Dabei handelt es sich um die Erwartungen der Kunden, die für Dienstleistungen bezahlen, die in ihren Dienstleistungsverträgen kodifiziert sind. Ingenieure verfügen über Metriken, mit denen sie die Leistung von Netzwerkkomponenten aufzeichnen und analysieren können. Kunden neigen dazu, diese Metriken zu vermeiden und sich stattdessen auf die beobachtbare Leistung ihrer Anwendungen zu konzentrieren. Wenn eine Edge-Implementierung nicht merklich schneller ist als eine Hyperscale-Implementierung, dann kann das Edge-Konzept in seinen Kinderschuhen stecken bleiben.

„Worauf kommt es uns an? Die Reaktionszeit der Anwendungen“, erklärte Tom Gillis, Senior Vice President für Netzwerke und Sicherheit bei VMware, kürzlich auf einer Konferenz des Unternehmens. „Wenn wir charakterisieren können, wie die Anwendung reagiert, und uns die einzelnen Komponenten ansehen, die an der Bereitstellung dieser Anwendungsantwort arbeiten, können wir tatsächlich beginnen, eine selbstheilende Infrastruktur zu schaffen.“

Die Verringerung der Latenzzeit und die Verbesserung der Verarbeitungsgeschwindigkeit (mit neueren Servern, die sich quantitativ weit weniger Aufgaben widmen) sollten SLOs zugute kommen. Einige haben auch darauf hingewiesen, wie die breite Verteilung von Ressourcen über ein Gebiet zur Redundanz von Diensten und sogar zur Geschäftskontinuität beiträgt – die, zumindest bis zur Pandemie, als ein- oder zweitägige Ereignisse wahrgenommen wurden, gefolgt von Wiederherstellungsphasen.

Allerdings gibt es Ausgleichsfaktoren, von denen der wichtigste mit der Wartung und Instandhaltung zu tun hat. Ein typisches Tier-2-Rechenzentrum kann im Notfall (z. B. bei einer Pandemie) von nur zwei Personen vor Ort gewartet werden, wobei das Support-Personal nicht vor Ort ist. Ein µDC hingegen ist so konzipiert, dass es ohne ständige Personalbesetzung funktioniert. Seine integrierten Überwachungsfunktionen senden kontinuierlich Telemetriedaten an einen zentralen Knotenpunkt, der sich theoretisch in der öffentlichen Cloud befinden könnte. Solange ein µDC seine SLOs erfüllt, muss es nicht persönlich betreut werden.

Hier muss die Tragfähigkeit des Edge-Computing-Modells noch gründlich getestet werden. Bei einem typischen Vertrag mit einem Rechenzentrumsanbieter wird ein SLO oft daran gemessen, wie schnell das Personal des Anbieters ein offenes Problem lösen kann. In der Regel können die Lösungszeiten niedrig bleiben, wenn das Personal nicht per LKW zu den Problemstellen fahren muss. Wenn ein Edge-Bereitstellungsmodell mit einem Colocation-Bereitstellungsmodell konkurrieren soll, müssen seine automatisierten Behebungsfähigkeiten außerordentlich gut sein.

Das mehrstufige Netzwerk

Datenspeicheranbieter, Anbieter von Cloud-nativen Anwendungen, Anbieter von Internet-of-Things (IoT)-Diensten, Serverhersteller, Real Estate Investment Trusts (REIT) und Hersteller von vormontierten Servergehäusen bauen allesamt Expresswege zwischen ihren Kunden und dem, was für jeden von ihnen der Edge zu sein verspricht.

Was sie alle wirklich suchen, ist ein Wettbewerbsvorteil. Die Idee des Vorsprungs lässt neue Hoffnung auf einen Premium-Service aufkeimen – einen handfesten, gerechtfertigten Grund dafür, dass für bestimmte Serviceklassen höhere Preise verlangt werden als für andere. Wenn Sie an anderer Stelle gelesen oder gehört haben, dass der Edge schließlich die gesamte Cloud subsumieren könnte, werden Sie jetzt vielleicht verstehen, dass dies nicht wirklich viel Sinn machen würde. Wenn alles Premium wäre, wäre nichts mehr Premium.

„Edge Computing wird anscheinend die perfekte Technologielösung sein, und Risikokapitalgeber sagen, dass es ein Multi-Milliarden-Dollar-Tech-Markt sein wird“, bemerkte Kevin Brown, CTO und Senior Vice President für Innovation bei Schneider Electric, einem Anbieter von Serviceeinrichtungen für Rechenzentren und Hersteller von Chassis für Mikro-Rechenzentren. „Niemand weiß wirklich, was es ist.“

Schneider Electric’s Kevin Brown: „Niemand weiß wirklich, was das ist.“

Brown räumte ein, dass Edge Computing seine Geschichte den Pionieren der CDNs wie Akamai verdankt. Dennoch, so fuhr er fort, „gibt es all diese verschiedenen Schichten – HPE hat seine Version, Cisco hat die seine. . . Wir konnten uns keinen Reim auf all das machen. Unsere Sicht auf den Edge ist eine sehr vereinfachte Sichtweise. In der Zukunft wird es drei Arten von Rechenzentren geben, um die man sich wirklich kümmern muss.“

Das Bild, das Brown während einer Presseveranstaltung in der Unternehmenszentrale in Massachusetts im Februar 2019 zeichnete, ist eine neu aufkommende Sicht auf ein dreistufiges Internet und wird von einer wachsenden Zahl von Technologieunternehmen geteilt. Im traditionellen zweistufigen Modell beschränken sich Tier-1-Knoten auf Peering mit anderen Tier-1-Knoten, während Tier-2-Knoten die Datenverteilung auf regionaler Ebene übernehmen. Seit den Anfängen des Internets gibt es eine Bezeichnung für Tier-3 – für den Zugang auf einer viel lokaleren Ebene. (Man vergleiche dazu das System des zellularen Funkzugangsnetzes, bei dem die Verteilung des Datenverkehrs auf einer Ebene erfolgt).

„Der erste Punkt, an dem man sich mit dem Netz verbindet, ist das, was wir als den lokalen Rand betrachten“, erklärt Brown. Auf die heutige Technologie übertragen, so Brown weiter, könnte man eine der heutigen Edge-Computing-Einrichtungen in einem beliebigen Server finden, der in einem behelfsmäßigen Rack in einem Kabelschrank untergebracht ist.

„Für unsere Zwecke“, fuhr er fort, „denken wir, dass dort die Action stattfindet.“

„Die Grenze waren jahrelang die Tier-1-Carrier-Hotels wie Equinix und CoreSite. Sie haben im Grunde ein Netzwerk mit einem anderen verbunden, und das wurde als Edge betrachtet“, erklärt Wen Temitim, CTO des Edge-Infrastrukturdienstleisters StackPath. „Aber was wir sehen, mit all den verschiedenen Veränderungen in der Nutzung auf der Grundlage des Verbraucherverhaltens und mit COVID-19 und der Arbeit von zu Hause aus, ist ein neuer und tieferer Rand, der für Service Provider immer relevanter wird.“

Edge Computing auf einer Karte verorten

Edge Computing ist ein Versuch, die Servicequalität (QoS) wieder in die Diskussion über die Architektur und die Dienste von Rechenzentren einzubringen, da Unternehmen nicht nur entscheiden, wer ihre Dienste bereitstellt, sondern auch wo.

Die „operative Technologiekante“

Der Rechenzentrumsausrüster HPE – ein Hauptinvestor im Bereich Edge Computing – ist der Ansicht, dass der nächste große Sprung in der Betriebsinfrastruktur von Mitarbeitern und Auftragnehmern koordiniert und geleitet werden wird, die, wenn überhaupt, nur wenig persönliche Investitionen oder eine Ausbildung in Hardware und Infrastruktur haben – Menschen, die bisher weitgehend mit Wartung, Instandhaltung und Software-Support betraut waren. Ihr Unternehmen nennt den Aufgabenbereich für diese Personalkategorie Operational Technology (OT). Im Gegensatz zu denjenigen, die eine Verschmelzung von IT und Betrieb in der einen oder anderen Form von „DevOps“ sehen, sieht HPE drei Klassen von Edge-Computing-Kunden. Jede dieser Klassen wird ihrer Ansicht nach nicht nur ihre eigene Edge-Computing-Plattform unterhalten, sondern die Geografie dieser Plattformen wird sich voneinander trennen und nicht konvergieren, wie dieses HPE-Diagramm zeigt.

Hier gibt es drei verschiedene Klassen von Kunden, denen HPE jeweils ein eigenes Segment des Edge im Allgemeinen zugewiesen hat. Die OT-Klasse bezieht sich dabei auf Kunden, die eher Manager mit Edge Computing beauftragen, die weniger direkte Erfahrung mit IT haben, vor allem weil ihre Hauptprodukte nicht die Information oder Kommunikation selbst sind. Dieser Klasse wird ein „OT-Edge“ zugewiesen. Wenn ein Unternehmen eher direkt in die Informationsbranche investiert oder in hohem Maße von Informationen als Bestandteil seines Geschäfts abhängig ist, weist HPE ihm einen „IT-Edge“ zu. Dazwischen, für Unternehmen, die geografisch verstreut und von der Logistik abhängig sind (wo die Informationen eine logischere Komponente haben) und somit das Internet der Dinge, gibt HPE ihnen einen „IoT-Edge“.

Dells dreiteiliges Netzwerk

Im Jahr 2017 stellte Dell Technologies erstmals seine dreistufige Topologie für den gesamten Computermarkt vor und unterteilte ihn in „Core“, „Cloud“ und „Edge“. Wie diese Folie aus einer frühen Dell-Präsentation zeigt, schien diese Unterteilung radikal einfach zu sein, zumindest auf den ersten Blick: Die IT-Assets eines jeden Kunden ließen sich unterteilen in 1) das, was er besitzt und mit eigenem Personal wartet; 2) das, was er an einen Dienstleister delegiert und diesen mit der Wartung beauftragt; und 3) das, was er über die eigenen Einrichtungen hinaus in den Außenbereich vertreibt, wo es von Betriebsexperten gewartet wird (die ausgelagert werden können oder auch nicht).

In einer Präsentation für die Embedded Linux Conference Europe der Linux Foundation im November 2018 stellte Jason Shepherd, CTO für IoT und Edge Computing, diesen einfachen Fall dar: Bei den vielen vernetzten Geräten und Appliances, die für das IoT geplant sind, wird es technologisch unmöglich sein, ihre Verwaltung zu zentralisieren, auch wenn wir die öffentliche Cloud in Anspruch nehmen.

„Meine Frau und ich haben drei Katzen“, erzählte Shepherd seinem Publikum. „Wir haben größere Speicherkapazitäten auf unseren Handys, damit wir Katzenvideos hin- und herschicken können.

„Katzenvideos erklären die Notwendigkeit von Edge Computing“, fuhr er fort. „Wenn ich eines meiner Videos online stelle und es Zugriffe erhält, muss ich es auf mehreren Servern zwischenspeichern, weit hinten in der Cloud. Wenn es sich viral verbreitet, muss ich den Inhalt so nah wie möglich zu den Abonnenten bringen. Als Telekommunikationsunternehmen oder als Netflix oder was auch immer, kann ich das am ehesten am Rand der Cloud erreichen – am Fuß meiner Funktürme, diesen Schlüsselpunkten im Internet. Das ist das Konzept von MEC, Multi-access Edge Computing, das die Inhalte näher an die Abonnenten bringt. Wenn ich nun Milliarden von angeschlossenen Katzenanrufern da draußen habe, habe ich das Paradigma komplett umgedreht, und statt Dingen, die nach unten ziehen, habe ich all diese Geräte, die versuchen, nach oben zu drücken. Das führt dazu, dass man die Rechenleistung noch weiter nach unten drücken muss.“

Die entstehende ‚Edge Cloud‘

Seit der Weltpremiere von Shepherds verängstigtem Kätzchen hat sich Dells Konzept der Edge etwas gefestigt, von einer nuancierten Zusammenstellung von Schichten zu einer eher grundlegenden Dezentralisierungsethik.

„Für uns ist der Edge nicht unbedingt durch einen bestimmten Ort oder eine bestimmte Technologie definiert“, sagte Matt Baker von Dell im vergangenen Februar. „Stattdessen ist es eine Komplikation des bestehenden IT-Einsatzes, da wir durch die zunehmende Dezentralisierung unserer IT-Umgebungen feststellen, dass wir IT-Infrastrukturlösungen, Software usw. in zunehmend eingeschränkten Umgebungen einsetzen. Ein Rechenzentrum ist eine weitgehend uneingeschränkte Umgebung; man kann es so bauen, wie es einem gefällt, man kann es angemessen kühlen, es gibt viel Platz. Aber da wir immer mehr Technologie in die Welt um uns herum bringen, um die Bereitstellung dieser digitalen Echtzeit-Erfahrungen zu erleichtern, finden wir uns an Orten wieder, die in gewisser Weise herausgefordert sind.“

Campusnetzwerke, so Baker, umfassen Geräte, die dazu neigen, staubig und schmutzig zu sein, abgesehen von Verbindungen mit geringer Bandbreite. In Telekommunikationsumgebungen gibt es oft Racks mit sehr geringer Tiefe, die eine sehr hohe Dichte an Prozessoren erfordern. Und in den am weitesten entfernten Orten auf der Karte gibt es einen Mangel an qualifizierten IT-Mitarbeitern, „was die Fähigkeit, hochgradig verteilte Umgebungen in einer unbemannten Umgebung zu verwalten, noch mehr unter Druck setzt.“

Dessen ungeachtet sei eine wachsende Zahl von Kunden gezwungen, Daten näher an dem Punkt zu verarbeiten, an dem sie zum ersten Mal ausgewertet oder erstellt werden, argumentierte er. Das bedeutet, dass „the edge“ im Jahr 2020 an dem Punkt auf der Landkarte liegen wird, an dem die Daten – in Ermangelung einer besseren Beschreibung – Feuer fangen werden.

Temitim von StackPath ist der Ansicht, dass es sich bei diesem Punkt um ein neu entstehendes Konzept handelt, das als Edge Cloud bezeichnet wird – eine virtuelle Sammlung mehrerer Edge-Implementierungen auf einer einzigen Plattform. Diese Plattform würde zunächst an Multichannel-Videodistributoren (MVPDs, in der Regel etablierte Kabelunternehmen, aber auch einige Telcos) vermarktet, die ihre eigenen Distributionsnetzwerke besitzen und langfristig Kosten einsparen wollen. Als zusätzliche Einnahmequelle könnten diese Anbieter dann aber auch Public-Cloud-ähnliche Dienste wie SaaS-Anwendungen oder sogar virtuelles Server-Hosting im Auftrag kommerzieller Kunden anbieten.

Ein solcher „Edge-Cloud“-Markt könnte direkt mit den mittelgroßen Tier-2- und Tier-3-Rechenzentren der Welt konkurrieren. Da die Betreiber dieser Einrichtungen in der Regel Premium-Kunden der Telekommunikationsunternehmen ihrer jeweiligen Region sind, könnten diese Unternehmen die Edge-Cloud als Wettbewerbsbedrohung für ihre eigenen Pläne für 5G Wireless wahrnehmen. Es ist wirklich, wie ein Anbieter von Edge-Infrastruktur es ausdrückte, eine „physische Landnahme“. Und die Landnahme hat gerade erst begonnen.

Erfahren Sie mehr – Vom CBS Interactive Network

- Wie Edge Computing gewerbliche Immobilien neu gestalten und beleben kann von Larry Dignan, Between the Lines

- Es ist ein Wettlauf zum Edge und das Ende des Cloud Computing, wie wir es kennen von Scott M. Fulton, III, Scale

- Machen Sie Edge Computing zu einer Schlüsselinvestition für 2020 von Forrester Research

Anderswo

- The Data Center That’s a Coffee Table von Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com