- Resumen ejecutivo

- La topología actual de las redes empresariales

- Potenciales beneficios

- Potenciales escollos

- ¿Qué significa «edge computing»?

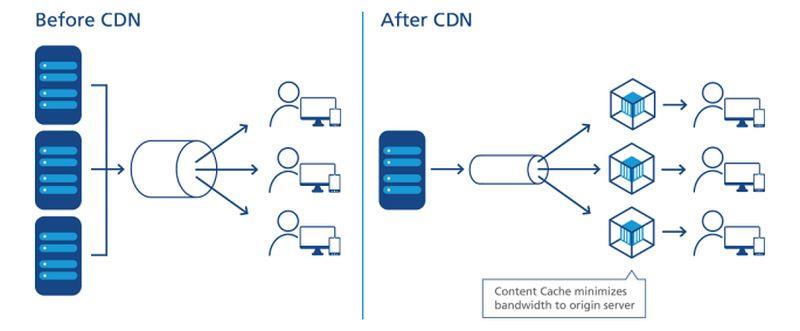

- Cómo las CDNs abrieron el camino

- La tendencia a la descentralización

- Objetivos de nivel de servicio

- La red escalonada

- Localizando el borde en un mapa

- El «borde tecnológico operativo»

- La red tripartita de Dell

- La emergente ‘nube de borde’

- Más información – De la red interactiva de la CBS

- En otros lugares

Resumen ejecutivo

En el borde de cualquier red, existen oportunidades para posicionar servidores, procesadores y matrices de almacenamiento de datos lo más cerca posible de quienes pueden hacer un mejor uso de ellos. Cuando se puede reducir la distancia, ya que la velocidad de los electrones es esencialmente constante, se minimiza la latencia. Una red diseñada para ser utilizada en el borde aprovecha esta distancia mínima para agilizar el servicio y generar valor.

En una red de comunicaciones moderna diseñada para su uso en el borde -por ejemplo, una red inalámbrica 5G- hay dos posibles estrategias en funcionamiento:

- Los flujos de datos, audio y vídeo pueden recibirse más rápidamente y con menos pausas (preferiblemente ninguna) cuando los servidores están separados de sus usuarios por un mínimo de puntos de enrutamiento intermedios, o «saltos». Las redes de entrega de contenidos (CDN) de proveedores como Akamai, Cloudflare y NTT Communications se basan en esta estrategia.

- Las aplicaciones pueden acelerarse cuando sus procesadores están situados más cerca del lugar donde se recogen los datos. Esto es especialmente cierto para aplicaciones de logística y fabricación a gran escala, así como para el Internet de las cosas (IoT), donde los sensores o los dispositivos de recogida de datos son numerosos y están muy distribuidos.

Dependiendo de la aplicación, cuando se emplean una o ambas estrategias de borde, estos servidores pueden acabar realmente en un extremo de la red o en el otro. Dado que Internet no está construida como la antigua red telefónica, «más cerca» en términos de conveniencia de enrutamiento no es necesariamente más cerca en distancia geográfica. Y dependiendo de cuántos tipos diferentes de proveedores de servicios haya contratado su organización -proveedores de aplicaciones en la nube pública (SaaS), proveedores de plataformas de aplicaciones (PaaS), proveedores de infraestructura alquilada (IaaS), redes de entrega de contenidos- puede haber múltiples tramos de bienes inmuebles de TI compitiendo por ser «el borde» en cualquier momento.

Dentro de un armario de microcentro de datos de Schneider Electric

Scott Fulton

La topología actual de las redes empresariales

Hay tres lugares en los que la mayoría de las empresas tienden a desplegar y gestionar sus propias aplicaciones y servicios:

- En las instalaciones, donde los centros de datos albergan múltiples bastidores de servidores, donde están equipados con los recursos necesarios para alimentarlos y refrigerarlos, y donde hay una conectividad dedicada a los recursos externos

- Instalaciones de colocación, donde los equipos de los clientes se alojan en un edificio totalmente gestionado donde la energía, la refrigeración, y la conectividad se proporcionan como servicios

- Proveedores de servicios en la nube, donde la infraestructura del cliente puede estar virtualizada hasta cierto punto, y los servicios y aplicaciones se proporcionan por uso, lo que permite que las operaciones se contabilicen como gastos operativos en lugar de gastos de capital

Los arquitectos de la computación de borde tratarían de añadir su diseño como una cuarta categoría a esta lista: una que aprovecha la portabilidad de instalaciones más pequeñas y en contenedores con servidores más pequeños y modulares, para reducir las distancias entre el punto de procesamiento y el punto de consumo de la funcionalidad en la red. Si sus planes dan resultado, buscan lograr lo siguiente:

Potenciales beneficios

- Mínima latencia. El problema con los servicios de computación en la nube hoy en día es que son lentos, especialmente para las cargas de trabajo con inteligencia artificial. Esto descalifica esencialmente a la nube para un uso serio en aplicaciones deterministas, como la previsión de los mercados de valores en tiempo real, el pilotaje de vehículos autónomos y el enrutamiento del tráfico de transporte. Los procesadores ubicados en pequeños centros de datos, más cerca de donde se utilizarán sus procesos, podrían abrir nuevos mercados de servicios informáticos que los proveedores de la nube no han podido abordar hasta ahora. En un escenario de IoT, en el que los clústeres de aparatos autónomos de recopilación de datos están ampliamente distribuidos, tener procesadores más cerca incluso de los subgrupos o clústeres de esos aparatos podría mejorar en gran medida el tiempo de procesamiento, haciendo factible el análisis en tiempo real a un nivel mucho más granular.

- Mantenimiento simplificado. Para una empresa que no tiene muchos problemas para enviar una flota de camiones o vehículos de mantenimiento a las ubicaciones sobre el terreno, los microcentros de datos (µDC) están diseñados para ofrecer la máxima accesibilidad, modularidad y un grado razonable de portabilidad. Son recintos compactos, algunos lo suficientemente pequeños como para caber en la parte trasera de una camioneta, que pueden soportar los servidores suficientes para alojar funciones de tiempo crítico, que pueden desplegarse más cerca de sus usuarios. Es posible que un edificio que actualmente aloje, alimente y refrigere los activos de su centro de datos en su sótano, sustituya toda esa operación por tres o cuatro µDC en algún lugar del aparcamiento, lo que podría suponer una mejora.

- Refrigeración más barata. Para los grandes complejos de centros de datos, el coste mensual de la electricidad utilizada en la refrigeración puede superar fácilmente el coste de la electricidad utilizada en el procesamiento. La relación entre ambos se denomina efectividad del uso de la energía (PUE). En ocasiones, ésta ha sido la medida de referencia de la eficiencia de los centros de datos (aunque en los últimos años, las encuestas han demostrado que menos operadores de TI saben lo que significa realmente este ratio). En teoría, a una empresa le puede costar menos refrigerar y acondicionar varios espacios más pequeños del centro de datos que uno grande. Además, debido a las formas peculiares en que algunas áreas de servicio de electricidad manejan la facturación, el costo por kilovatio puede bajar en general para los mismos bastidores de servidores alojados en varias instalaciones pequeñas en lugar de una grande. Un libro blanco de 2017 publicado por Schneider Electric evaluó todos los costes mayores y menores asociados a la construcción de centros de datos tradicionales y microcentros. Mientras que una empresa podría incurrir en algo menos de 7 millones de dólares en gastos de capital para construir una instalación tradicional de 1 MW, gastaría poco más de 4 millones de dólares para facilitar 200 instalaciones de 5 KW.

- Conciencia climática. La idea de distribuir la potencia informática a los clientes en una zona geográfica más amplia siempre ha tenido un cierto atractivo ecológico, en lugar de centralizar esa potencia en gigantescas instalaciones a gran escala y depender de enlaces de fibra óptica de gran ancho de banda para la conectividad. El marketing inicial de la computación de borde se basa en la impresión de sentido común de los oyentes de que las instalaciones más pequeñas consumen menos energía, incluso colectivamente. Pero el jurado aún no sabe si eso es realmente cierto. Un estudio realizado en 2018 por investigadores de la Universidad Técnica de Kosice (Eslovaquia), en el que se utilizaron despliegues simulados de edge computing en un escenario de IoT, concluyó que la eficacia energética del edge depende casi por completo de la precisión y la eficiencia de los cálculos que se realizan en él. La sobrecarga en la que incurren los cálculos ineficientes, descubrieron, en realidad se vería magnificada por una mala programación.

Si todo esto suena como un sistema demasiado complejo para ser factible, hay que tener en cuenta que, en su forma actual, el modelo de computación en la nube pública puede no ser sostenible a largo plazo. Ese modelo haría que los suscriptores siguieran empujando las aplicaciones, los flujos de datos y los flujos de contenido a través de tuberías conectadas con complejos a hiperescala cuyas áreas de servicio abarcan estados, provincias y países enteros, un sistema que los proveedores de voz inalámbricos nunca se habrían atrevido a intentar.

Potenciales escollos

No obstante, un mundo informático completamente rehecho en el modelo de edge computing es tan fantástico -y tan remoto- como un mundo del transporte que se haya despojado por completo de los combustibles derivados del petróleo. A corto plazo, el modelo de computación de borde se enfrenta a algunos obstáculos importantes, varios de los cuales no serán del todo fáciles de superar:

- Disponibilidad remota de energía trifásica. Los servidores capaces de proporcionar servicios remotos similares a los de la nube a los clientes comerciales, independientemente de su ubicación, necesitan procesadores de alta potencia y datos en memoria, para permitir la multitenencia. Probablemente sin excepción, necesitarán acceso a electricidad trifásica de alto voltaje. Esto es extremadamente difícil, si no imposible, de conseguir en lugares rurales relativamente remotos. (La corriente ordinaria de 120V AC es monofásica.) Las estaciones base de las telecos nunca han necesitado este nivel de energía hasta ahora, y si nunca se pretende aprovecharlas para el uso comercial de varios inquilinos, entonces puede que nunca necesiten energía trifásica de todos modos. La única razón para adaptar el sistema de alimentación sería si la computación de borde es viable. Pero en el caso de las aplicaciones del Internet de las Cosas ampliamente distribuidas, como las pruebas de monitores cardíacos remotos de Mississippi, la falta de una infraestructura energética suficiente podría acabar dividiendo una vez más a los que «tienen» de los que «no tienen». Para que la transición al 5G sea asequible, las telecos deben obtener ingresos adicionales de la computación de borde. Lo que hizo que la idea de vincular la evolución de la computación de borde a la 5G fuera la noción de que las funciones comerciales y operativas podrían coexistir en los mismos servidores, un concepto introducido por Central Office Re-architected as a Datacenter (CORD) (originalmente «Re-imagined»), una forma que ahora se considera un facilitador clave de la 5G inalámbrica. El problema es que puede que ni siquiera sea legal que las operaciones fundamentales para la red de telecomunicaciones convivan con las funciones de los clientes en los mismos sistemas: las respuestas dependen de si los legisladores son capaces de comprender la nueva definición de «sistemas». Hasta que llegue ese día (si es que llega), el 3GPP (la organización del sector que rige los estándares de la 5G) ha adoptado un concepto llamado network slicing, que es una forma de dividir los servidores de la red de las telecos en servidores virtuales a un nivel muy bajo, con una separación mucho mayor que en un entorno de virtualización típico de, por ejemplo, VMware. Es concebible que una porción de red orientada al cliente pueda desplegarse en el borde de las redes de telecomunicaciones, sirviendo a un número limitado de clientes. Sin embargo, algunas grandes empresas preferirían hacerse cargo de sus propias porciones de red, incluso si eso significa desplegarlas en sus propias instalaciones -trasladando el borde a sus instalaciones-, en lugar de invertir en un nuevo sistema cuya propuesta de valor se basa en gran medida en la esperanza.

- Las telecos defienden sus territorios de origen de los escapes locales. Si la red de acceso radioeléctrico (RAN) 5G, y los cables de fibra óptica vinculados a ella, se van a aprovechar para los servicios comerciales de los clientes, tiene que haber algún tipo de puerta de enlace para desviar el tráfico de los clientes privados del tráfico de las telecos. La arquitectura de esta pasarela ya existe y ha sido adoptada formalmente por el 3GPP. Se llama «local breakout» y también forma parte de la declaración oficial del organismo de normalización ETSI sobre la computación de borde multiacceso (MEC). Así que, técnicamente, este problema está resuelto. El problema es que algunas telecos pueden tener interés en evitar que el tráfico de los clientes se desvíe del curso que normalmente tomaría: hacia sus propios centros de datos. La topología actual de la red de Internet tiene tres niveles: Los proveedores de servicios de nivel 1 sólo se relacionan entre sí, mientras que los ISP de nivel 2 suelen estar orientados al cliente. El tercer nivel permite a los ISP más pequeños y regionales a un nivel más local. La computación de borde a escala global podría convertirse en el catalizador de los servicios de tipo nube pública, ofrecidos por los ISP a nivel local, quizás a través de una especie de «cadena de tiendas». Pero eso suponiendo que las telecos, que gestionan el nivel 2, estén dispuestas a dejar que el tráfico de red entrante se distribuya en un tercer nivel, lo que permitiría la competencia en un mercado que muy fácilmente podrían reclamar para sí mismas.

Si la ubicación, la localización y la ubicación vuelven a ser importantes para la empresa, entonces todo el mercado de la informática empresarial puede ponerse patas arriba. La naturaleza hiperescalar, centralizada y hambrienta de energía de los centros de datos en la nube puede acabar jugando en su contra, a medida que surgen modelos operativos más pequeños, más ágiles y más rentables -como dientes de león, si todo va como está previsto- en ubicaciones más ampliamente distribuidas.

«Creo que el interés por los despliegues de borde», señaló Kurt Marko, director de la empresa de análisis tecnológico Marko Insights, en una nota enviada a ZDNet, «está impulsado principalmente por la necesidad de procesar cantidades masivas de datos generados por dispositivos, sensores y usuarios «inteligentes», en particular los usuarios móviles e inalámbricos». De hecho, las tasas de datos y el rendimiento de las redes 5G, junto con el creciente uso de datos de los clientes, requerirán que las estaciones base móviles se conviertan en mini centros de datos.»

¿Qué significa «edge computing»?

En cualquier red de telecomunicaciones, el borde es el alcance más lejano de sus instalaciones y servicios hacia sus clientes. En el contexto de la computación de borde, el borde es la ubicación en el planeta donde los servidores pueden entregar la funcionalidad a los clientes de la manera más expedita.

Cómo las CDNs abrieron el camino

Diagrama de la relación entre los centros de datos y los dispositivos del Internet de las Cosas, según el Consorcio del Internet Industrial.

Con respecto a Internet, la computación o el procesamiento se lleva a cabo mediante servidores, componentes que suelen estar representados por una forma (por ejemplo, una nube) cerca del centro o punto focal de un diagrama de red. Los datos se recogen de los dispositivos situados en los bordes de este diagrama y se dirigen hacia el centro para su procesamiento. Los datos procesados, como el petróleo de una refinería, se bombean de nuevo hacia los bordes para su entrega. Las CDNs aceleran este proceso actuando como «estaciones de servicio» para los usuarios de su entorno. El ciclo de vida típico de los servicios de red implica este proceso de «ida y vuelta», en el que los datos se extraen, se envían, se refinan y se vuelven a enviar. Y, como en cualquier proceso que implique logística, el transporte lleva su tiempo.

Una ubicación figurativa precisa de los servidores CDN en el proceso de entrega de datos.

NT Communictions

Lo importante es que el hecho de que la CDN esté siempre en el centro del diagrama depende de quién lo haya elaborado. Si el proveedor de la CDN lo dibujó, puede haber una gran nube «CDN» en el centro, con las redes empresariales a lo largo de los bordes de un lado, y los dispositivos de los equipos de los usuarios a lo largo de los otros bordes. Una excepción es la de NTT, cuyo diagrama simplificado, pero más preciso, muestra a los servidores de la CDN situándose entre el punto de acceso a los datos y los usuarios. Desde la perspectiva de los productores de datos o contenidos, en contraposición a los agentes de entrega, las CDN residen hacia el final de la cadena de suministro, el penúltimo paso para los datos antes de que el usuario los reciba.

A lo largo de la última década, los principales proveedores de CDN comenzaron a introducir servicios informáticos que residen en el punto de entrega. Imagínese que una gasolinera pudiera ser su propia refinería, y entenderá la idea. La propuesta de valor de este servicio depende de que las CDN no se perciban en el centro, sino en el borde. Permite que algunos datos eludan la necesidad de transporte, simplemente para ser procesados y transportados de vuelta.

La tendencia a la descentralización

Si las CDN no han demostrado aún la eficacia de la computación de borde como servicio, al menos han demostrado su valor como negocio: Las empresas pagarán primas para que se procesen algunos datos antes de que lleguen al centro, o «core», de la red.

«Hemos estado en un período bastante largo de centralización», explicó Matt Baker, vicepresidente senior de estrategia y planificación de Dell Technologies, durante una conferencia de prensa el pasado febrero. «Y a medida que el mundo busca ofrecer experiencias digitales cada vez más en tiempo real a través de sus iniciativas de transformación digital, la capacidad de aferrarse a ese enfoque altamente centralizado de las TI está empezando a fracturarse bastante.»

La computación de borde ha sido promocionada como uno de los lucrativos y nuevos mercados viables gracias a la tecnología 5G Wireless. Para que la transición global de 4G a 5G sea económicamente viable para muchas empresas de telecomunicaciones, la nueva generación debe abrir nuevos canales de ingresos explotables. El 5G requiere una amplia y nueva red de conexiones de fibra óptica (irónicamente) por cable para suministrar a los transmisores y a las estaciones base un acceso instantáneo a los datos digitales (el backhaul). Como resultado, surge una oportunidad para que una nueva clase de proveedores de servicios informáticos desplieguen múltiples µDC adyacentes a las torres de la red de acceso radioeléctrico (RAN), quizás junto a las estaciones base de las telecos o compartiendo el mismo edificio con ellas. Estos centros de datos podrían ofrecer colectivamente servicios de computación en la nube a determinados clientes a precios competitivos y con características comparables a las de los proveedores de nube de hiperescala como Amazon, Microsoft Azure y Google Cloud Platform.

Por último, tal vez después de una década de evolución, la computación de borde llevaría servicios rápidos a los clientes tan cerca como sus estaciones base inalámbricas más cercanas. Necesitaríamos enormes tuberías de fibra óptica para suministrar el backhaul necesario, pero los ingresos de los servicios de edge computing podrían financiar su construcción, lo que permitiría amortizarlos.

Objetivos de nivel de servicio

En el análisis final (si es que algún análisis ha sido alguna vez definitivo), el éxito o el fracaso de los centros de datos en los bordes de la red vendrá determinado por su capacidad para cumplir los objetivos de nivel de servicio (SLO). Estas son las expectativas de los clientes que pagan por los servicios, codificadas en sus contratos de servicio. Los ingenieros tienen métricas que utilizan para registrar y analizar el rendimiento de los componentes de la red. Los clientes tienden a evitar esas métricas y prefieren el rendimiento observable de sus aplicaciones. Si un despliegue de borde no es notablemente más rápido que un despliegue de hiperescala, entonces el borde como concepto puede morir en su infancia.

«¿Qué nos importa? Es el tiempo de respuesta de las aplicaciones», explicó Tom Gillis, vicepresidente senior de redes y seguridad de VMware, durante una reciente conferencia de la compañía. «Si podemos caracterizar cómo responde la aplicación, y observar los componentes individuales que trabajan para ofrecer esa respuesta de la aplicación, realmente podemos empezar a crear esa infraestructura de autorreparación».

La reducción de la latencia y la mejora de la velocidad de procesamiento (con servidores más nuevos dedicados a muchas menos tareas cuantitativamente) deberían jugar a favor de los SLO. Algunos también han señalado cómo la amplia distribución de recursos en un área contribuye a la redundancia del servicio e incluso a la continuidad del negocio -que, al menos hasta la pandemia, se percibían como eventos de uno o dos días, seguidos de períodos de recuperación.

Pero habrá factores de equilibrio, el más importante de los cuales tiene que ver con el mantenimiento y la conservación. Una instalación típica de centro de datos de nivel 2 puede ser mantenida, en circunstancias de emergencia (como una pandemia) por tan sólo dos personas in situ, con personal de apoyo fuera de las instalaciones. Por su parte, un µDC está diseñado para funcionar sin necesidad de personal permanente. Sus funciones de monitorización integradas envían continuamente telemetría a un núcleo central, que teóricamente podría estar en la nube pública. Mientras un µDC esté cumpliendo sus SLO, no tiene que ser atendido personalmente.

Aquí es donde la viabilidad del modelo de edge computing todavía tiene que ser probada a fondo. Con un contrato típico de proveedor de centro de datos, un SLO se suele medir por la rapidez con la que el personal del proveedor puede resolver un problema pendiente. Normalmente, los tiempos de resolución pueden ser bajos cuando el personal no tiene que llegar a los puntos problemáticos en camión. Si un modelo de despliegue de borde va a ser competitivo con un modelo de despliegue de colocación, más vale que sus capacidades de remediación automatizada sean monstruosamente buenas.

La red escalonada

Los proveedores de almacenamiento de datos, los anfitriones de aplicaciones nativas de la nube, los proveedores de servicios de Internet de las Cosas (IoT), los fabricantes de servidores, los fideicomisos de inversión inmobiliaria (REIT) y los fabricantes de armarios de servidores premontados, están preparando rutas exprés entre sus clientes y lo que promete, para cada uno de ellos, ser el borde.

Lo que todos buscan realmente es una ventaja competitiva. La idea de una ventaja da nuevas esperanzas a las perspectivas del servicio premium: una razón sólida y justificable para que ciertas clases de servicio tengan tarifas más altas que otras. Si ha leído o escuchado en algún sitio que el borde podría acabar subsumiendo toda la nube, puede entender ahora que esto no tendría mucho sentido. Si todo fuera premium, nada sería premium.

«Aparentemente, el Edge Computing va a ser la solución tecnológica perfecta, y los capitalistas de riesgo dicen que va a ser un mercado tecnológico multimillonario», comentó Kevin Brown, CTO y vicepresidente senior de innovación del proveedor de equipos de servicios de centros de datos, y fabricante de chasis para microcentros de datos, Schneider Electric. «Nadie sabe realmente lo que es».

Kevin Brown, de Schneider Electric: «Nadie sabe realmente lo que es.»

Brown reconoció que el edge computing puede atribuir su historia a las CDN pioneras, como Akamai. Sin embargo, continuó, «tienes todas estas capas diferentes – HPE tiene su versión, Cisco tiene la suya. . . No podíamos darle sentido a nada de eso. Nuestra visión del borde es realmente una visión muy simplificada. En el futuro, va a haber tres tipos de centros de datos en el mundo, de los que realmente hay que preocuparse.»

La imagen que dibujó Brown, durante un evento de prensa en la sede de la compañía en Massachusetts en febrero de 2019, es una visión reemergente de un Internet de tres niveles, y es compartida por un número creciente de empresas de tecnología. En el modelo tradicional de dos niveles, los nodos de nivel 1 se limitan a hacer peering con otros nodos de nivel 1, mientras que los nodos de nivel 2 se encargan de la distribución de datos a nivel regional. Desde los inicios de Internet, existe una designación para el nivel 3, para el acceso a un nivel mucho más local. (Contrasta esto con el esquema de la Red de Acceso Radioeléctrico celular, cuya distribución del tráfico es de un solo nivel).

«El primer punto de conexión a la red es lo que consideramos el borde local», explica Brown. En la tecnología actual, continuó, se podría encontrar una de las instalaciones de computación de borde de hoy en día en cualquier servidor metido en un rack improvisado en un armario de cableado.

«Para nuestros propósitos», continuó, «creemos que ahí es donde está la acción».

«El borde, durante años, fueron los hoteles de operadores de nivel 1 como Equinix y CoreSite. Básicamente, colocaban en capas una red que se conectaba a otra, y eso se consideraba un borde», explicó Wen Temitim, CTO del proveedor de servicios de infraestructura de borde StackPath. «Pero lo que estamos viendo, con todos los diferentes cambios de uso basados en el comportamiento del consumidor, y con COVID-19 y el trabajo desde casa, es un borde nuevo y más profundo que se está volviendo más relevante con los proveedores de servicios.»

Localizando el borde en un mapa

La computación de borde es un esfuerzo por devolver la calidad de servicio (QoS) al debate sobre la arquitectura de los centros de datos y los servicios, ya que las empresas deciden no sólo quién proporcionará sus servicios, sino también dónde.

El «borde tecnológico operativo»

El fabricante de equipos para centros de datos HPE -un importante inversor en edge computing- cree que el próximo gran salto en la infraestructura de operaciones será coordinado y dirigido por personal y contratistas que pueden no tener mucha, o ninguna, inversión personal o formación en hardware e infraestructura -personas que, hasta ahora, se han encargado en gran medida del mantenimiento, la conservación y el soporte de software. Su empresa denomina a esta clase de personal tecnología operativa (OT). A diferencia de quienes perciben que la TI y las operaciones convergen en una u otra forma de «DevOps», HPE percibe tres clases de clientes de edge computing. No sólo cada una de estas clases, en su opinión, mantendrá su propia plataforma de edge computing, sino que la geografía de estas plataformas se separará entre sí, no convergerá, como muestra este diagrama de HPE.

Aquí hay tres clases distintas de clientes, cada una de las cuales HPE ha repartido su propio segmento del borde en general. La clase OT se refiere aquí a los clientes más propensos a asignar gerentes a la computación de borde que tienen menos experiencia directa con la TI, principalmente porque sus productos principales no son la información o las comunicaciones en sí. A esa clase se le asigna un «borde OT». Cuando una empresa tiene una inversión más directa en la información como industria, o depende en gran medida de la información como componente de su negocio, HPE le atribuye un «edge IT». En medio, para aquellas empresas que están dispersas geográficamente y dependen de la logística (donde la información tiene un componente más lógico) y por tanto del Internet de las Cosas, HPE le da un «IoT edge.»

La red tripartita de Dell

En 2017, Dell Technologies ofreció por primera vez su topología de tres niveles para el mercado informático en general, dividiéndolo en «núcleo», «nube» y «borde». Como indica esta diapositiva de una primera presentación de Dell, esta división parecía radicalmente sencilla, al menos al principio: Los activos de TI de cualquier cliente podrían dividirse, respectivamente, en 1) lo que posee y mantiene con su propio personal; 2) lo que delega en un proveedor de servicios y lo contrata para que lo mantenga; y 3) lo que distribuye más allá de sus instalaciones de origen en el campo, para que lo mantengan los profesionales de operaciones (que pueden o no ser subcontratados).

En una presentación de noviembre de 2018 para la Embedded Linux Conference Europe de la Fundación Linux, el CTO de IoT y Edge Computing Jason Shepherd expuso este sencillo caso: Dado que se están planeando muchos dispositivos y aparatos en red para IoT, será tecnológicamente imposible centralizar su gestión, incluso si alistamos la nube pública.

«Mi mujer y yo tenemos tres gatos», dijo Shepherd a su audiencia. «Conseguimos mayores capacidades de almacenamiento en nuestros teléfonos, para poder enviar vídeos de gatos de un lado a otro.

«Los vídeos de gatos explican la necesidad del edge computing», continuó. «Si cuelgo uno de mis vídeos en línea, y empieza a recibir visitas, tengo que almacenarlo en caché en más servidores, muy atrás en la nube. Si se vuelve viral, tengo que trasladar ese contenido lo más cerca posible de los suscriptores. Como empresa de telecomunicaciones, o como Netflix o lo que sea, lo más cerca que puedo estar es en el borde de la nube, en la parte inferior de mis torres de telefonía, estos puntos clave de Internet. Este es el concepto de MEC, Multi-access Edge Computing: acercar el contenido a los abonados. Pues bien, si tengo miles de millones de personas conectadas que llaman al gato, he cambiado completamente el paradigma, y en lugar de que las cosas traten de tirar hacia abajo, tengo todos estos dispositivos que tratan de empujar hacia arriba. Eso hace que tenga que empujar el cómputo aún más hacia abajo».

La emergente ‘nube de borde’

Desde el estreno mundial del gatito asustado de Shepherd, el concepto de borde de Dell se ha endurecido un poco, pasando de un montaje matizado de capas a una ética de descentralización más básica.

«Vemos el borde como algo que realmente se define no necesariamente por un lugar específico o una tecnología específica», dijo Matt Baker de Dell el pasado febrero. «En cambio, es una complicación del despliegue existente de TI en el sentido de que, debido a que estamos descentralizando cada vez más nuestros entornos de TI, nos encontramos con que estamos poniendo soluciones de infraestructura de TI, software, etc., en entornos cada vez más limitados. Un centro de datos es un entorno en gran medida sin restricciones; lo construyes con las especificaciones que quieres, puedes refrigerarlo adecuadamente, hay mucho espacio. Pero a medida que colocamos más y más tecnología en el mundo que nos rodea, para facilitar la entrega de estas experiencias digitales en tiempo real, nos encontramos en lugares que tienen algún tipo de desafío.»

Las redes de los campus, dijo Baker, incluyen equipos que tienden a ser polvorientos y sucios, además de tener una conectividad de bajo ancho de banda. Los entornos de telecomunicaciones suelen incluir racks de muy poca profundidad que requieren una población de procesadores de muy alta densidad. Y en los lugares más alejados del mapa, hay una escasez de mano de obra cualificada de TI, «lo que ejerce una mayor presión sobre la capacidad de gestionar entornos altamente distribuidos de forma desatendida y sin personal.»

Sin embargo, a un número cada vez mayor de clientes les corresponde procesar los datos más cerca del punto donde se evalúan o crean por primera vez, argumentó. Eso sitúa la ubicación de «el borde», alrededor de 2020, en cualquier punto del mapa en el que se encuentren los datos, a falta de una mejor descripción, prendiendo fuego.

Temitim, de StackPath, cree que ese punto es un concepto emergente llamado «edge cloud» (nube de borde), una colección virtual de múltiples despliegues de borde en una sola plataforma. Esta plataforma se comercializaría en un primer momento para los distribuidores de vídeo multicanal (MVPD, normalmente compañías de cable incumbentes, pero también algunas telecos) que busquen poseer sus propias redes de distribución y reducir costes a largo plazo. Pero como fuente de ingresos adicional, estos proveedores podrían ofrecer servicios similares a los de la nube pública, como aplicaciones SaaS o incluso alojamiento de servidores virtuales, en nombre de clientes comerciales.

Este mercado de la «nube de borde» podría competir directamente con los centros de datos de nivel 2 y 3 del mundo. Dado que los operadores de estas instalaciones suelen ser clientes premium de las telecos de sus respectivas regiones, estas podrían percibir la nube de borde como una amenaza competitiva para sus propios planes de 5G Wireless. Es realmente, como dijo un proveedor de infraestructura de borde, un «acaparamiento físico de tierras». Y el acaparamiento no ha hecho más que empezar.

Más información – De la red interactiva de la CBS

- Cómo la computación de borde puede renovar y revitalizar los bienes raíces comerciales por Larry Dignan, Between the Lines

- Es una carrera hacia el borde, y el fin de la computación en nube como la conocemos por Scott M. Fulton, III, Scale

- Haga de la computación de borde una inversión clave para 2020 por Forrester Research

En otros lugares

- El centro de datos que es una mesa de café por Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com