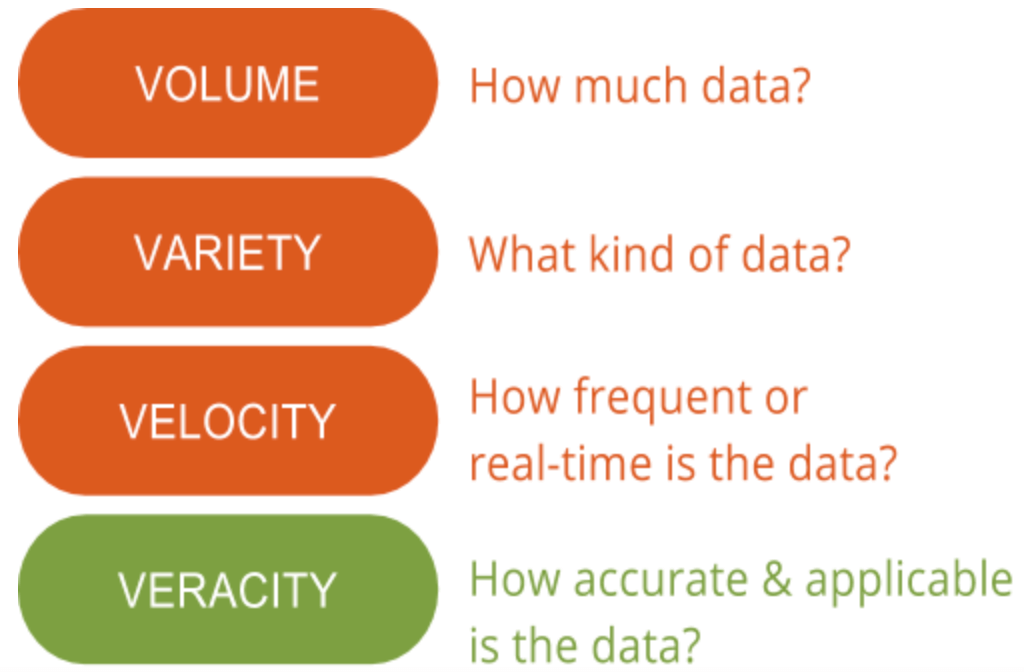

Aquí en GutCheck, hablamos mucho de las 4 «V» del Big Data: volumen, variedad, velocidad y veracidad. Hay una «V» en la que destacamos la importancia por encima de todas las demás: la veracidad. La veracidad de los datos es el área que todavía tiene potencial de mejora y plantea el mayor desafío en lo que respecta a los grandes datos. Con tantos datos disponibles, asegurarse de que son relevantes y de alta calidad es la diferencia entre los que utilizan con éxito los big data y los que tienen dificultades para entenderlos.

Entender la importancia de la veracidad de los datos es el primer paso para discernir la señal del ruido cuando se trata de big data. En otras palabras, la veracidad ayuda a filtrar lo que es importante y lo que no lo es, y al final, genera una comprensión más profunda de los datos y cómo contextualizarlos para tomar medidas.

Entender la importancia de la veracidad de los datos es el primer paso para discernir la señal del ruido cuando se trata de big data. En otras palabras, la veracidad ayuda a filtrar lo que es importante y lo que no lo es, y al final, genera una comprensión más profunda de los datos y cómo contextualizarlos para tomar medidas.

¿Qué es la veracidad de los datos?

La veracidad de los datos, en general, es lo preciso o veraz que puede ser un conjunto de datos. Sin embargo, en el contexto de los big data, adquiere un significado un poco más amplio. Más concretamente, cuando se trata de la exactitud de los big data, no se trata sólo de la calidad de los datos en sí, sino de la fiabilidad de la fuente de datos, el tipo y el procesamiento de los mismos. La eliminación de elementos como el sesgo, las anomalías o incoherencias, la duplicación y la volatilidad son solo algunos aspectos que contribuyen a mejorar la precisión de los big data.

Desgraciadamente, a veces la volatilidad no está bajo nuestro control. La volatilidad, a veces denominada otra «V» de big data, es la tasa de cambio y el tiempo de vida de los datos. Un ejemplo de datos muy volátiles son las redes sociales, donde los sentimientos y los temas de tendencia cambian rápidamente y con frecuencia. Los datos menos volátiles se parecerían más a las tendencias meteorológicas, que cambian con menos frecuencia y son más fáciles de predecir y rastrear.

La segunda cara de la veracidad de los datos implica garantizar que el método de procesamiento de los datos reales tenga sentido en función de las necesidades del negocio y que el resultado sea pertinente para los objetivos. Obviamente, esto es especialmente importante cuando se incorporan estudios de mercado primarios con big data. Interpretar los big data de forma correcta garantiza que los resultados sean relevantes y procesables. Además, el acceso a los macrodatos significa que se pueden pasar meses clasificando la información sin centrarse y sin un método para identificar qué puntos de datos son relevantes. Como resultado, los datos deben ser analizados de manera oportuna, como es difícil con el big data, de lo contrario los conocimientos no serían útiles.

Por qué es importante

El big data es altamente complejo, y como resultado, los medios para entenderlo e interpretarlo todavía están siendo completamente conceptualizados. Aunque muchos piensan que el aprendizaje automático tendrá un gran uso para el análisis de big data, los métodos estadísticos siguen siendo necesarios para garantizar la calidad de los datos y la aplicación práctica de big data para los investigadores de mercado. Por ejemplo, usted no se descargaría un informe del sector de Internet y lo utilizaría para tomar medidas. En su lugar, lo más probable es que lo valide o lo utilice como base para una investigación adicional antes de formular sus propias conclusiones. El big data no es diferente; no se puede tomar el big data tal cual sin validarlo o explicarlo. Pero a diferencia de la mayoría de las prácticas de investigación de mercado, el big data no tiene una base sólida con la estadística.

Por eso hemos dedicado tiempo a entender las plataformas de gestión de datos y el big data para seguir siendo pioneros en métodos que integren, agreguen e interpreten los datos con una precisión de grado de investigación como los métodos probados a los que estamos acostumbrados. Parte de estos métodos incluyen la indexación y la limpieza de los datos, además del uso de datos primarios para ayudar a dar más contexto y mantener la veracidad de los conocimientos.

Muchas organizaciones no pueden dedicar todo el tiempo necesario para discernir realmente si una fuente de big data y un método de procesamiento mantienen un alto nivel de veracidad. Trabajar con un socio que conozca los fundamentos del big data en la investigación de mercados puede ayudar. Para saber cómo un cliente nuestro aprovechó los conocimientos basados en las encuestas y los (grandes) datos sobre el comportamiento, eche un vistazo al estudio de caso que aparece a continuación. También verás cómo fueron capaces de conectar los puntos y desbloquear el poder de la inteligencia de la audiencia para impulsar una mejor estrategia de segmentación del consumidor.