- Vezetői összefoglaló

- A vállalati hálózatok jelenlegi topológiája

- Potenciális előnyök

- Potenciális buktatók

- Mit jelent az “edge computing” kifejezés?

- Hogyan törtek utat a CDN-ek

- A decentralizáció irányába mutató tendencia

- Szolgáltatási szintű célkitűzések

- A többszintű hálózat

- A perem elhelyezése a térképen

- Az “üzemeltetési technológiai perem”

- A Dell háromoldalú hálózata

- A kialakulóban lévő “edge cloud”

- Tudjon meg többet – A CBS Interactive Networkből

- Máshol

Vezetői összefoglaló

Minden hálózat peremén lehetőség nyílik arra, hogy a szervereket, processzorokat és adattároló tömböket a lehető legközelebb helyezzük azokhoz, akik a legjobban ki tudják használni őket. Ahol csökkenteni lehet a távolságot, mivel az elektronok sebessége lényegében állandó, ott minimalizálható a késleltetés. A széleken való használatra tervezett hálózat kihasználja ezt a minimális távolságot a szolgáltatás felgyorsítása és az értékteremtés érdekében.

A peremhelyen történő használatra tervezett modern kommunikációs hálózatban – például egy 5G vezeték nélküli hálózatban – két lehetséges stratégia működik:

- Az adatfolyamok, a hang és a videó gyorsabban és kevesebb szünettel (lehetőleg egyáltalán nem) érkezhetnek, ha a szervereket a felhasználóktól minimális számú közbenső útválasztási pont vagy “ugrás” választja el. Az olyan szolgáltatók, mint az Akamai, a Cloudflare és az NTT Communications tartalomszolgáltató hálózatai (CDN) erre a stratégiára épülnek.

- Az alkalmazások gyorsabbak lehetnek, ha processzoraik közelebb helyezkednek el az adatgyűjtés helyéhez. Ez különösen igaz a logisztika és a nagyméretű gyártás alkalmazásaira, valamint a tárgyak internetére (IoT), ahol az érzékelők vagy adatgyűjtő eszközök nagy számban és nagymértékben elosztva vannak.

Az alkalmazástól függően, ha valamelyik vagy mindkét peremstratégiát alkalmazzák, ezek a szerverek valójában a hálózat egyik vagy másik végére kerülhetnek. Mivel az internet nem úgy épül fel, mint a régi telefonhálózat, a “közelebb” az útválasztás célszerűsége szempontjából nem feltétlenül jelenti a földrajzi távolságot. És attól függően, hogy a szervezet hány különböző típusú szolgáltatóval kötött szerződést – nyilvános felhőalkalmazás-szolgáltatók (SaaS), alkalmazásplatform-szolgáltatók (PaaS), bérelt infrastruktúra-szolgáltatók (IaaS), tartalomszolgáltató hálózatok -, az informatikai ingatlanok több területe is versenyezhet azért, hogy egyszerre legyen “a szélső”.

Egy Schneider Electric mikroadatközpont-szekrény belsejében

Scott Fulton

A vállalati hálózatok jelenlegi topológiája

A legtöbb vállalat három helyen szokta telepíteni és kezelni saját alkalmazásait és szolgáltatásait:

- Helyszínen, ahol az adatközpontokban több szerverállványt helyeznek el, ahol rendelkeznek az áramellátáshoz és hűtéshez szükséges erőforrásokkal, és ahol dedikált kapcsolat van a külső erőforrásokkal

-

- Colocation létesítmények, ahol az ügyfélberendezéseket egy teljesen menedzselt épületben helyezik el, ahol az áramellátás, hűtés, és a csatlakoztathatóságot szolgáltatásként biztosítják

- Felhőszolgáltatók, ahol az ügyfél infrastruktúrája bizonyos mértékig virtualizálható, és a szolgáltatásokat és alkalmazásokat felhasználásonként biztosítják, lehetővé téve, hogy a műveleteket nem tőkekiadásokként, hanem működési költségként számolják el

Az edge computing tervezői negyedik kategóriaként igyekeznének hozzáadni a tervüket ehhez a listához: Olyan, amely kihasználja a kisebb, konténeres létesítmények hordozhatóságát kisebb, modulárisabb szerverekkel, hogy csökkentse a távolságot a feldolgozási pont és a funkcionalitás fogyasztási pontja között a hálózatban. Ha terveik megvalósulnak, a következőket kívánják elérni:

Potenciális előnyök

- Minimális késleltetés. A felhőalapú számítástechnikai szolgáltatásokkal ma az a probléma, hogy lassúak, különösen a mesterséges intelligenciával támogatott munkaterhelések esetében. Ez lényegében kizárja a felhőt a determinisztikus alkalmazások, például a valós idejű értékpapírpiaci előrejelzések, az autonóm járművezetés és a közlekedési forgalomirányítás komoly használatából. A kis adatközpontokban elhelyezett processzorok, amelyek közelebb vannak ahhoz, ahol a folyamatokat használni fogják, új piacokat nyithatnak a számítástechnikai szolgáltatások számára, amelyeket a felhőszolgáltatók eddig nem tudtak kezelni. Egy IoT-forgatókönyvben, ahol az önálló, adatgyűjtő készülékek klaszterei széles körben eloszlanak, a processzoroknak az ilyen készülékek akár alcsoportjaihoz vagy klasztereihez is közelebbi elhelyezése jelentősen javíthatná a feldolgozási időt, így a valós idejű elemzések sokkal szemcsésebb szinten megvalósíthatók lennének.

- Egyszerűsített karbantartás. Egy olyan vállalat számára, amelynek nem okoz nagy gondot egy teherautó- vagy karbantartóautó-flotta helyszínekre küldése, a mikroadatközpontokat (µDC) a maximális elérhetőség, a modularitás és az ésszerű mértékű hordozhatóság érdekében tervezték. Ezek olyan kompakt házak, amelyek némelyike elég kicsi ahhoz, hogy elférjen egy kisteherautó hátuljában, és éppen elegendő szervert tudnak támogatni az időkritikus funkciók hosztolásához, amelyeket a felhasználókhoz közelebb lehet telepíteni. Elképzelhető, hogy egy olyan épület esetében, amely jelenleg az alagsorban helyezi el, táplálja és hűti az adatközpont eszközeit, az egész művelet felváltása három vagy négy µDC-vel valahol a parkolóban valóban előrelépést jelenthet.

- Olcsóbb hűtés. A nagy adatközpont-komplexumok esetében a hűtésre felhasznált villamos energia havi költsége könnyen meghaladhatja a feldolgozásra felhasznált villamos energia költségét. A kettő közötti arányt energiafelhasználási hatékonyságnak (PUE) nevezik. Időnként ez volt az adatközpontok hatékonyságának alapvető mérőszáma (bár az utóbbi években a felmérések szerint egyre kevesebb IT-üzemeltető tudja, mit is jelent valójában ez az arány). Elméletileg egy vállalkozásnak kevesebbe kerülhet több kisebb adatközpont hűtése és kondicionálása, mint egy nagy adatközponté. Ráadásul, mivel egyes villamosenergia-szolgáltatási területek sajátos módon kezelik a számlázást, a kilowattonkénti költségek összességében csökkenhetnek, ha ugyanazokat a szerverállványokat több kisebb létesítményben helyezik el, mint egy nagyban. A Schneider Electric által közzétett 2017-es fehér könyv a hagyományos és a mikro-adatközpontok építésével kapcsolatos összes kisebb és nagyobb költséget értékelte. Míg egy vállalkozásnak egy hagyományos 1 MW-os létesítmény megépítéséért valamivel kevesebb mint 7 millió dollár tőkeköltséget jelentene, addig 200 darab 5 KW-os létesítmény megkönnyítésére alig több mint 4 millió dollárt költene.

- Klímatudatosság. Mindig is volt egyfajta ökológiai vonzereje annak az elképzelésnek, hogy a számítási teljesítményt szélesebb földrajzi területen osztják szét az ügyfelek között, szemben azzal, hogy ezt a teljesítményt mamut, hiperskála létesítményekben központosítják, és nagy sávszélességű optikai szálakra támaszkodnak az összeköttetéshez. Az edge computing korai marketingje a hallgatóság józan ésszel felfogott benyomásaira támaszkodik, miszerint a kisebb létesítmények még együttesen is kevesebb energiát fogyasztanak. De a zsűri még mindig nem tudja, hogy ez valóban igaz-e. A szlovákiai Kassai Műszaki Egyetem kutatóinak 2018-as tanulmánya , amely egy IoT-forgatókönyvben szimulált edge computing telepítéseket használt, arra a következtetésre jutott, hogy a edge energiahatékonysága szinte teljes mértékben az ott végzett számítások pontosságától és hatékonyságától függ. Megállapították, hogy a nem hatékony számítások által okozott többletköltségeket valójában felnagyítja a rossz programozás.

Ha mindez túl bonyolult rendszernek hangzik ahhoz, hogy megvalósítható legyen, tartsa szem előtt, hogy jelenlegi formájában a nyilvános felhőalapú számítástechnikai modell nem biztos, hogy hosszú távon fenntartható. Ebben a modellben az előfizetőknek továbbra is olyan hiperszintű komplexumokkal összekapcsolt csöveken keresztül kellene alkalmazásokat, adat- és tartalomfolyamokat tolniuk, amelyek szolgáltatási területe egész államokat, tartományokat és országokat ölel fel – egy olyan rendszer, amellyel a vezeték nélküli hangszolgáltatók soha nem mertek volna próbálkozni.

Potenciális buktatók

Mindamellett egy teljesen az edge computing modell szerint átalakított számítástechnikai világ körülbelül olyan fantasztikus – és olyan távoli -, mint egy olyan közlekedési világ, amely teljesen leszoktatta magát a kőolaj-üzemanyagokról. A közeljövőben az edge computing modellnek néhány jelentős akadállyal kell szembenéznie, amelyek közül többet nem lesz könnyű leküzdeni:

- A háromfázisú áram távoli elérhetősége. A kereskedelmi ügyfelek számára felhőszerű távoli szolgáltatások nyújtására alkalmas szervereknek – függetlenül attól, hogy hol találhatók – nagy teljesítményű processzorokra és memórián belüli adatokra van szükségük, hogy lehetővé tegyék a többszemélyes használatot. Valószínűleg kivétel nélkül nagyfeszültségű, háromfázisú áramhoz való hozzáférésre lesz szükségük. Ezt a viszonylag távoli, vidéki helyszíneken rendkívül nehéz, ha nem lehetetlen elérni. (A szokásos 120 V-os váltakozó áram egyfázisú.) A távközlési bázisállomásoknak eddig soha nem volt szükségük ilyen szintű áramellátásra, és ha soha nem tervezik, hogy többszemélyes kereskedelmi felhasználásra használják őket, akkor talán soha nem is lesz szükségük háromfázisú áramra. Az egyetlen ok az áramellátó rendszer utólagos felszerelésére az lenne, ha az edge computing életképes lenne. De a széles körben elosztott Internet-of-Things alkalmazások esetében, mint például a Mississippi távoli szívmonitorokkal kapcsolatos kísérletei, a megfelelő teljesítmény-infrastruktúra hiánya végül ismét elválaszthatja a “rendelkezőket” a “nem rendelkezők”-től.”

-

- A szerverek feldarabolása védett virtuális szeletekre. Ahhoz, hogy az 5G átállás megfizethető legyen, a távközlési vállalatoknak további bevételt kell realizálniuk az edge computingból. Ami az 5G-hez kötötte az edge computing evolúciójának ötletét, az az az elképzelés volt, hogy a kereskedelmi és az üzemeltetési funkciók ugyanazon a szervereken létezhetnek együtt – ez az elképzelés a Central Office Re-architected as a Datacenter (CORD) (eredetileg “Re-imagined”) által bevezetett koncepció, amelynek egyik formáját ma az 5G Wireless egyik kulcsfontosságú elősegítőjének tekintik. A baj az, hogy még az sem biztos, hogy legális, ha a távközlési hálózat szempontjából alapvető fontosságú műveletek és az ügyfélfunkciók ugyanazon rendszereken tartózkodnak együtt – a válaszok attól függnek, hogy a törvényhozók képesek-e megfejteni a “rendszerek” új definícióját. Addig a napig (ha valaha is eljön) a 3GPP (az 5G szabványokat irányító iparági szervezet) elfogadta a hálózati szeletelés nevű koncepciót, amely a távközlési hálózati szerverek virtuális szerverekre való feldarabolását jelenti nagyon alacsony szinten, sokkal nagyobb elkülönítéssel, mint egy tipikus virtualizációs környezetben, mondjuk a VMware-től. Elképzelhető, hogy egy ügyfélközpontú hálózati szeletet lehetne telepíteni a távközlési hálózatok szélén, amely korlátozott számú ügyfelet szolgál ki. Egyes nagyobb vállalatok azonban inkább maguk kezébe vennék a saját hálózati szeleteiket, még akkor is, ha ez azt jelenti, hogy saját létesítményeikben telepítik őket – a széleket a saját telephelyükre költöztetik -, minthogy egy olyan új rendszerbe fektessenek be, amelynek értéke nagyrészt a reményen alapul.

- A távközlési vállalatok megvédik a saját területüket a helyi kitörésekkel szemben. Ha az 5G rádió-hozzáférési hálózatot (RAN) és a hozzá kapcsolódó optikai kábeleket kereskedelmi ügyfélszolgáltatásokra akarják kihasználni, akkor valamilyen átjárónak kell lennie, amely elszipkázza a magánügyfélforgalmat a távközlési forgalomtól. Egy ilyen átjáró architektúrája már létezik, és a 3GPP hivatalosan elfogadta. Ezt hívják helyi kitörésnek, és ez is része az ETSI szabványügyi testület hivatalos nyilatkozatának a multi-access edge computingról (MEC). Tehát technikailag ez a probléma megoldódott. A probléma az, hogy egyes távközlési vállalatoknak érdekükben állhat megakadályozni, hogy az ügyfélforgalom eltérüljön a szokásos útvonaltól: a saját adatközpontjaikba. A mai internetes hálózati topológia három szintből áll: Az 1. szintű szolgáltatók csak egymással állnak kapcsolatban, míg a 2. szintű internetszolgáltatók jellemzően az ügyfelekkel állnak kapcsolatban. A harmadik szint lehetővé teszi a kisebb, regionális internetszolgáltatókat helyi szinten. A globális léptékű edge computing katalizátora lehet a nyilvános felhő jellegű szolgáltatásoknak, amelyeket az internetszolgáltatók helyi szinten, esetleg egyfajta “áruházláncon” keresztül kínálnak. De ez feltételezi, hogy a második szintet kezelő távközlési vállalatok hajlandóak megengedni, hogy a bejövő hálózati forgalmat egy harmadik szintre bontják, lehetővé téve a versenyt egy olyan piacon, amelyet nagyon könnyen maguknak követelhetnének.

Ha a vállalat számára ismét a hely, a hely, a hely számít, akkor az egész vállalati számítástechnikai piac a feje tetejére állhat. A felhőalapú adatközpontok hiperszintű, központosított, energiaigényes jellege végül ellenük dolgozhat, mivel a kisebb, mozgékonyabb, költséghatékonyabb üzemeltetési modellek – ha minden a tervek szerint alakul – pitypangként szöknek szárba a szélesebb körben elosztott helyszíneken.

“Úgy vélem, hogy az edge telepítések iránti érdeklődést” – jegyezte meg Kurt Marko, a Marko Insights technológiai elemző cég igazgatója a ZDNetnek küldött jegyzetében – “elsősorban az “intelligens” eszközök, érzékelők és felhasználók – különösen a mobil/vezeték nélküli felhasználók – által generált hatalmas mennyiségű adat feldolgozásának igénye vezérli. Az 5G-hálózatok adatátviteli sebessége és áteresztőképessége, valamint az ügyfelek eszkalálódó adatfelhasználása ugyanis megköveteli, hogy a mobil bázisállomások mini adatközpontokká váljanak”.

Mit jelent az “edge computing” kifejezés?

Minden távközlési hálózatban a perem a létesítmények és szolgáltatások legtávolabbi, az ügyfelek felé eső része. A peremszámítástechnikával összefüggésben a perem az a hely a bolygón, ahol a szerverek a legcélszerűbb módon juttathatják el a funkciókat az ügyfelekhez.

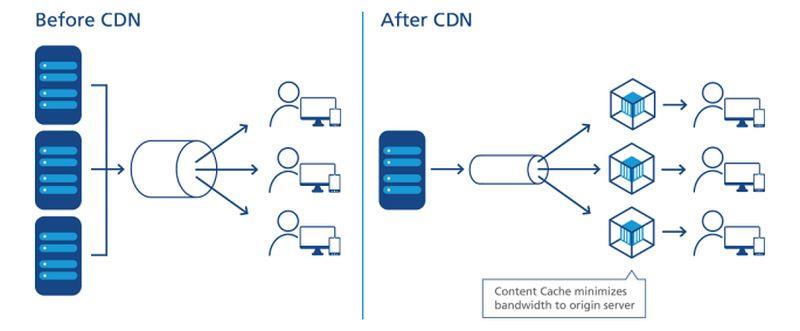

Hogyan törtek utat a CDN-ek

Az adatközpontok és az Internet-of-Things eszközök közötti kapcsolat ábrázolása az Industrial Internet Consortium által.

Az internet tekintetében a számítást vagy a feldolgozást szerverek végzik – ezek az összetevők általában a hálózati diagram középpontjához vagy fókuszpontjához közeli alakzattal (például felhővel) ábrázolt komponensek. Az adatokat a diagram szélein lévő eszközökről gyűjtik, és feldolgozás céljából a középpont felé húzzák. A feldolgozott adatokat, mint a finomítóból származó olajat, visszaszivattyúzzák a perem felé szállításra. A CDN-ek felgyorsítják ezt a folyamatot azáltal, hogy “töltőállomásként” működnek a környezetükben lévő felhasználók számára. A hálózati szolgáltatások tipikus termékéletciklusa magában foglalja ezt az “oda-vissza” folyamatot, ahol az adatokat ténylegesen kitermelik, elszállítják, finomítják és újra elszállítják. És mint minden logisztikával járó folyamatban, a szállítás is időt vesz igénybe.

A CDN-kiszolgálók pontos képi elhelyezése az adatátviteli folyamatban.

NTT Communictions

Az, hogy a CDN mindig az ábra közepén helyezkedik-e el, attól függ, hogy kinek az ábráját nézzük. Ha a CDN-szolgáltató rajzolta meg, akkor lehet, hogy egy nagy “CDN” felhő van középen, az egyik oldal szélei mentén a vállalati hálózatok, a többi szélén pedig a felhasználói berendezések eszközei. Az egyik kivétel az NTT-től származik, amelynek fenti egyszerűsített, de pontosabb ábrája szerint a CDN-kiszolgálók az adathozzáférési pont és a felhasználók közé vannak beillesztve. Az adatok vagy tartalmak előállítóinak szemszögéből nézve, szemben a kézbesítőkkel, a CDN-ek az ellátási lánc végén helyezkednek el – az utolsó előtti lépés az adatok esetében, mielőtt a felhasználó megkapja azokat.

Az elmúlt évtizedben a nagy CDN-szolgáltatók olyan számítástechnikai szolgáltatásokat kezdtek bevezetni, amelyek a kézbesítési ponton helyezkednek el. Képzelje el, ha egy töltőállomás a saját finomítója lehetne, és máris érti az ötletet. Ennek a szolgáltatásnak az értékteremtése azon múlik, hogy a CDN-eket nem a központban, hanem a szélén érzékeljük. Lehetővé teszi, hogy bizonyos adatok megkerüljék a szállítás szükségességét, csak feldolgozzák és visszaszállítsák őket.

A decentralizáció irányába mutató tendencia

Ha a CDN-ek még nem is bizonyították az edge computing mint szolgáltatás hatékonyságát, legalább megmutatták, hogy üzletként mennyire értékes: A vállalatok felárat fizetnek azért, hogy bizonyos adatokat feldolgozzanak, mielőtt azok elérnék a hálózat központját vagy “magját”.

“A központosítás elég hosszú időszakát éltük meg” – magyarázta Matt Baker, a Dell Technologies stratégiai és tervezési vezető alelnöke egy tavaly februári sajtótájékoztatón. “És ahogy a világ egyre inkább valós idejű digitális élmények nyújtására törekszik a digitális átalakítási kezdeményezései révén, az IT-nek ehhez az erősen centralizált megközelítéséhez való ragaszkodás képessége kezd eléggé megtörni.”

A csúcstechnológiát az 5G vezeték nélküli technológia által megvalósíthatóvá váló egyik jövedelmező, új piacként emlegették. Ahhoz, hogy a 4G-ről az 5G-re való globális átállás számos távközlési vállalat számára gazdaságilag megvalósítható legyen, az új generációnak új, kihasználható bevételi csatornákat kell nyitnia. Az 5G-hez (ironikusan) vezetékes, optikai szálas összeköttetések hatalmas, új hálózatára van szükség, hogy az adók és bázisállomások azonnali hozzáférést kapjanak a digitális adatokhoz (a backhaul). Ennek eredményeként lehetőség nyílik a számítástechnikai szolgáltatók új osztálya számára, hogy több µDC-t telepítsenek a rádió-hozzáférési hálózat (RAN) tornyai mellé, esetleg a távközlési bázisállomások mellé, vagy azokkal közös épületbe. Ezek az adatközpontok együttesen felhőalapú számítástechnikai szolgáltatásokat kínálhatnának a kiválasztott ügyfeleknek az olyan hiperszintű felhőszolgáltatókkal versenyképes áron és azokhoz hasonló jellemzőkkel, mint az Amazon, a Microsoft Azure és a Google Cloud Platform.

A szélsőséges számítástechnika talán egy évtizedes fejlődés után talán olyan közel hozhatná el a gyors szolgáltatásokat az ügyfelekhez, mint a legközelebbi vezeték nélküli bázisállomások. Hatalmas üvegszálas csövekre lenne szükség a szükséges backhaul biztosításához, de az edge computing-szolgáltatásokból származó bevételek elképzelhető, hogy finanszírozni tudnák a kiépítésüket, lehetővé téve, hogy a rendszer megtérüljön.

Szolgáltatási szintű célkitűzések

A végső elemzésben (ha egyáltalán van egyáltalán végleges elemzés) a hálózati széleken lévő adatközpontok sikerét vagy kudarcát az határozza meg, hogy képesek-e teljesíteni a szolgáltatási szintű célkitűzéseket (SLO). Ezek a szolgáltatásokért fizető ügyfelek elvárásai, amelyeket a szolgáltatási szerződésekben rögzítenek. A mérnököknek vannak mérőszámaik, amelyeket a hálózati komponensek teljesítményének rögzítésére és elemzésére használnak. Az ügyfelek általában kerülik ezeket a mérőszámokat, és inkább az alkalmazások megfigyelhető teljesítményét részesítik előnyben. Ha egy edge telepítés nem érezhetően gyorsabb, mint egy hiperscale telepítés, akkor az edge mint koncepció még gyerekcipőben járhat.

“Mi érdekel minket? Az alkalmazások válaszideje” – magyarázta Tom Gillis, a VMware hálózatépítésért és biztonságért felelős vezető alelnöke egy nemrégiben tartott vállalati konferencián. “Ha jellemezni tudjuk, hogyan reagál az alkalmazás, és meg tudjuk nézni az egyes komponenseket, amelyek az alkalmazás válaszának biztosításán dolgoznak, akkor ténylegesen elkezdhetjük létrehozni az öngyógyító infrastruktúrát”.

A késleltetés csökkenése és a feldolgozási sebesség javulása (mivel az újabb szerverek mennyiségileg jóval kevesebb feladatot látnak el) az SLO-k előnyére kell, hogy váljon. Egyesek arra is rámutattak, hogy az erőforrások széleskörű elosztása egy területen hozzájárul a szolgáltatások redundanciájához, sőt az üzletmenet folytonosságához is – amelyeket, legalábbis a világjárványig, egy- vagy kétnapos eseményeknek tekintettek, amelyeket helyreállítási időszakok követtek.

Mégis lesznek kiegyensúlyozó tényezők, amelyek közül a legfontosabbak a karbantartással és a fenntartással kapcsolatosak. Egy tipikus Tier-2 adatközpontot vészhelyzetben (például világjárvány esetén) akár két ember is karbantarthat a helyszínen, a támogató személyzet pedig a helyszínen kívül tartózkodik. Eközben a µDC-t úgy tervezték, hogy állandó személyzet nélkül működjön. Beépített felügyeleti funkciói folyamatosan telemetriát küldenek egy központi központba, amely elméletileg a nyilvános felhőben is lehet. Amíg a µDC teljesíti az SLO-kat, addig nem kell személyesen jelen lenni.

Ez az a pont, ahol az edge computing modell életképességét még alaposan ki kell próbálni. Egy tipikus adatközpont-szolgáltatói szerződés esetében az SLO-t gyakran azon mérik, hogy a szolgáltató személyzete milyen gyorsan képes megoldani egy fennálló problémát. Jellemzően a megoldási idők alacsonyak maradhatnak, ha a személyzetnek nem kell teherautóval eljutnia a hibapontokhoz. Ha egy edge telepítési modell versenyképes akar lenni egy kolokációs telepítési modellel szemben, akkor az automatizált javítási képességeknek jobb, ha ijesztően jók.

A többszintű hálózat

Az adattárolási szolgáltatók, a felhő-natív alkalmazások tárhelyei, a tárgyak internetének (IoT) szolgáltatói, a szervergyártók, az ingatlanbefektetési társaságok (REIT) és az előre összeszerelt szerverházak gyártói mind expressz útvonalakat építenek ki ügyfeleik és a mindannyiuk számára szélestelepítésnek ígérkező terület között.

Az, amit valójában mindannyian keresnek, az a versenyelőny. Az előny gondolata új reményt ad a prémium szolgáltatás kilátásainak – egy szilárd, indokolt okot arra, hogy bizonyos szolgáltatási osztályok magasabb árakat követeljenek, mint mások. Ha olvastad vagy hallottad máshol, hogy az edge végül az egész felhőt magába foglalhatja, akkor most talán megérted, hogy ennek valójában nem sok értelme lenne. Ha minden prémium lenne, semmi sem lenne prémium.

“Az edge computing nyilvánvalóan a tökéletes technológiai megoldás lesz, és a kockázati tőkebefektetők szerint ez egy több milliárd dolláros technológiai piac lesz” – jegyezte meg Kevin Brown, az adatközpont-szolgáltató berendezések és mikro-adatközpontok alvázait gyártó Schneider Electric technológiai igazgatója és innovációs alelnöke. “Valójában senki sem tudja, hogy mi is ez valójában.”

Kevin Brown, Schneider Electric: “Senki sem tudja, mi ez valójában.”

Brown elismerte, hogy az edge computing története az úttörő CDN-eknek, például az Akamai-nak tulajdonítható. Mégis, folytatta, “ott vannak ezek a különböző rétegek – a HPE-nek megvan a saját verziója, a Cisco-nak a sajátja. . . Egyiknek sem tudtunk értelmet adni. A mi szemléletünk a peremről valóban egy nagyon leegyszerűsített szemléletet alkalmaz. A jövőben háromféle adatközpont lesz a világon, amelyek miatt valóban aggódni kell”.

A kép, amelyet Brown a vállalat massachusettsi székhelyén 2019 februárjában tartott sajtóeseményen rajzolt, a háromszintű internet újra megjelenő nézete, és amelyet egyre több technológiai cég oszt. A hagyományos kétszintű modellben a Tier-1 csomópontok más Tier-1 csomópontokkal való peeringre korlátozódnak, míg a Tier-2 csomópontok az adatok regionális szintű elosztását végzik. Az internet kezdete óta létezik egy Tier-3 megjelölés, amely a sokkal lokálisabb szintű hozzáférést biztosítja. (Szemben a cellás rádió-hozzáférési hálózat rendszerével, ahol a forgalom elosztása egyszintű).

“Az első pont, ahol csatlakozunk a hálózathoz, az az, amit mi a helyi határnak tekintünk” – magyarázta Brown. A mai technológiára leképezve – folytatta – a mai szélső számítási lehetőségek egyikét bármelyik szerverben megtalálhatjuk, amelyet egy kábelezési szekrényben lévő rögtönzött állványba tuszkolnak.

“A mi céljainkra” – folytatta – “úgy gondoljuk, hogy ez az a hely, ahol az akció zajlik”.

“A széleken évekig az olyan Tier-1 szolgáltatói hotelek voltak, mint az Equinix és a CoreSite. Ezek alapvetően egy hálózatot egy másikhoz csatlakoztattak, és ezt tekintették edge-nek” – magyarázta Wen Temitim, a StackPath nevű edge-infrastruktúra-szolgáltató CTO-ja. “De amit most látunk, a fogyasztói viselkedésen alapuló különböző felhasználási változásokkal, valamint a COVID-19 és az otthoni munkavégzéssel, az egy új és mélyebb él, amely egyre relevánsabbá válik a szolgáltatók számára”.”

A perem elhelyezése a térképen

A peremszámítástechnika arra törekszik, hogy a szolgáltatásminőséget (QoS) visszahozza az adatközpont-architektúra és a szolgáltatások vitájába, mivel a vállalatok nemcsak arról döntenek, hogy ki, hanem arról is, hogy hol nyújtsák szolgáltatásaikat.

Az “üzemeltetési technológiai perem”

Az adatközpontok berendezéseit gyártó HPE – az edge computing egyik fő befektetője – úgy véli, hogy az üzemeltetési infrastruktúra következő óriási ugrását olyan munkatársak és vállalkozók fogják koordinálni és vezetni, akiknek nincs vagy nem sok személyes befektetése vagy képzettsége a hardver és az infrastruktúra terén – olyan emberek, akiknek eddig nagyrészt a karbantartás, a karbantartás és a szoftveres támogatás volt a feladata. Cége a személyzet ezen csoportjának feladatkörét operatív technológiának (OT) nevezi. Ellentétben azokkal, akik az IT és az üzemeltetés konvergálását a “DevOps” egyik vagy másik formájában látják, a HPE az edge computing ügyfeleinek három osztályát érzékeli. Véleménye szerint ezen osztályok mindegyike nemcsak saját edge computing platformot tart fenn, hanem e platformok földrajzi elhelyezkedése is elválik egymástól, nem pedig konvergál, ahogyan azt ez a HPE-ábrázolás mutatja.

Courtesy HPE Itt az ügyfelek három különböző osztálya látható, amelyek mindegyikét a HPE a saját szegmensére osztotta fel az edge-en belül. Az OT osztály itt azokra az ügyfelekre vonatkozik, akik nagyobb valószínűséggel bíznak meg olyan vezetőket az edge computinggal, akiknek kevesebb közvetlen tapasztalatuk van az informatikával kapcsolatban, főként azért, mert fő termékeik nem maguk az információ vagy a kommunikáció. Ezt az osztályt “OT edge”-nek osztották fel. Ha egy vállalkozásnak több közvetlen befektetése van az információban mint iparágban, vagy nagymértékben függ az információtól mint üzleti tevékenységének összetevőjétől, a HPE “IT edge”-et tulajdonít neki. A kettő között, a földrajzilag szétszórt és a logisztikától (ahol az információnak inkább logikai összetevője van) és így a dolgok internetétől függő vállalkozások számára a HPE “IoT edge”-et ad.

A Dell háromoldalú hálózata

Courtesy Dell Technologies A Dell Technologies 2017-ben ajánlotta először a háromszintű topológiáját a számítástechnikai piac egészének, felosztva azt “magra”, “felhőre” és “peremre”. Ahogy ez a dia is mutatja egy korai Dell prezentációból, ez a felosztás radikálisan egyszerűnek tűnt, legalábbis elsőre: Bármely ügyfél informatikai eszközeit fel lehetett osztani 1) a saját tulajdonában lévő és saját személyzetével karbantartott eszközökre; 2) a szolgáltatónak átadott és annak karbantartására felbérelt eszközökre; és 3) a saját telephelyén kívülre, a terepre telepített eszközökre, amelyeket az üzemeltetési szakemberek karbantartanak (akiket vagy kiszerveztek, vagy nem).

A Linux Foundation európai beágyazott Linux konferenciáján tartott 2018. novemberi előadásában Jason Shepherd, az IoT és Edge Computing technológiai igazgatója (CTO for IoT and Edge Computing) ezt az egyszerű esetet hozta fel: Mivel rengeteg hálózatba kapcsolt eszközt és készüléket terveznek az IoT-hez, technológiailag lehetetlen lesz központosítani a kezelésüket, még akkor is, ha a nyilvános felhőt vesszük igénybe.

“A feleségemnek és nekem három macskánk van” – mondta Shepherd a hallgatóságának. “Nagyobb tárolókapacitást szereztünk be a telefonjainkon, így oda-vissza tudunk macskás videókat küldeni.

Linux Foundation videó “A macskás videók magyarázzák az edge computing szükségességét” – folytatta. “Ha felteszem az egyik videómat az internetre, és elkezdenek megnézni, akkor több szerveren kell gyorsítótárba helyeznem, jóval hátrébb, a felhőben. Ha vírusként terjed, akkor ezt a tartalmat olyan közel kell vinnem az előfizetőkhöz, amennyire csak tudom. Távközlési szolgáltatóként, Netflixként vagy bármi másként a legközelebb a felhő szélén – a mobiltornyok alján, az internet ezen kulcsfontosságú pontjain – juthatok. Ez a MEC, a Multi-access Edge Computing koncepciója – a tartalom közelebb hozása az előfizetőkhöz. Nos, most, hogy több milliárd csatlakoztatott macskahívó van odakint, teljesen megfordult a paradigma, és ahelyett, hogy a dolgok lefelé próbálnának húzni, itt vannak ezek az eszközök, amelyek felfelé próbálnak nyomni. Ez azt eredményezi, hogy még lejjebb kell tolni a számítási kapacitást.”

A kialakulóban lévő “edge cloud”

A Shepherd ijedt cicája világpremierje óta a Dell edge koncepciója némileg megkeményedett, a rétegek árnyalt összeállításából inkább egy alapvető decentralizációs etika lett.

“Úgy látjuk, hogy az edge-t valóban nem feltétlenül egy adott hely vagy egy adott technológia határozza meg” – mondta tavaly februárban Matt Baker, a Dell munkatársa. “Ehelyett inkább az IT meglévő telepítésének bonyodalmát jelenti, mivel egyre inkább decentralizáljuk az IT-környezeteket, és azt tapasztaljuk, hogy egyre korlátozottabb környezetekbe helyezzük az IT-infrastruktúra megoldásait, szoftvereket stb. Az adatközpont nagyrészt korlátlan környezet; olyan specifikáció szerint építhetjük meg, amilyet szeretnénk, megfelelően hűthetjük, és rengeteg hely áll rendelkezésre. De ahogy egyre több technológiát helyezünk ki a minket körülvevő világba, hogy megkönnyítsük a valós idejű digitális élmények nyújtását, olyan helyeken találjuk magunkat, amelyek valamilyen módon kihívást jelentenek.”

A kampuszok hálózatai – mondta Baker – olyan berendezéseket tartalmaznak, amelyek általában porosak és piszkosak, amellett, hogy alacsony sávszélességű összeköttetéssel rendelkeznek. A távközlési környezetek gyakran tartalmaznak nagyon rövid mélységű rackeket, amelyek nagyon nagy sűrűségű processzorpopulációt igényelnek. A térkép legtávolabbi helységeiben pedig kevés a szakképzett informatikai munkaerő, “ami nagyobb nyomást gyakorol a nagymértékben elosztott környezetek kezelhetőségére egy kéz nélküli, személyzet nélküli környezetben”.

Mindazonáltal egyre több ügyfélnek kell az adatokat közelebb feldolgoznia ahhoz a ponthoz, ahol először értékelik vagy létrehozzák őket – érvelt. Ez a “perem” helyét 2020 körül a térkép bármely pontjára helyezi, ahol az adatok – jobb leírás híján – lángra kapnak.

A StackPath munkatársa, Temitim úgy véli, hogy ez a pont egy kialakulóban lévő koncepció, az úgynevezett edge cloud, amely gyakorlatilag több edge telepítés virtuális gyűjteménye egyetlen platformon belül. Ezt a platformot először a többcsatornás videóforgalmazók (MVPD-k, általában a hagyományos kábeltársaságok, de néhány távközlési vállalat is) számára értékesítenék, akik saját elosztóhálózatot szeretnének, és hosszú távon csökkentenék a költségeiket. További bevételi forrásként azonban ezek a szolgáltatók kereskedelmi ügyfelek nevében nyilvános felhő-szerű szolgáltatásokat, például SaaS-alkalmazásokat vagy akár virtuális szerver hostingot is kínálhatnának.

Egy ilyen “edge cloud” piac közvetlenül versenyezhetne a világ közepes méretű Tier-2 és Tier-3 adatközpontjaival. Mivel ezeknek a létesítményeknek az üzemeltetői jellemzően a régiójukban működő távközlési vállalatok prémium ügyfelei, ezek a távközlési vállalatok az “edge cloud”-ot a saját 5G vezeték nélküli terveikre vonatkozó versenyfenyegetésként érzékelhetik. Ez valóban, ahogy az egyik pereminfrastruktúra-szolgáltató fogalmazott, egy “fizikai földrablás”. És a birtokbavétel még csak most kezdődik.

Tudjon meg többet – A CBS Interactive Networkből

- How edge computing may revamp, revitalize commercial real estate by Larry Dignan, Between the Lines

- It’s a race to the edge, and the end of cloud computing as we know it by Scott M. Fulton, III, Scale

- Az edge computing legyen a legfontosabb befektetés 2020-ra a Forrester Research-től

Máshol

- The Data Center That’s a Coffee Table by Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com