- Riassunto esecutivo

- L’attuale topologia delle reti aziendali

- Potenziali benefici

- Potenziali insidie

- Cosa significa “edge computing”?

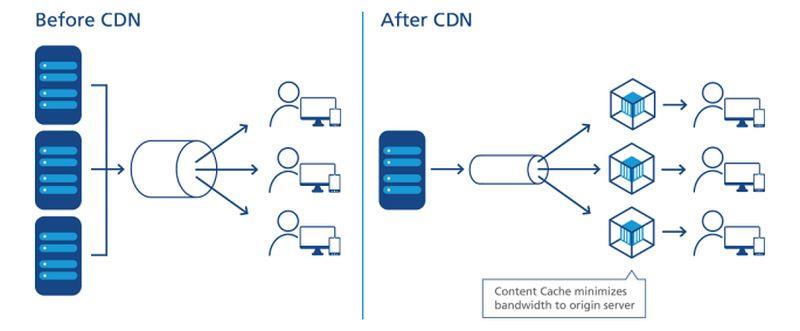

- Come le CDN hanno aperto la strada

- La tendenza verso la decentralizzazione

- Obiettivi di livello di servizio

- La rete a più livelli

- Individuare il bordo su una mappa

- Il “bordo tecnologico operativo”

- La rete tripartita di Dell

- L’emergente ‘edge cloud’

- Per saperne di più – Dalla rete CBS Interactive

- Altrove

Riassunto esecutivo

All’estremità di qualsiasi rete, ci sono opportunità per posizionare server, processori e array di archiviazione dati il più vicino possibile a coloro che possono farne miglior uso. Dove è possibile ridurre la distanza, essendo la velocità degli elettroni essenzialmente costante, si minimizza la latenza. Una rete progettata per essere usata ai margini sfrutta questa distanza minima per accelerare il servizio e generare valore.

In una moderna rete di comunicazione progettata per essere usata ai margini – per esempio, una rete wireless 5G – ci sono due possibili strategie al lavoro:

- Flussi di dati, audio e video possono essere ricevuti più velocemente e con meno pause (preferibilmente nessuna) quando i server sono separati dai loro utenti da un minimo di punti di routing intermedi, o “hop”. Le reti di consegna dei contenuti (CDN) di fornitori come Akamai, Cloudflare e NTT Communications sono costruite intorno a questa strategia.

- Le applicazioni possono essere accelerate quando i loro processori sono posizionati più vicino a dove vengono raccolti i dati. Questo è particolarmente vero per le applicazioni per la logistica e la produzione su larga scala, così come per l’Internet delle cose (IoT) dove i sensori o i dispositivi di raccolta dati sono numerosi e altamente distribuiti.

A seconda dell’applicazione, quando una o entrambe le strategie di bordo sono impiegate, questi server possono effettivamente finire su un’estremità della rete o sull’altra. Poiché Internet non è costruita come la vecchia rete telefonica, “più vicino” in termini di convenienza di routing non è necessariamente più vicino in termini di distanza geografica. E a seconda di quanti tipi diversi di fornitori di servizi la vostra organizzazione ha contrattato – fornitori di applicazioni cloud pubbliche (SaaS), fornitori di piattaforme di applicazioni (PaaS), fornitori di infrastrutture in leasing (IaaS), reti di distribuzione dei contenuti – ci possono essere più tratti di proprietà IT in lizza per essere “il bordo” in qualsiasi momento.

Inside-a-micro data center cabinet di Schneider Electric

Scott Fulton

L’attuale topologia delle reti aziendali

Ci sono tre luoghi in cui la maggior parte delle aziende tende a distribuire e gestire le proprie applicazioni e servizi:

- In sede, dove i data center ospitano più rack di server, dove sono dotati delle risorse necessarie per alimentarli e raffreddarli, e dove c’è una connettività dedicata alle risorse esterne

- Strutture di colocazione, dove le apparecchiature dei clienti sono ospitate in un edificio completamente gestito dove alimentazione, raffreddamento, e connettività sono forniti come servizi

- Fornitori di servizi cloud, dove l’infrastruttura del cliente può essere virtualizzata in una certa misura, e i servizi e le applicazioni sono forniti su una base per uso, consentendo alle operazioni di essere contabilizzate come spese operative piuttosto che spese in conto capitale

Gli architetti di edge computing vorrebbero aggiungere il loro progetto come una quarta categoria a questa lista: uno che sfrutta la portabilità di strutture più piccole e containerizzate con server più piccoli e modulari, per ridurre le distanze tra il punto di elaborazione e il punto di consumo di funzionalità nella rete. Se i loro piani andranno in porto, cercheranno di realizzare quanto segue:

Potenziali benefici

- Latenza minima. Il problema con i servizi di cloud computing oggi è che sono lenti, specialmente per i carichi di lavoro basati sull’intelligenza artificiale. Questo essenzialmente squalifica il cloud per un uso serio in applicazioni deterministiche, come le previsioni dei mercati mobiliari in tempo reale, il pilotaggio di veicoli autonomi e l’instradamento del traffico dei trasporti. I processori posizionati in piccoli data center più vicini a dove i loro processi saranno utilizzati, potrebbero aprire nuovi mercati per i servizi di calcolo che i fornitori di cloud non sono stati in grado di affrontare fino ad ora. In uno scenario IoT, dove i cluster di apparecchi stand-alone che raccolgono dati sono ampiamente distribuiti, avere processori più vicini anche a sottogruppi o cluster di questi apparecchi potrebbe migliorare notevolmente i tempi di elaborazione, rendendo l’analisi in tempo reale fattibile a un livello molto più granulare.

- Manutenzione semplificata. Per un’azienda che non ha molti problemi a spedire una flotta di camion o veicoli di manutenzione nelle sedi sul campo, i micro data center (µDC) sono progettati per la massima accessibilità, modularità e un ragionevole grado di portabilità. Sono involucri compatti, alcuni abbastanza piccoli da stare nel retro di un camioncino, che possono supportare abbastanza server per ospitare funzioni critiche per il tempo, che possono essere distribuiti più vicino ai loro utenti. Concepibilmente, per un edificio che attualmente ospita, alimenta e raffredda le sue risorse di data center nel suo seminterrato, sostituire l’intera operazione con tre o quattro µDC da qualche parte nel parcheggio potrebbe effettivamente essere un miglioramento.

- Raffreddamento più economico. Per i grandi complessi di data center, il costo mensile dell’elettricità usata per il raffreddamento può facilmente superare il costo dell’elettricità usata per l’elaborazione. Il rapporto tra i due è chiamato PUE (power usage effectiveness). A volte, questa è stata la misura di base dell’efficienza del data center (anche se negli ultimi anni, i sondaggi hanno mostrato che sempre meno operatori IT sanno cosa significa questo rapporto). Teoricamente, può costare meno a un’azienda raffreddare e condizionare diversi spazi di data center più piccoli che un unico grande spazio. Inoltre, a causa dei modi particolari in cui alcune aree di servizio elettrico gestiscono la fatturazione, il costo per kilowatt può scendere su tutta la linea per gli stessi rack di server ospitati in diverse piccole strutture piuttosto che in una grande. Un white paper del 2017 pubblicato da Schneider Electric ha valutato tutti i costi maggiori e minori associati alla costruzione di data center tradizionali e micro. Mentre un’impresa potrebbe incorrere in poco meno di 7 milioni di dollari di spese di capitale per costruire una struttura tradizionale da 1 MW, spenderebbe poco più di 4 milioni di dollari per facilitare 200 strutture da 5 KW.

- Coscienza climatica. C’è sempre stato un certo fascino ecologico all’idea di distribuire la potenza di calcolo ai clienti in un’area geografica più ampia, in contrapposizione alla centralizzazione di tale potenza in strutture mastodontiche, iperscalari, e facendo affidamento su collegamenti in fibra ottica ad alta larghezza di banda per la connettività. Il marketing iniziale per l’edge computing si basa sulle impressioni di buon senso degli ascoltatori che le strutture più piccole consumano meno energia, anche collettivamente. Ma la giuria non ha ancora capito se questo sia effettivamente vero. Uno studio del 2018 dei ricercatori dell’Università Tecnica di Kosice, in Slovacchia, utilizzando distribuzioni simulate di edge computing in uno scenario IoT, ha concluso che l’efficacia energetica dell’edge dipende quasi interamente dalla precisione e dall’efficienza dei calcoli ivi condotti. L’overhead sostenuto da calcoli inefficienti, hanno trovato, sarebbe in realtà amplificato da una cattiva programmazione.

Se tutto questo suona come un sistema troppo complesso per essere fattibile, tenete a mente che nella sua forma attuale, il modello di cloud computing pubblico potrebbe non essere sostenibile a lungo termine. Quel modello avrebbe abbonati che continuano a spingere applicazioni, flussi di dati e flussi di contenuti attraverso tubi collegati con complessi iperscale le cui aree di servizio comprendono interi stati, province e paesi – un sistema che i fornitori di voce wireless non avrebbero mai osato tentare.

Potenziali insidie

Nonostante, un mondo informatico interamente rifatto secondo il modello dell’edge computing è tanto fantastico – e remoto – quanto un mondo dei trasporti che si sia liberato interamente dai carburanti derivati dal petrolio. A breve termine, il modello di edge computing deve affrontare alcuni ostacoli significativi, molti dei quali non saranno del tutto facili da superare:

- Disponibilità remota di energia trifase. I server in grado di fornire servizi remoti di tipo cloud ai clienti commerciali, indipendentemente da dove si trovano, hanno bisogno di processori ad alta potenza e dati in-memory, per consentire la multi-tenancy. Probabilmente senza eccezione, richiederanno l’accesso all’elettricità ad alta tensione e trifase. Questo è estremamente difficile, se non impossibile, da ottenere in luoghi relativamente remoti e rurali. (Le stazioni base Telco non hanno mai richiesto questo livello di potenza fino ad ora, e se non sono mai state pensate per essere sfruttate per un uso commerciale multi-tenant, allora potrebbero non aver mai bisogno di energia trifase comunque. L’unica ragione per adattare il sistema di alimentazione sarebbe se l’edge computing è fattibile. Ma per applicazioni Internet-of-Things ampiamente distribuite, come le prove del Mississippi sui monitor cardiaci a distanza, la mancanza di un’infrastruttura di alimentazione sufficiente potrebbe finire per dividere ancora una volta gli “abbienti” dai “non abbienti”. Affinché la transizione al 5G sia conveniente, le telco devono ricavare ulteriori entrate dall’edge computing. Ciò che ha reso l’idea di legare l’evoluzione dell’edge computing al 5G è stata la nozione che le funzioni commerciali e operative potrebbero coesistere sugli stessi server – un concetto introdotto dal Central Office Re-architected as a Datacenter (CORD) (originariamente “Re-imagined”), una forma di cui è ora considerato un facilitatore chiave del 5G Wireless. Il problema è che potrebbe anche non essere legale che le operazioni fondamentali per la rete di telecomunicazioni coesistano con le funzioni del cliente sugli stessi sistemi – le risposte dipendono dal fatto che i legislatori siano in grado di comprendere la nuova definizione di “sistemi”. Fino a quel giorno (se mai arriverà), 3GPP (l’organizzazione industriale che governa gli standard 5G) ha adottato un concetto chiamato network slicing, che è un modo per ritagliare i server della rete telco in server virtuali ad un livello molto basso, con una separazione molto maggiore che in un tipico ambiente di virtualizzazione da, diciamo, VMware. Concepibilmente, una fetta di rete rivolta al cliente potrebbe essere distribuita sul bordo delle reti telco, servendo un numero limitato di clienti. Tuttavia, alcune grandi imprese preferirebbero farsi carico delle loro fette di rete, anche se questo significa distribuirle nelle loro strutture – spostando l’edge nei loro locali – piuttosto che investire in un nuovo sistema la cui proposta di valore è basata in gran parte sulla speranza.

- Le telco difendono i loro territori domestici dai breakout locali. Se la rete di accesso radio (RAN) 5G, e i cavi in fibra ottica ad essa collegati, devono essere sfruttati per i servizi commerciali ai clienti, deve esistere un qualche tipo di gateway per separare il traffico dei clienti privati da quello delle telco. L’architettura per un tale gateway esiste già, ed è stata formalmente adottata dal 3GPP. Si chiama breakout locale, ed è anche parte della dichiarazione ufficiale dell’ente normativo ETSI di multi-access edge computing (MEC). Quindi, tecnicamente, questo problema è stato risolto. Il problema è che alcune società di telecomunicazione possono avere interesse a prevenire la deviazione del traffico dei clienti dal percorso che prenderebbe normalmente: nei propri centri dati. La topologia della rete Internet di oggi ha tre livelli: I fornitori di servizi Tier-1 si scambiano solo tra loro, mentre gli ISP Tier-2 sono tipicamente rivolti ai clienti. Il terzo livello permette agli ISP più piccoli e regionali di avere un livello più locale. L’edge computing su scala globale potrebbe diventare il catalizzatore per servizi pubblici in stile cloud, offerti dagli ISP a livello locale, forse attraverso una sorta di “catena di negozi”. Ma questo supponendo che le telcos, che gestiscono il Tier-2, siano disposte a lasciare che il traffico di rete in entrata sia suddiviso in un terzo livello, consentendo la concorrenza in un mercato che potrebbero facilmente rivendicare per se stessi.

Se la posizione, la posizione, la posizione conta ancora per l’impresa, allora l’intero mercato dell’informatica aziendale può essere capovolto. La natura iperscalare, centralizzata e affamata di energia dei data center cloud potrebbe finire per lavorare contro di loro, mentre modelli operativi più piccoli, più agili e più convenienti spuntano – come denti di leone, se tutto va come previsto – in luoghi più ampiamente distribuiti.

“Credo che l’interesse per le implementazioni periferiche”, ha osservato Kurt Marko, principale della società di analisi tecnologica Marko Insights, in una nota a ZDNet, “è principalmente guidato dalla necessità di elaborare enormi quantità di dati generati da dispositivi ‘intelligenti’, sensori e utenti – in particolare utenti mobili/wireless. Infatti, le velocità di dati e il throughput delle reti 5G, insieme all’escalation dell’utilizzo dei dati dei clienti, richiederanno alle stazioni base mobili di diventare mini data center”.

Cosa significa “edge computing”?

In qualsiasi rete di telecomunicazioni, l’edge è il punto più lontano delle strutture e dei servizi verso i clienti. Nel contesto dell’edge computing, l’edge è la posizione sul pianeta dove i server possono fornire funzionalità ai clienti nel modo più rapido.

Come le CDN hanno aperto la strada

Diagramma della relazione tra data center e dispositivi Internet-of-Things, come raffigurato dall’Industrial Internet Consortium.

Per quanto riguarda Internet, il calcolo o l’elaborazione è condotto dai server – componenti solitamente rappresentati da una forma (per esempio, una nuvola) vicino al centro o punto focale di un diagramma di rete. I dati vengono raccolti dai dispositivi ai bordi di questo diagramma e tirati verso il centro per l’elaborazione. I dati elaborati, come il petrolio da una raffineria, vengono pompati di nuovo verso il bordo per la consegna. Le CDN accelerano questo processo agendo come “stazioni di rifornimento” per gli utenti nelle loro vicinanze. Il tipico ciclo di vita del prodotto per i servizi di rete coinvolge questo processo di “andata e ritorno”, dove i dati vengono effettivamente estratti, spediti, raffinati e spediti di nuovo. E, come in ogni processo che coinvolge la logistica, il trasporto richiede tempo.

Un posizionamento figurativo preciso dei server CDN nel processo di consegna dei dati.

NTT Communictions

Importante, se la CDN risiede sempre al centro del diagramma, dipende da chi sta guardando il diagramma. Se il fornitore di CDN l’ha disegnato, potrebbe esserci una grande nuvola “CDN” al centro, con le reti aziendali lungo i bordi di un lato, e i dispositivi degli utenti lungo gli altri bordi. Un’eccezione viene da NTT, il cui diagramma semplificato ma più accurato mostra i server CDN che si inseriscono tra il punto di accesso ai dati e gli utenti. Dal punto di vista dei produttori di dati o contenuti, al contrario degli agenti di consegna, le CDN risiedono verso la fine della catena di fornitura – il penultimo passo per i dati prima che l’utente li riceva.

Nell’ultimo decennio, i principali fornitori di CDN hanno iniziato a introdurre servizi informatici che risiedono nel punto di consegna. Immaginate che una stazione di servizio possa essere la propria raffineria, e avrete l’idea. La proposta di valore per questo servizio dipende dal fatto che le CDN non siano percepite al centro, ma al bordo. Permette ad alcuni dati di bypassare la necessità di trasporto, solo per essere elaborati e trasportati indietro.

La tendenza verso la decentralizzazione

Se le CDN non hanno ancora dimostrato l’efficacia dell’edge computing come servizio, hanno almeno dimostrato il valore di questo come business: Le imprese pagheranno dei premi per avere alcuni dati elaborati prima che raggiungano il centro, o “core”, della rete.

“Siamo stati in un periodo piuttosto lungo di centralizzazione”, ha spiegato Matt Baker, vice presidente senior di Dell Technologies per la strategia e la pianificazione, durante una conferenza stampa lo scorso febbraio. “E mentre il mondo cerca di offrire esperienze digitali sempre più in tempo reale attraverso le loro iniziative di trasformazione digitale, la capacità di mantenere quell’approccio altamente centralizzato all’IT sta iniziando a fratturarsi un po’”.

L’edge computing è stato propagandato come uno dei nuovi mercati redditizi resi possibili dalla tecnologia 5G Wireless. Affinché la transizione globale dal 4G al 5G sia economicamente fattibile per molte società di telecomunicazioni, la nuova generazione deve aprire nuovi canali di entrate sfruttabili. Il 5G richiede una vasta, nuova rete di connessioni (ironicamente) cablate in fibra ottica per fornire ai trasmettitori e alle stazioni base un accesso istantaneo ai dati digitali (il backhaul). Di conseguenza, si presenta un’opportunità per una nuova classe di fornitori di servizi informatici di distribuire più µDC adiacenti alle torri della rete di accesso radio (RAN), forse accanto a, o condividendo lo stesso edificio con, le stazioni base delle telecomunicazioni. Questi data center potrebbero offrire collettivamente servizi di cloud computing a clienti selezionati a tariffe competitive con, e caratteristiche paragonabili a, fornitori di cloud iperscale come Amazon, Microsoft Azure e Google Cloud Platform.

Idealmente, forse dopo un decennio o giù di lì di evoluzione, l’edge computing porterebbe i servizi veloci ai clienti vicino alle loro stazioni base wireless più vicine. Avremmo bisogno di enormi tubi in fibra ottica per fornire il backhaul necessario, ma le entrate dai servizi di edge computing potrebbero plausibilmente finanziare la loro costruzione, permettendo di pagarsi da soli.

Obiettivi di livello di servizio

In ultima analisi (se, in effetti, qualsiasi analisi è mai stata definitiva), il successo o il fallimento dei data center ai bordi della rete sarà determinato dalla loro capacità di soddisfare gli obiettivi di livello di servizio (SLO). Queste sono le aspettative dei clienti che pagano per i servizi, come codificate nei loro contratti di servizio. Gli ingegneri hanno delle metriche che usano per registrare e analizzare le prestazioni dei componenti di rete. I clienti tendono ad evitare queste metriche, scegliendo invece di favorire le prestazioni osservabili delle loro applicazioni. Se un’implementazione edge non è sensibilmente più veloce di un’implementazione hyperscale, allora l’edge come concetto può morire nella sua infanzia.

“Cosa ci interessa? È il tempo di risposta delle applicazioni”, ha spiegato Tom Gillis, vicepresidente senior di VMware per il networking e la sicurezza, durante una recente conferenza aziendale. “Se possiamo caratterizzare il modo in cui l’applicazione risponde, e guardare i singoli componenti che lavorano per fornire la risposta dell’applicazione, possiamo effettivamente iniziare a creare l’infrastruttura di auto-guarigione”.

La riduzione della latenza e il miglioramento della velocità di elaborazione (con server più recenti dedicati a molti meno compiti quantitativamente) dovrebbero giocare a vantaggio degli SLO. Alcuni hanno anche sottolineato come l’ampia distribuzione delle risorse su un territorio contribuisca alla ridondanza del servizio e persino alla continuità del business – che, almeno fino alla pandemia, erano percepiti come eventi di uno o due giorni, seguiti da periodi di recupero.

Ma ci saranno fattori di bilanciamento, il più importante dei quali ha a che fare con la manutenzione e il mantenimento. Una tipica struttura di data center Tier-2 può essere mantenuta, in circostanze di emergenza (come una pandemia) da appena due persone in loco, con personale di supporto fuori sede. Nel frattempo, un µDC è progettato per funzionare senza essere perpetuato dal personale. Le sue funzioni di monitoraggio integrate inviano continuamente la telemetria a un hub centrale, che teoricamente potrebbe essere nel cloud pubblico. Finché un µDC soddisfa i suoi SLO, non ha bisogno di essere seguito personalmente.

Ecco dove la fattibilità del modello di edge computing deve ancora essere testata a fondo. Con un tipico contratto di provider di data center, uno SLO è spesso misurato in base alla velocità con cui il personale del provider può risolvere un problema in sospeso. Di solito i tempi di risoluzione possono rimanere bassi quando il personale non deve raggiungere i punti critici con un camion. Se un modello di implementazione edge deve essere competitivo con un modello di implementazione colocation, le sue capacità di rimedio automatico devono essere incredibilmente buone.

La rete a più livelli

I fornitori di storage di dati, gli host di applicazioni cloud-native, i fornitori di servizi Internet of Things (IoT), i produttori di server, i real estate investment trust (REIT) e i produttori di contenitori di server preassemblati, stanno tutti aprendo strade espresse tra i loro clienti e quello che promette, per ognuno di loro, di essere il bordo.

Quello che tutti stanno davvero cercando è il vantaggio competitivo. L’idea di un vantaggio fa brillare nuove speranze sulle prospettive di un servizio premium – una ragione solida e giustificabile per cui certe classi di servizio comandano tariffe più alte di altre. Se avete letto o sentito altrove che l’edge potrebbe alla fine sussumere l’intero cloud, potete capire ora che questo in realtà non avrebbe molto senso. Se tutto fosse premium, niente sarebbe premium.

“L’edge computing sarà apparentemente la soluzione tecnologica perfetta, e i venture capitalist dicono che sarà un mercato tecnologico multimiliardario”, ha osservato Kevin Brown, CTO e vicepresidente senior per l’innovazione per il fornitore di attrezzature di servizio per data center e produttore di telai per micro data center, Schneider Electric. “Nessuno sa davvero cosa sia”.

Kevin Brown di Schneider Electric: “Nessuno sa effettivamente cosa sia.”

Brown ha riconosciuto che l’edge computing può attribuire la sua storia ai CDN pionieri, come Akamai. Eppure, ha continuato, “avete tutti questi diversi livelli – HPE ha la sua versione, Cisco ha la sua. . . Non potevamo dare un senso a tutto questo. La nostra visione dell’edge è davvero una visione molto semplificata. In futuro, ci saranno tre tipi di data center nel mondo, di cui ci si dovrà davvero preoccupare”.

Il quadro tracciato da Brown, durante un evento stampa presso la sede della società nel Massachusetts nel febbraio 2019, è una visione riemergente di un Internet a tre livelli, ed è condiviso da un numero crescente di aziende tecnologiche. Nel tradizionale modello a due livelli, i nodi Tier-1 sono limitati al peering con altri nodi Tier-1, mentre i nodi Tier-2 gestiscono la distribuzione dei dati a livello regionale. Fin dall’inizio di Internet, c’è stata una designazione per Tier-3 – per l’accesso ad un livello molto più locale. (Contrasta questo con lo schema del Radio Access Network cellulare, la cui distribuzione del traffico è a un solo livello).

“Il primo punto in cui ci si connette alla rete, è davvero quello che consideriamo il bordo locale”, ha spiegato Brown. Mappato sulla tecnologia di oggi, ha proseguito, si potrebbe trovare una delle strutture di edge computing di oggi in qualsiasi server infilato in un rack improvvisato in un armadio di cablaggio.

“Per i nostri scopi”, ha proseguito, “pensiamo che sia dove si trova l’azione”.

“Il bordo, per anni, è stato il Tier-1 hotel carrier come Equinix e CoreSite. Fondamentalmente stratificavano una rete che si collegava a un’altra, e questo era considerato un bordo”, ha spiegato Wen Temitim, CTO del fornitore di servizi di infrastruttura di bordo StackPath. “Ma quello che stiamo vedendo, con tutti i diversi cambiamenti nell’uso basato sul comportamento dei consumatori, e con COVID-19 e il lavoro da casa, è un nuovo e più profondo bordo che sta diventando più rilevante con i fornitori di servizi”.

Individuare il bordo su una mappa

L’edge computing è uno sforzo per riportare la qualità del servizio (QoS) nella discussione dell’architettura e dei servizi del data center, poiché le imprese decidono non solo chi fornirà i loro servizi, ma anche dove.

Il “bordo tecnologico operativo”

Il produttore di attrezzature per data center HPE – uno dei principali investitori nell’edge computing – ritiene che il prossimo gigantesco salto nelle infrastrutture operative sarà coordinato e guidato da personale e appaltatori che potrebbero non avere molti, se non nessuno, investimenti personali o formazione in hardware e infrastrutture – persone che, fino ad ora, sono state in gran parte incaricate della manutenzione, del mantenimento e del supporto software. La sua azienda chiama l’ambito di questa classe di personale tecnologia operativa (OT). A differenza di coloro che percepiscono l’IT e le operazioni che convergono in una forma o nell’altra di “DevOps”, HPE percepisce tre classi di clienti di edge computing. Non solo ciascuna di queste classi, a suo parere, manterrà la propria piattaforma di edge computing, ma la geografia di queste piattaforme si separerà l’una dall’altra, non convergerà, come raffigura questo diagramma di HPE.

Qui, ci sono tre classi distinte di clienti, ciascuna delle quali HPE ha ripartito il proprio segmento dell’edge in generale. La classe OT qui si riferisce ai clienti più propensi ad assegnare manager all’edge computing che hanno meno esperienza diretta con l’IT, principalmente perché i loro prodotti principali non sono informazioni o comunicazioni stesse. Questa classe è assegnata un “bordo OT”. Quando un’impresa ha più di un investimento diretto nelle informazioni come settore, o è in gran parte dipendente dalle informazioni come componente del suo business, HPE le attribuisce un “bordo IT”. Nel mezzo, per quelle imprese che sono geograficamente disperse e dipendenti dalla logistica (dove l’informazione ha una componente più logica) e quindi l’Internet delle cose, HPE gli attribuisce un “bordo IoT”.

La rete tripartita di Dell

Nel 2017, Dell Technologies ha offerto per la prima volta la sua topologia a tre livelli per il mercato informatico in generale, dividendolo in “core”, “cloud” e “edge”. Come indica questa diapositiva di una prima presentazione Dell, questa divisione sembrava radicalmente semplice, almeno all’inizio: Le risorse IT di qualsiasi cliente potrebbero essere divise, rispettivamente, in 1) ciò che possiede e mantiene con il proprio personale; 2) ciò che delega a un fornitore di servizi e lo assume per la manutenzione; e 3) ciò che distribuisce oltre le sue strutture domestiche sul campo, per essere mantenuto da professionisti delle operazioni (che possono o non possono essere esternalizzati).

In una presentazione del novembre 2018 per la Embedded Linux Conference Europe della Linux Foundation, il CTO per IoT e Edge Computing Jason Shepherd ha fatto questo semplice caso: Poiché molti dispositivi e apparecchi in rete sono in programma per l’IoT, sarà tecnologicamente impossibile centralizzare la loro gestione, anche se si arruola il cloud pubblico.

“Io e mia moglie abbiamo tre gatti”, ha detto Shepherd al suo pubblico. “Abbiamo ottenuto maggiori capacità di archiviazione sui nostri telefoni, in modo da poter inviare i video dei gatti avanti e indietro”.

“I video dei gatti spiegano la necessità dell’edge computing,” ha continuato. “Se pubblico uno dei miei video online, e comincia a ricevere visite, devo metterlo in cache su più server, molto indietro nel cloud. Se diventa virale, allora devo spostare quel contenuto il più vicino possibile agli abbonati. Come telco, o come Netflix o qualsiasi altra cosa, il più vicino che posso ottenere è al bordo della nuvola – alla base delle mie torri cellulari, questi punti chiave su Internet. Questo è il concetto di MEC, Multi-access Edge Computing – portare il contenuto più vicino agli abbonati. Bene, ora, se ho miliardi di chiamanti gatto connessi là fuori, ho completamente capovolto il paradigma, e invece di cose che cercano di tirare giù, ho tutti questi dispositivi che cercano di spingere su. Questo ti costringe a spingere il calcolo ancora più in basso”.

L’emergente ‘edge cloud’

Dalla prima mondiale del gattino spaventato di Shepherd, il concetto di edge di Dell si è un po’ indurito, da un assemblaggio sfumato di strati a più di un’etica di decentralizzazione di base.

“Vediamo il bordo come realmente definito non necessariamente da un luogo specifico o da una tecnologia specifica”, ha detto Matt Baker della Dell lo scorso febbraio. “Invece, è una complicazione per l’attuale distribuzione dell’IT in quanto, poiché stiamo sempre più decentralizzando i nostri ambienti IT, stiamo scoprendo che stiamo mettendo soluzioni di infrastruttura IT, software, ecc, in ambienti sempre più limitati. Un data center è un ambiente in gran parte non vincolato; lo costruisci secondo le specifiche che vuoi, puoi raffreddarlo adeguatamente, c’è molto spazio. Ma man mano che mettiamo sempre più tecnologia nel mondo che ci circonda, per facilitare la consegna di queste esperienze digitali in tempo reale, ci troviamo in luoghi che sono sfidati in qualche modo”.

Le reti dei campus, ha detto Baker, includono attrezzature che tendono ad essere polverose e sporche, oltre ad avere una connettività a bassa larghezza di banda. Gli ambienti Telco spesso includono rack di profondità molto ridotta che richiedono una popolazione di processori ad alta densità. E nei luoghi più lontani sulla mappa, c’è una scarsità di manodopera IT qualificata, “che mette maggiore pressione sulla capacità di gestire ambienti altamente distribuiti in un hands-off, senza personale.”

Ciononostante, è incombente su un numero crescente di clienti di elaborare i dati più vicino al punto in cui vengono valutati o creati, ha sostenuto. Questo pone la posizione del “bordo”, circa 2020, in qualsiasi punto della mappa in cui si trovano i dati, per mancanza di una descrizione migliore, che prendono fuoco.

StackPath’s Temitim crede che quel punto sia un concetto emergente chiamato la nuvola di bordo – effettivamente una raccolta virtuale di più distribuzioni di bordo in una singola piattaforma. Questa piattaforma verrebbe commercializzata in un primo momento ai distributori di video multicanale (MVPDs, di solito le aziende via cavo storiche ma anche alcune telcos) che cercano di possedere le proprie reti di distribuzione, e tagliare i costi nel lungo termine. Ma come fonte di reddito aggiuntivo, questi fornitori potrebbero poi offrire servizi simili al public-cloud, come applicazioni SaaS o anche hosting di server virtuali, per conto di clienti commerciali.

Un tale mercato “edge cloud” potrebbe competere direttamente contro i data center Tier-2 e Tier-3 di medie dimensioni del mondo. Poiché gli operatori di queste strutture sono tipicamente clienti premium delle telcos delle loro rispettive regioni, queste telcos potrebbero percepire la nuvola di bordo come una minaccia competitiva ai loro piani per il 5G Wireless. Si tratta veramente, come ha detto un fornitore di infrastrutture edge, di una “presa di terra fisica”. E l’accaparramento è appena iniziato.

Per saperne di più – Dalla rete CBS Interactive

- Come l’edge computing può rinnovare e rivitalizzare l’immobiliare commerciale di Larry Dignan, Between the Lines

- È una corsa all’edge, e la fine del cloud computing come lo conosciamo di Scott M. Fulton, III, Scale

- Fare dell’edge computing un investimento chiave per il 2020 di Forrester Research

Altrove

- Il Data Center che è un tavolino da caffè di Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com