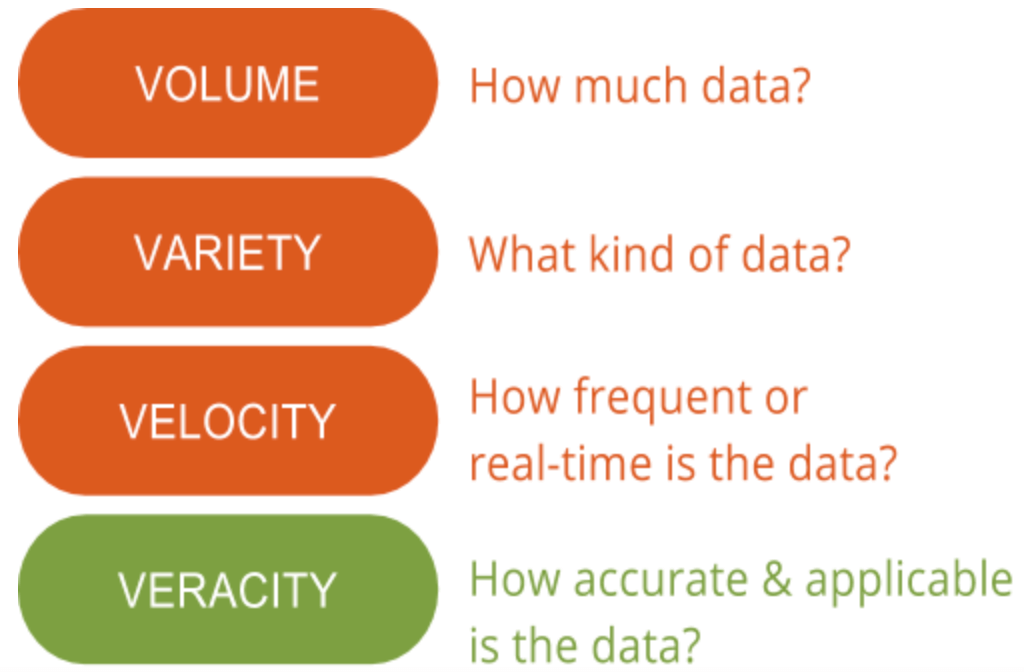

Qui a GutCheck, parliamo molto delle 4 V dei Big Data: volume, varietà, velocità e veracità. C’è una “V” di cui sottolineiamo l’importanza rispetto a tutte le altre: la veridicità. La veridicità dei dati è l’area che ha ancora un potenziale di miglioramento e pone la sfida più grande quando si tratta di big data. Con così tanti dati disponibili, assicurarsi che siano rilevanti e di alta qualità è la differenza tra chi usa con successo i big data e chi fa fatica a capirli.

Comprendere l’importanza della veridicità dei dati è il primo passo per discernere il segnale dal rumore quando si tratta di big data. In altre parole, la veridicità aiuta a filtrare ciò che è importante e ciò che non lo è, e alla fine genera una comprensione più profonda dei dati e di come contestualizzarli per poter agire.

Comprendere l’importanza della veridicità dei dati è il primo passo per discernere il segnale dal rumore quando si tratta di big data. In altre parole, la veridicità aiuta a filtrare ciò che è importante e ciò che non lo è, e alla fine genera una comprensione più profonda dei dati e di come contestualizzarli per poter agire.

Che cos’è la veridicità dei dati?

La veridicità dei dati, in generale, è quanto accurata o veritiera possa essere una serie di dati. Nel contesto dei big data, tuttavia, assume un significato un po’ più ampio. Più specificamente, quando si tratta della precisione dei big data, non si tratta solo della qualità dei dati stessi, ma di quanto siano affidabili la fonte dei dati, il tipo e l’elaborazione degli stessi. Rimuovere cose come distorsioni, anomalie o incongruenze, duplicazioni e volatilità sono solo alcuni aspetti che contribuiscono a migliorare l’accuratezza dei big data.

Purtroppo, a volte la volatilità non è sotto il nostro controllo. La volatilità, a volte indicata come un’altra “V” dei big data, è il tasso di cambiamento e la durata di vita dei dati. Un esempio di dati altamente volatili include i social media, dove i sentimenti e gli argomenti di tendenza cambiano rapidamente e spesso. I dati meno volatili assomigliano di più alle tendenze meteorologiche che cambiano meno frequentemente e sono più facili da prevedere e tracciare.

Il secondo lato della veridicità dei dati comporta la garanzia che il metodo di elaborazione dei dati effettivi abbia senso in base alle esigenze aziendali e che l’output sia pertinente agli obiettivi. Ovviamente, questo è particolarmente importante quando si incorporano le ricerche di mercato primarie con i big data. Interpretare i big data nel modo giusto assicura che i risultati siano rilevanti e perseguibili. Inoltre, l’accesso ai big data significa che si potrebbero passare mesi a selezionare le informazioni senza concentrarsi e senza un metodo per identificare quali punti di dati sono rilevanti. Di conseguenza, i dati dovrebbero essere analizzati in modo tempestivo, come è difficile con i big data, altrimenti le intuizioni non sarebbero utili.

Perché è importante

I big data sono molto complessi e, di conseguenza, i mezzi per comprenderli e interpretarli sono ancora in fase di concettualizzazione. Mentre molti pensano che il machine learning avrà un grande uso per l’analisi dei big data, i metodi statistici sono ancora necessari per garantire la qualità dei dati e l’applicazione pratica dei big data per i ricercatori di mercato. Per esempio, non scarichereste un rapporto di settore da internet e lo usereste per agire. Invece, probabilmente lo convalidereste o lo usereste per informare ulteriori ricerche prima di formulare le vostre conclusioni. I grandi dati non sono diversi; non potete prendere i grandi dati così come sono senza convalidarli o spiegarli. Ma a differenza della maggior parte delle pratiche di ricerca di mercato, i big data non hanno una solida base con le statistiche.

Ecco perché abbiamo passato del tempo a capire le piattaforme di gestione dei dati e i big data per continuare a sperimentare metodi che integrano, aggregano e interpretano i dati con una precisione da ricerca come i metodi collaudati a cui siamo abituati. Parte di questi metodi include l’indicizzazione e la pulizia dei dati, oltre all’utilizzo di dati primari per aiutare a dare più contesto e mantenere la veridicità degli approfondimenti.

Molte organizzazioni non possono dedicare tutto il tempo necessario per discernere veramente se una fonte di big data e un metodo di elaborazione sostengano un alto livello di veridicità. Lavorare con un partner che ha una buona conoscenza delle basi dei big data nelle ricerche di mercato può aiutare. Per sapere come un nostro cliente ha sfruttato intuizioni basate su sondaggi e dati comportamentali (big), date un’occhiata al caso di studio qui sotto. Vedrete anche come sono stati in grado di unire i puntini e sbloccare il potere dell’audience intelligence per guidare una migliore strategia di segmentazione dei consumatori.