- Sammanfattning

- Den nuvarande topologin för företagsnätverk

- Potentiella fördelar

- Potentiella fallgropar

- Vad betyder ”edge computing”?

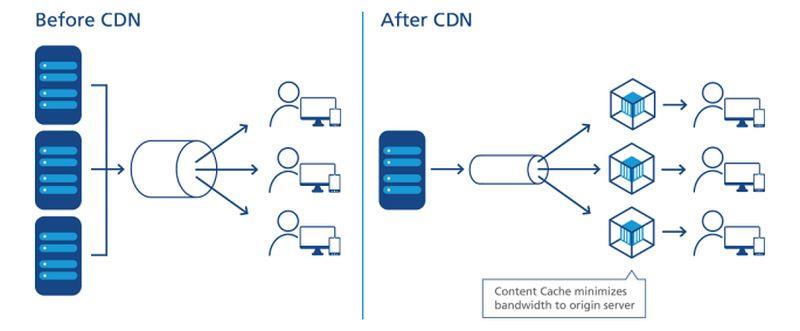

- Hur CDN:s banade väg

- Trenden mot decentralisering

- Mål för servicenivåer

- Det nivåindelade nätverket

- Lokalisering av kanten på en karta

- Den ”operativa tekniska kanten”

- Dells tredelade nätverk

- Det framväxande ”kantmolnet”

- Läs mer – från CBS Interactive Network

- Annat

Sammanfattning

I utkanten av ett nätverk finns det möjligheter att placera servrar, processorer och datalagringsenheter så nära dem som kan utnyttja dem på bästa sätt som möjligt. När man kan minska avståndet, eftersom elektronernas hastighet i stort sett är konstant, minimerar man latensen. Ett nätverk som är utformat för att användas i utkanten utnyttjar detta minimala avstånd för att påskynda servicen och generera värde.

I ett modernt kommunikationsnät som är utformat för användning i utkanten – till exempel ett trådlöst 5G-nät – finns det två möjliga strategier:

- Data-, ljud- och videoströmmar kan tas emot snabbare och med färre pauser (helst inga alls) när servrarna är separerade från användarna med ett minimum av mellanliggande routningspunkter, eller ”hopp”. Content Delivery Networks (CDN) från leverantörer som Akamai, Cloudflare och NTT Communications bygger på denna strategi.

- Applikationer kan påskyndas när deras processorer är placerade närmare den plats där uppgifterna samlas in. Detta gäller särskilt för tillämpningar för logistik och storskalig tillverkning samt för sakernas internet (IoT) där sensorer eller datainsamlingsenheter är många och mycket distribuerade.

- På plats, där datacenter rymmer flera rack med servrar, där de är utrustade med de resurser som behövs för att driva och kyla dem och där det finns dedikerade anslutningar till externa resurser

- Colocation-anläggningar, där kundernas utrustning finns i en fullt hanterad byggnad där kraft, kyla och värme finns tillgängliga, och uppkoppling tillhandahålls som tjänster

- Leverantörer av molntjänster, där kundernas infrastruktur kan virtualiseras i viss utsträckning och där tjänster och tillämpningar tillhandahålls per användning, vilket gör det möjligt att redovisa verksamheten som driftskostnader snarare än som kapitalutgifter

- Minimal latens. Problemet med molntjänster idag är att de är långsamma, särskilt för arbetsbelastningar med artificiell intelligens. Detta diskvalificerar i princip molnet för seriös användning i deterministiska tillämpningar, t.ex. prognoser för värdepappersmarknader i realtid, pilotering av autonoma fordon och dirigering av transporttrafiken. Processorer som placeras i små datacenter närmare den plats där deras processer kommer att användas skulle kunna öppna upp nya marknader för datatjänster som molnleverantörer hittills inte har kunnat ta sig an. I ett IoT-scenario, där kluster av fristående, datainsamlande apparater är vitt utspridda, skulle processorer närmare till och med undergrupper eller kluster av dessa apparater kunna förbättra bearbetningstiden avsevärt, vilket gör analyser i realtid möjliga på en mycket mer granulär nivå.

- Förenklat underhåll. För ett företag som inte har några större problem med att skicka en flotta av lastbilar eller underhållsfordon till fältplatser är mikrodatacenter (µDC) utformade för maximal tillgänglighet, modularitet och en rimlig grad av portabilitet. Det är kompakta höljen, varav vissa är tillräckligt små för att rymmas i baksätet på en pickup, som kan stödja precis tillräckligt många servrar för att hysa tidskritiska funktioner och som kan placeras närmare användarna. För en byggnad som för närvarande inhyser, driver och kyler sina datacentertillgångar i källaren kan det faktiskt vara en förbättring att ersätta hela verksamheten med tre eller fyra µDC:er någonstans på parkeringsplatsen.

- Billigare kylning. För stora datacenterkomplex kan månadskostnaden för el som används för kylning lätt överstiga kostnaden för el som används för bearbetning. Förhållandet mellan de två kallas för Power Usage Effectiveness (PUE). Ibland har detta varit det grundläggande måttet på datacentrets effektivitet (även om undersökningar på senare år har visat att färre IT-operatörer vet vad detta förhållande faktiskt betyder). Teoretiskt sett kan det kosta ett företag mindre att kyla och konditionera flera mindre datacenterutrymmen än att kyla och konditionera ett stort. Dessutom kan kostnaden per kilowatt sjunka över hela linjen för samma serverhyllor i flera små anläggningar i stället för i en stor, på grund av de märkliga sätt på vilka vissa elområden hanterar fakturering. I ett vitbok från 2017 som publicerades av Schneider Electric utvärderades alla större och mindre kostnader som är förknippade med att bygga traditionella och mikrodatacenter. Medan ett företag kan ådra sig knappt 7 miljoner dollar i kapitalkostnader för att bygga en traditionell anläggning på 1 MW, skulle det spendera drygt 4 miljoner dollar för att underlätta för 200 anläggningar på 5 KW.

- Klimatmedvetande. Det har alltid funnits en viss ekologisk dragningskraft i idén om att distribuera datorkraft till kunder över ett större geografiskt område, i motsats till att centralisera denna kraft i enorma, hyperskaliga anläggningar och förlita sig på fiberoptiska länkar med hög bandbredd för anslutning. Den tidiga marknadsföringen av edge computing bygger på lyssnarnas sunda förnuft att mindre anläggningar förbrukar mindre energi, även kollektivt. Men juryn är fortfarande inte säker på om det verkligen är sant. I en studie från 2018 av forskare från Technical University of Kosice, Slovakien , som använde simulerade edge computing-installationer i ett IoT-scenario, drogs slutsatsen att energieffektiviteten hos edge nästan helt och hållet beror på noggrannheten och effektiviteten hos de beräkningar som utförs där. De överkostnader som uppstår till följd av ineffektiva beräkningar, konstaterade de, skulle faktiskt förstoras av dålig programmering.

- Avlägsen tillgång till trefasström. Servrar som kan tillhandahålla molnliknande fjärrtjänster till kommersiella kunder, oavsett var de befinner sig, behöver kraftfulla processorer och minnesdata för att möjliggöra flera tjänster. De kommer förmodligen utan undantag att kräva tillgång till högspänd, trefasig el. Det är extremt svårt, om inte omöjligt, att få tillgång till detta på relativt avlägsna platser på landsbygden. (Vanlig 120 V växelström är enfasig.) Basstationer för telekombolag har hittills aldrig krävt denna effektnivå, och om de aldrig är avsedda att användas för kommersiell användning med flera hyresgäster, kommer de kanske aldrig att behöva trefasig el ändå. Den enda anledningen till att eftermontera kraftsystemet skulle vara om edge computing är genomförbart. Men när det gäller tillämpningar för Internet-of-Things som Mississippis försök med fjärrstyrda hjärtmonitorer kan bristen på tillräcklig kraftinfrastruktur återigen leda till att ”de som har” skiljs från ”de som inte har”.

- Att dela in servrar i skyddade virtuella skivor. För att övergången till 5G ska vara överkomlig måste telekombolagen skörda ytterligare intäkter från edge computing. Det som gjorde att idén om att knyta utvecklingen av edge computing till 5G var tanken att kommersiella och operativa funktioner kunde samexistera på samma servrar – ett koncept som introducerades av Central Office Re-architected as a Datacenter (CORD) (ursprungligen ”Re-imagined”), en form av detta som nu anses vara en viktig underlättare för 5G Wireless. Problemet är att det kanske inte ens är lagligt att verksamhet som är grundläggande för telenätet ska samsas med kundfunktioner på samma system – svaren beror på om lagstiftarna är kapabla att förstå den nya definitionen av ”system”. I väntan på den dagen (om den någonsin kommer) har 3GPP (den branschorganisation som styr 5G-standarderna) antagit ett koncept som kallas network slicing, vilket är ett sätt att dela upp telekomnätverksservrar i virtuella servrar på en mycket låg nivå, med mycket större åtskillnad än i en typisk virtualiseringsmiljö från, till exempel, VMware. Man skulle kunna tänka sig att en kundorienterad nätdel skulle kunna installeras i telekommunikationsnätens utkant och betjäna ett begränsat antal kunder. Vissa större företag vill dock hellre ta ansvar för sina egna nätverksdelar, även om det innebär att de måste installeras i sina egna anläggningar – och flytta utkanten till sina egna lokaler – än att investera i ett nytt system vars värdeförslag till stor del bygger på förhoppningar.

- Telekombolag som försvarar sina hemmamarknader från lokala utbrytningar. Om 5G:s radioaccessnät (RAN) och de fiberoptiska kablar som är kopplade till det ska utnyttjas för kommersiella kundtjänster måste någon typ av gateway finnas på plats för att avskilja privatkundstrafik från telekomtrafik. Arkitekturen för en sådan gateway finns redan och har formellt antagits av 3GPP. Den kallas local breakout och ingår också i ETSI:s standardiseringsorgan ETSI:s officiella deklaration av multiaccess edge computing (MEC). Tekniskt sett har detta problem alltså lösts. Problemet är att vissa telebolag kan ha ett intresse av att förhindra att kundtrafiken leds bort från den väg den normalt skulle ha tagit: in i deras egna datacenter. Dagens Internetnät har tre nivåer: Tjänsteleverantörer i nivå 1 har endast kontakt med varandra, medan Internetleverantörer i nivå 2 vanligtvis har kontakt med kunderna. Den tredje nivån ger utrymme för mindre, regionala Internetleverantörer på en mer lokal nivå. Edge computing på global nivå kan bli en katalysator för offentliga molnliknande tjänster som erbjuds av Internetleverantörer på lokal nivå, kanske genom ett slags ”kedjelager”. Men det förutsätter att telekombolagen, som förvaltar Tier-2, är villiga att låta inkommande nätverkstrafik delas upp i en tredje nivå, vilket möjliggör konkurrens på en marknad som de mycket lätt skulle kunna ta för sig.

- How edge computing may revamp, revitalize commercial real estate by Larry Dignan, Between the Lines

- It’s a race to the edge, and the end of cloud computing as we know it by Scott M. Fulton, III, Scale

- Gör edge computing till en nyckelinvestering för 2020 av Forrester Research

- The Data Center That’s a Coffee Table av Scott M. Fulton, III, Data Center Knowledge

- Dell Joins AT&T to Move Edge Data Centers Wherever They Should Be by Scott M. Fulton, III, Data Center Knowledge

- Challenges and Solutions in Edge Computing: The Future by Pam Baker, Linux.com

Avhängigt av tillämpningen kan dessa servrar faktiskt hamna i den ena eller andra änden av nätverket när en av eller båda kantstrategierna används. Eftersom Internet inte är uppbyggt som det gamla telefonnätet är ”närmare” när det gäller routningseffektivitet inte nödvändigtvis närmare i geografiskt avstånd. Och beroende på hur många olika typer av tjänsteleverantörer din organisation har ingått avtal med – leverantörer av offentliga molntillämpningar (SaaS), leverantörer av app-plattformar (PaaS), leverantörer av hyrd infrastruktur (IaaS), innehållsleverantörsnätverk – kan det finnas flera olika områden av IT-fastigheter som tävlar om att vara ”kanten” vid en och samma tidpunkt.

Insida av ett skåp i Schneider Electrics mikrodatacenter

Scott Fulton

Det finns tre platser där de flesta företag tenderar att distribuera och hantera sina egna applikationer och tjänster:

Arkitekterna av edge computing skulle vilja lägga till sin design som en fjärde kategori i denna lista: En som utnyttjar portabiliteten hos mindre, containeriserade anläggningar med mindre, mer modulära servrar, för att minska avstånden mellan bearbetningspunkten och konsumtionspunkten för funktionalitet i nätverket. Om deras planer går i uppfyllelse försöker de åstadkomma följande:

Potentiella fördelar

Om allt detta låter som ett alltför komplext system för att vara genomförbart, tänk då på att i sin nuvarande form är det inte säkert att den offentliga molnberäkningsmodellen är hållbar på lång sikt. Den modellen skulle innebära att abonnenterna måste fortsätta att driva tillämpningar, dataströmmar och innehållsströmmar genom rör som är kopplade till hyperskaliga komplex vars serviceområden omfattar hela stater, provinser och länder – ett system som trådlösa röstleverantörer aldrig skulle ha vågat försöka sig på.

Potentiella fallgropar

En datorvärld som är helt omgjord enligt Edge Computing-modellen är dock ungefär lika fantastisk – och lika avlägsen – som en transportvärld som helt och hållet har avvänt sig från petroleumbränslen. På kort sikt står edge computing-modellen inför några betydande hinder, varav flera inte kommer att vara helt lätta att övervinna:

Om plats, plats, plats återigen spelar roll för företagen kan hela marknaden för företagsdatorer vändas upp och ner. Molndatacentrarnas hyperskaliga, centraliserade och kraftkrävande karaktär kan komma att motverka dem när mindre, smidigare och mer kostnadseffektiva driftsmodeller växer upp – som maskrosor, om allt går som planerat – på mer allmänt spridda platser.

”Jag tror att intresset för edge-installationer”, påpekade Kurt Marko, chef för teknikanalysföretaget Marko Insights, i en kommentar till ZDNet, ”i första hand drivs av behovet av att bearbeta enorma mängder data som genereras av ’smarta’ enheter, sensorer och användare – särskilt mobila/trådlösa användare. 5G-nätens datahastigheter och genomströmning, tillsammans med kundernas eskalerande dataanvändning, kommer att kräva att mobila basstationer blir mini-datacenter.”

Vad betyder ”edge computing”?

I alla telekommunikationsnät är kanten den yttersta räckvidden för dess anläggningar och tjänster mot kunderna. När det gäller edge computing är kanten den plats på planeten där servrarna kan leverera funktionalitet till kunderna på det mest ändamålsenliga sättet.

Hur CDN:s banade väg

Diagram över förhållandet mellan datacenter och Internet-of-Things-enheter, som det skildras av Industrial Internet Consortium.

Med avseende på Internet utförs beräkning eller bearbetning av servrar – komponenter som vanligtvis representeras av en form (till exempel ett moln) nära centrum eller brännpunkt i ett nätverksdiagram. Data samlas in från enheter i kanterna av detta diagram och dras till centrum för bearbetning. Behandlade data, som olja från ett raffinaderi, pumpas tillbaka ut mot kanten för leverans. CDN:er påskyndar denna process genom att fungera som ”tankstationer” för användare i deras närhet. Den typiska produktlivscykeln för nättjänster omfattar denna ”tur-och-retur-process”, där data i praktiken utvinns, transporteras, raffineras och transporteras igen. Som i alla logistiska processer tar transporten tid.

En exakt figurativ placering av CDN-servrar i dataleveransprocessen.

NTT Communictions

Det beror på vems diagram du tittar på om CDN:n alltid befinner sig i mitten av diagrammet. Om CDN-leverantören har gjort det kan det finnas ett stort ”CDN”-moln i mitten, med företagsnätverk längs kanterna på den ena sidan och enheter för användarutrustning längs de andra kanterna. Ett undantag kommer från NTT, vars förenklade men mer korrekta diagram ovan visar CDN-servrar som placerar sig mellan dataåtkomstpunkten och användarna. Ur dataproducenternas eller innehållsproducenternas perspektiv, i motsats till leveransagenterna, befinner sig CDN-servrarna i slutet av leveranskedjan – det näst sista steget för data innan användaren tar emot dem.

Under det senaste decenniet började de stora CDN-leverantörerna introducera datatjänster som finns på leveransplatsen. Tänk om en bensinstation kunde vara sitt eget raffinaderi, så förstår du vad jag menar. Värdeerbjudandet för denna tjänst är beroende av att CDN inte uppfattas som ett centrum, utan som en utkant. Det gör det möjligt för vissa data att kringgå behovet av transport, bara för att bearbetas och transporteras tillbaka.

Trenden mot decentralisering

Om CDN:erna ännu inte hade bevisat effektiviteten hos edge computing som tjänst, visade de åtminstone värdet av det som affärsverksamhet: Företag kommer att betala premier för att få vissa data behandlade innan de når nätets centrum, eller ”kärna”.

”Vi har haft en ganska lång period av centralisering”, förklarade Matt Baker, Dell Technologies senior vice president för strategi och planering, under en presskonferens i februari förra året. ”Och i takt med att världen ser ut att leverera digitala upplevelser i allt större utsträckning i realtid genom sina initiativ för digital omvandling, börjar förmågan att hålla fast vid denna mycket centraliserade strategi för IT att brista ganska mycket.”

Edge computing har lyfts fram som en av de lukrativa, nya marknader som blir möjliga genom den trådlösa 5G-tekniken. För att den globala övergången från 4G till 5G ska vara ekonomiskt genomförbar för många telekommunikationsföretag måste den nya generationen öppna upp nya, exploaterbara intäktskanaler. 5G kräver ett enormt nytt nätverk av (ironiskt nog) trådbundna, fiberoptiska anslutningar för att förse sändare och basstationer med omedelbar tillgång till digitala data (backhaul). Detta innebär att det uppstår en möjlighet för en ny klass av leverantörer av datatjänster att installera flera µDC:er i anslutning till torn för radioaccessnät (RAN), kanske bredvid eller i samma byggnad som basstationer för telekombolag. Dessa datacenter skulle tillsammans kunna erbjuda molntjänster till utvalda kunder till priser som är konkurrenskraftiga och med funktioner som är jämförbara med hyperskaliga molnleverantörer som Amazon, Microsoft Azure och Google Cloud Platform.

I slutändan, kanske efter ett decennium eller så av utveckling, skulle edge computing kunna ge snabba tjänster till kunder så nära som deras närmaste trådlösa basstationer. Vi skulle behöva enorma fiberoptiska rör för att tillhandahålla den nödvändiga backhaul, men intäkterna från edge computing-tjänsterna skulle kunna finansiera byggandet av dem, vilket skulle göra det möjligt att betala sig självt.

Mål för servicenivåer

I slutändan (om någon analys någonsin har varit slutgiltig) kommer framgången eller misslyckandet för datacenter vid nätverksranden att avgöras av deras förmåga att uppfylla målen för servicenivåer (SLO). Detta är de förväntningar som kunder som betalar för tjänster har, och som är kodifierade i deras tjänstekontrakt. Ingenjörer har mått som de använder för att registrera och analysera nätverkskomponenternas prestanda. Kunderna tenderar att undvika dessa mått och väljer i stället att föredra den observerbara prestandan hos sina tillämpningar. Om en edge-installation inte är märkbart snabbare än en hyperscale-installation kan edge som koncept dö i sin linda.

”Vad bryr vi oss om? Det är applikationernas svarstid”, förklarade Tom Gillis, VMwares senior vice president för nätverk och säkerhet, under en företagskonferens nyligen. ”Om vi kan karakterisera hur applikationen svarar och titta på de enskilda komponenterna som arbetar för att leverera applikationsresponsen, kan vi faktiskt börja skapa den självläkande infrastrukturen.”

Den minskade latensen och den förbättrade bearbetningshastigheten (med nyare servrar som ägnas åt betydligt färre uppgifter kvantitativt sett) bör spela till fördel för SLO. Vissa har också påpekat hur den breda fördelningen av resurser över ett område bidrar till redundans av tjänster och till och med till affärskontinuitet – som åtminstone fram till pandemin uppfattades som en- eller tvådagarshändelser, följt av återhämtningsperioder.

Men det kommer att finnas balanserande faktorer, varav den viktigaste har att göra med underhåll och skötsel. En typisk Tier 2-datacenteranläggning kan i nödsituationer (t.ex. vid en pandemi) underhållas av så få som två personer på plats, med stödpersonal utanför anläggningen. Samtidigt är en µDC-anläggning utformad för att fungera utan ständig personal. Dess inbyggda övervakningsfunktioner skickar kontinuerligt telemetri till en central hubb, som teoretiskt sett skulle kunna befinna sig i det offentliga molnet. Så länge ett µDC uppfyller sina SLO:er behöver det inte ha någon personlig närvaro.

Det är här som lönsamheten hos edge computing-modellen ännu inte har testats grundligt. I ett typiskt kontrakt med en datacenterleverantör mäts ett SLO ofta utifrån hur snabbt leverantörens personal kan lösa ett utestående problem. Vanligtvis kan lösningstiderna förbli låga när personalen inte behöver ta sig till problemställen med lastbil. Om en edge-utnyttjandemodell ska kunna konkurrera med en colocation-utnyttjandemodell är det bäst att dess automatiserade avhjälpningsmöjligheter är extremt bra.

Det nivåindelade nätverket

Leverantörer av datalagring, värdar för molnbaserade tillämpningar, leverantörer av IoT-tjänster (Internet of Things), servertillverkare, fastighetsinvesteringsbolag (REIT) och tillverkare av förmonterade serverhöljen banar alla snabbvägar mellan sina kunder och det som för var och en av dem lovar att vara kanten.

Vad de alla egentligen letar efter är konkurrensfördelar. Idén om en fördel ger nytt hopp om utsikterna för premiumtjänster – en solid, motiverad anledning för vissa klasser av tjänster att kräva högre priser än andra. Om du har läst eller hört någon annanstans att edge till slut skulle kunna ta över hela molnet, förstår du kanske nu att det faktiskt inte skulle vara särskilt meningsfullt. Om allt vore premium skulle ingenting vara premium.

”Edge computing kommer tydligen att bli den perfekta tekniska lösningen, och riskkapitalister säger att det kommer att bli en teknisk marknad som omsätter flera miljarder dollar”, påpekade Kevin Brown, CTO och senior vicepresident för innovation för Schneider Electric, leverantör av datacentertjänstutrustning och tillverkare av chassin för mikrodatacenter. ”Ingen vet egentligen vad det är.”

Schneider Electrics Kevin Brown: ”Ingen vet faktiskt vad det är.”

Brown erkände att edge computing kan tillskriva sin historia till de banbrytande CDN:erna, som Akamai. Ändå, fortsatte han, ”har man alla dessa olika lager – HPE har sin version, Cisco har sin. . . Vi kunde inte förstå något av detta. Vår syn på kanten är egentligen en mycket förenklad syn. I framtiden kommer det att finnas tre typer av datacenter i världen som man verkligen måste oroa sig för.”

Den bild som Brown tecknade, under ett pressevent vid företagets huvudkontor i Massachusetts i februari 2019, är en återkommande syn på ett Internet i tre nivåer och delas av ett växande antal teknikföretag. I den traditionella modellen med två nivåer är Tier-1-noderna begränsade till peering med andra Tier-1-noder, medan Tier-2-noderna hanterar datadistribution på regional nivå. Sedan Internets början har det funnits en beteckning för Tier-3 – för åtkomst på en mycket mer lokal nivå. (Jämför detta med systemet för mobiltelefonnätet Radio Access Network, vars trafikdistribution är enkelriktad).

”Den första punkten som du ansluter till nätverket är egentligen vad vi betraktar som den lokala kanten”, förklarade Brown. Han fortsatte med att säga att om man använder dagens teknik kan man hitta en av dagens kantdatoranläggningar i en server som är placerad i ett provisoriskt rack i ett kabelskåp.

”För våra syften”, fortsatte han, ”tror vi att det är där det händer saker”.

”I åratal var kantområdet Tier-1-operatörshotell som Equinix och CoreSite. De hade i princip ett lager av ett nätverk som anslöt till ett annat, och det betraktades som en kant”, förklarade Wen Temitim, teknisk direktör för leverantören av kantinfrastrukturtjänster StackPath. ”Men vad vi ser, med alla olika förändringar i användningen baserat på konsumenternas beteende, och med COVID-19 och hemarbete, är en ny och djupare kant som blir mer relevant för tjänsteleverantörerna.”

Lokalisering av kanten på en karta

Edge computing är ett försök att återföra tjänstekvalitet (QoS) till diskussionen om datacenterarkitektur och -tjänster, eftersom företagen inte bara bestämmer vem som ska tillhandahålla deras tjänster, utan också var.

Den ”operativa tekniska kanten”

Datacenterutrustningstillverkaren HPE – en stor investerare i edge computing – anser att nästa stora steg i driftinfrastrukturen kommer att samordnas och ledas av personal och entreprenörer som kanske inte har så mycket, om ens någon, personlig investering eller utbildning i hårdvara och infrastruktur – personer som hittills till stor del har haft till uppgift att sköta underhåll, skötsel och programvarustöd. Hennes företag kallar den här personalkategorin för driftsteknik (OT). Till skillnad från dem som anser att IT och drift konvergerar i en eller annan form av ”DevOps”, ser HPE tre klasser av edge computing-kunder. Enligt HPE:s uppfattning kommer inte bara var och en av dessa klasser att ha sin egen edge computing-plattform, utan dessa plattformar kommer också att vara geografiskt åtskilda från varandra och inte konvergera, vilket framgår av HPE:s diagram.

Här finns det tre distinkta klasser av kunder, som HPE har fördelat till sitt eget segment av edge i stort. OT-klassen avser här kunder som är mer benägna att utse chefer till edge computing och som har mindre direkt erfarenhet av IT, främst på grund av att deras huvudprodukter inte är själva informations- eller kommunikationsprodukterna. Denna klass har tilldelats en ”OT edge”. När ett företag har mer direkta investeringar i information som bransch, eller i stor utsträckning är beroende av information som en del av sin verksamhet, tilldelar HPE det en ”IT edge”. Mellan dessa två, för de företag som är geografiskt utspridda och beroende av logistik (där informationen har en mer logisk komponent) och därmed sakernas Internet, ger HPE dem en ”IoT edge”.

Dells tredelade nätverk

Under 2017 erbjöd Dell Technologies för första gången sin tredelade topologi för datamarknaden i stort, genom att dela in den i ”kärna”, ”moln” och ”kant”. Som denna bild från en tidig Dell-presentation visar verkade denna uppdelning radikalt enkel, åtminstone till en början: Alla kunders IT-tillgångar kunde delas upp i 1) det som kunden äger och underhåller med egen personal, 2) det som den delegerar till en tjänsteleverantör och anlitar den för att underhålla, och 3) det som den distribuerar utanför sina egna anläggningar till fältet, för att underhållas av driftspersonal (som kan vara utlokaliserad eller inte).

I en presentation i november 2018 för Linux Foundation’s Embedded Linux Conference Europe, gjorde CTO for IoT and Edge Computing Jason Shepherd detta enkla fall: Eftersom många nätverksenheter och apparater planeras för IoT kommer det att vara tekniskt omöjligt att centralisera deras hantering, även om vi anlitar det offentliga molnet.

”Min fru och jag har tre katter”, berättade Shepherd för sin publik. ”Vi fick större lagringskapacitet på våra telefoner, så att vi kunde skicka kattvideor fram och tillbaka.

”Kattvideos förklarar behovet av edge computing”, fortsatte han. ”Om jag lägger ut en av mina videor på nätet och den börjar få besök måste jag cacha den på fler servrar, långt bort i molnet. Om den blir viral måste jag flytta innehållet så nära abonnenterna som möjligt. Som telebolag, Netflix eller vad det nu kan vara, är det närmaste jag kan komma molnkanten – längst ner på mina mobilmaster, dessa nyckelpunkter på Internet. Detta är konceptet MEC, Multi-access Edge Computing – att föra innehållet närmare abonnenterna. Om jag nu har miljarder uppkopplade kattsamtalare där ute har jag helt vänt på paradigmet, och i stället för att saker och ting försöker dra nedåt har jag alla dessa enheter som försöker skjuta uppåt. Det gör att du måste trycka ner beräkningen ännu mer.”

Det framväxande ”kantmolnet”

Sedan världspremiären av Shepherds skrämda kattunge har Dells koncept för kanten hårdnat något, från en nyanserad sammansättning av lager till mer av en grundläggande decentraliseringsmoral.

”Vi ser kanten som något som inte nödvändigtvis definieras av en specifik plats eller en specifik teknik”, sade Matt Baker från Dell i februari förra året. ”I stället är det en komplikation för den befintliga IT-användningen, eftersom vi i allt högre grad decentraliserar våra IT-miljöer och därför finner att vi placerar IT-infrastrukturlösningar, mjukvara etc. i allt mer begränsade miljöer. Ett datacenter är en i stort sett obegränsad miljö; du kan bygga det enligt den specifikation du vill ha, du kan kyla det på lämpligt sätt, det finns gott om utrymme. Men i takt med att vi placerar mer och mer teknik ute i världen omkring oss för att underlätta leveransen av digitala upplevelser i realtid, befinner vi oss på platser som är utmanade på något sätt.”

Campusnätverken, sade Baker, innehåller utrustning som tenderar att vara dammig och smutsig, bortsett från att de har en anslutning med låg bandbredd. Telco-miljöer omfattar ofta rack med mycket kort djup som kräver en processorpopulation med mycket hög densitet. Och på de mest avlägsna platserna på kartan finns det en brist på kvalificerad IT-arbetskraft, ”vilket ökar trycket på förmågan att hantera starkt distribuerade miljöer på ett hands-off, obemannat sätt”.

Det åligger dock ett växande antal kunder att behandla data närmare den punkt där de först bedöms eller skapas, hävdade han. Detta innebär att ”kanten” omkring 2020 ligger vid den punkt på kartan där data, i brist på en bättre beskrivning, börjar brinna.

StackPaths Temitim anser att den punkten är ett framväxande koncept som kallas edge cloud – i praktiken en virtuell samling av flera edge-installationer i en enda plattform. Denna plattform skulle först marknadsföras till videodistributörer med flera kanaler (MVPD:er, vanligen etablerade kabelföretag men även vissa telekombolag) som vill äga sina egna distributionsnät och sänka sina kostnader på lång sikt. Men som en ytterligare intäktskälla skulle dessa leverantörer sedan kunna erbjuda tjänster som liknar tjänster i ett offentligt moln, t.ex. SaaS-tillämpningar eller till och med hosting av virtuella servrar, för kommersiella kunders räkning.

En sådan marknad för ”edge cloud” skulle kunna konkurrera direkt med världens medelstora Tier 2- och Tier 3-datacenter. Eftersom operatörerna av dessa anläggningar vanligtvis är premiumkunder hos telekombolagen i deras respektive regioner, skulle dessa telekombolag kunna uppfatta edge cloud som ett konkurrenshot mot deras egna planer för trådlös 5G. Det är verkligen, som en leverantör av kantinfrastruktur uttryckte det, en ”fysisk landvinning”. Och detta har egentligen bara börjat.