Im siebten Zug der entscheidenden Partie machte Schwarz einen Fehler, den manche heute als kritisch ansehen. Als Schwarz die Züge für die Caro-Kann-Verteidigung verwechselte, nutzte Weiß den Vorteil und schuf einen neuen Angriff, indem er einen Springer opferte. In nur 11 weiteren Zügen hatte Weiß eine so starke Stellung aufgebaut, dass Schwarz keine andere Wahl hatte, als die Niederlage einzugestehen. Der Verlierer reagierte mit einem Aufschrei – einer der schärfsten Betrugsvorwürfe, die jemals in einem Turnier erhoben wurden, was eine internationale Verschwörungstheorie auslöste, die auch 20 Jahre später noch in Frage gestellt wird.

Dies war keine gewöhnliche Schachpartie. Es ist nicht ungewöhnlich, dass ein unterlegener Spieler seinen Gegner des Betrugs bezichtigt – aber in diesem Fall war der Verlierer der damalige Schachweltmeister Garry Kasparov. Der Sieger war sogar noch ungewöhnlicher: der IBM-Supercomputer Deep Blue.

Mit seinem Sieg über Kasparow am 11. Mai 1997 schrieb Deep Blue Geschichte, denn er war der erste Computer, der einen Weltmeister in einem Sechs-Spiele-Match unter Standardzeitkontrolle besiegte. Kasparow hatte die erste Partie gewonnen, die zweite verloren und die folgenden drei unentschieden gespielt. Als Deep Blue das letzte Spiel gewann, wollte Kasparow es nicht glauben.

In Anlehnung an die Schachautomaten-Schwindel des 18. und 19. Jahrhunderts argumentierte Kasparow, dass der Computer tatsächlich von einem echten Großmeister gesteuert worden sein müsse. Er und seine Anhänger glaubten, dass das Spiel von Deep Blue zu menschlich war, um von einer Maschine gesteuert zu werden. Für viele Außenstehende, die von der Leistung des Computers überzeugt waren, sah es so aus, als hätte die künstliche Intelligenz ein Stadium erreicht, in dem sie die Menschheit überlisten könnte – zumindest bei einem Spiel, das lange Zeit als zu komplex für eine Maschine galt.

Hören Sie sich eine Audioversion dieses Artikels auf dem Podcast In Depth Out Loud von The Conversation an.

In Wirklichkeit lag der Sieg von Deep Blue jedoch genau darin begründet, dass der Computer angesichts von Kasparows emotionalem Verhalten starr und unmenschlich auf kalte, harte Logik setzte. Es handelte sich nicht um künstliche (oder echte) Intelligenz, die unseren eigenen kreativen Denk- und Lernstil demonstrierte, sondern um die Anwendung einfacher Regeln im großen Stil.

Was das Match jedoch bewirkte, war der Beginn eines gesellschaftlichen Wandels, der heute immer mehr an Geschwindigkeit und Einfluss gewinnt. Die Art der umfangreichen Datenverarbeitung, auf die sich Deep Blue verließ, findet sich heute in fast jedem Winkel unseres Lebens, von den Finanzsystemen, die die Wirtschaft beherrschen, bis hin zu Online-Dating-Apps, die versuchen, den perfekten Partner für uns zu finden. Was als Studentenprojekt begann, hat dazu beigetragen, das Zeitalter von Big Data einzuläuten.

Ein menschlicher Fehler

Die Grundlage von Kasparovs Behauptungen ging auf einen Zug zurück, den der Computer in der zweiten Partie des Matches machte, der ersten im Wettbewerb, die Deep Blue gewann. Kasparow hatte gespielt, um seinen Gegner dazu zu bringen, einen „vergifteten“ Bauern zu nehmen, eine Opferfigur, die den Computer zu einem verhängnisvollen Zug verleiten sollte. Diese Taktik hatte Kasparov bereits in der Vergangenheit gegen menschliche Gegner angewandt.

Was Kasparov überraschte, war der folgende Zug von Deep Blue. Kasparow nannte ihn „menschenähnlich“. John Nunn, der englische Schachgroßmeister, beschrieb ihn als „verblüffend“ und „außergewöhnlich“. Der Zug machte Kasparov wütend und brachte ihn schließlich von seiner Strategie ab. Er war so beunruhigt, dass er schließlich aufgab und die Partie verlor. Schlimmer noch, er erholte sich nie davon, spielte die nächsten drei Partien remis und machte dann in der letzten Partie den Fehler, der zu seinem Untergang führte.

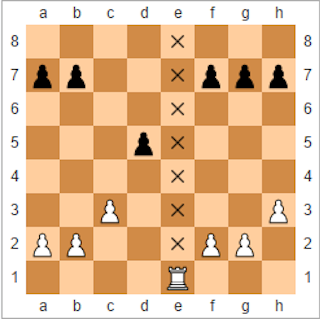

Der Zug basiert auf dem strategischen Vorteil, den ein Spieler durch das Anlegen einer offenen Datei, einer Reihe von Feldern auf dem Brett (von oben gesehen), die keine Figuren enthalten, erlangen kann. Dadurch kann eine Angriffsroute, typischerweise für Türme oder Damen, geschaffen werden, die frei von Bauern ist, die den Weg versperren. Während des Trainings mit dem Großmeister Joel Benjamin hatte das Deep Blue-Team gelernt, dass es manchmal eine strategischere Option gibt, als ein Feld zu öffnen und dann einen Turm dorthin zu ziehen. Stattdessen bestand die Taktik darin, Figuren auf die Datei zu stapeln und dann zu entscheiden, wann sie geöffnet werden sollte.

Als die Programmierer dies erfuhren, schrieben sie den Code von Deep Blue um, um die Züge zu integrieren. Während der Partie nutzte der Computer die Position einer potenziell offenen Datei, um Kasparow unter Druck zu setzen und ihn zu zwingen, sich bei jedem Zug zu verteidigen. Dieser psychologische Vorteil zermürbte Kasparow schließlich.

Von dem Moment an, als Kasparow verlor, begannen Spekulationen und Verschwörungstheorien. Die Verschwörungstheoretiker behaupteten, IBM habe während des Matches menschlich eingegriffen. IBM dementierte dies und erklärte, dass der einzige menschliche Eingriff gemäß den Regeln zwischen den Spielen erfolgte, um Fehler zu beheben, die während des Spiels festgestellt worden waren. Sie wiesen auch die Behauptung zurück, die Programmierung sei an Kasparows Spielstil angepasst worden. Stattdessen habe man sich auf die Fähigkeit des Computers verlassen, eine riesige Anzahl möglicher Züge zu durchsuchen.

Die Ablehnung von Kasparows Bitte um einen Rückkampf durch IBM und die anschließende Demontage von Deep Blue trugen nicht dazu bei, den Verdacht zu zerstreuen. IBM verzögerte auch die Freigabe der detaillierten Protokolle des Computers, um die Kasparow ebenfalls gebeten hatte, bis nach der Stilllegung. Aber die anschließende detaillierte Analyse der Protokolle hat der Geschichte neue Dimensionen verliehen, einschließlich der Erkenntnis, dass Deep Blue mehrere große Fehler gemacht hat.

In der Zwischenzeit wurde spekuliert, dass Deep Blue nur aufgrund eines Fehlers im Code während des ersten Spiels triumphierte. Einer der Entwickler von Deep Blue sagte, dass der Computer aufgrund eines Fehlers nicht in der Lage war, einen der analysierten Züge auszuwählen, sondern stattdessen einen zufälligen Zug auswählte, den Kasparov fälschlicherweise als tiefere Strategie interpretierte.

Er konnte die Partie gewinnen, und der Fehler wurde in der zweiten Runde behoben. Aber der Weltmeister war angeblich so erschüttert von dem, was er als die überlegene Intelligenz der Maschine ansah, dass er nicht in der Lage war, seine Fassung wiederzuerlangen und von da an zu vorsichtig spielte. Er verpasste sogar die Chance, aus der Taktik der offenen Datei zurückzukommen, als Deep Blue einen „schrecklichen Fehler“ beging.

Welche dieser Schilderungen von Kasparows Reaktionen auf das Match auch immer zutreffen, sie deuten darauf hin, dass seine Niederlage zumindest teilweise auf die Schwächen der menschlichen Natur zurückzuführen ist. Er dachte zu viel über einige Züge der Maschine nach und wurde unnötig ängstlich in Bezug auf ihre Fähigkeiten, wodurch er Fehler machte, die letztendlich zu seiner Niederlage führten. Deep Blue besaß nicht annähernd die Techniken der künstlichen Intelligenz, die heute Computern helfen, bei weitaus komplexeren Spielen wie Go zu gewinnen.

Aber selbst wenn Kasparow mehr eingeschüchtert war, als er hätte sein müssen, kann man die erstaunlichen Leistungen des Teams, das Deep Blue entwickelt hat, nicht leugnen. Seine Fähigkeit, es mit dem weltbesten menschlichen Schachspieler aufzunehmen, basierte auf einer unglaublichen Rechenleistung, die den Startschuss für das IBM-Supercomputerprogramm gab, das den Weg für einige der heute weltweit verfügbaren Spitzentechnologien ebnete. Was die Sache noch erstaunlicher macht, ist die Tatsache, dass das Projekt nicht als überschwängliches Vorhaben eines der größten Computerhersteller begann, sondern als studentische Abschlussarbeit in den 1980er Jahren.

Schachrennen

Als Feng-Hsiung Hsu 1982 aus Taiwan in die USA kam, konnte er nicht ahnen, dass er Teil einer intensiven Rivalität zwischen zwei Teams werden würde, die fast ein Jahrzehnt lang darum wetteiferten, den besten Schachcomputer der Welt zu bauen. Hsu war an die Carnegie Mellon University (CMU) in Pennsylvania gekommen, um das Design der integrierten Schaltkreise zu studieren, aus denen Mikrochips bestehen, aber er interessierte sich auch schon lange für Computerschach. Die Entwickler von Hitech, dem Computer, der 1988 als erster einen Schachgroßmeister besiegte, wurden auf ihn aufmerksam und baten ihn, bei der Entwicklung der Hardware mitzuwirken.

Doch schon bald kam es zu einem Zerwürfnis zwischen Hsu und dem Hitech-Team, nachdem er einen architektonischen Fehler im vorgeschlagenen Design entdeckt hatte. Zusammen mit mehreren anderen Doktoranden begann er, seinen eigenen Computer zu bauen, der unter dem Namen ChipTest bekannt wurde und auf der Architektur der Bell Laboratory Schachmaschine Belle basierte. Die maßgeschneiderte Technologie von ChipTest nutzte die so genannte „very large-scale integration“, um Tausende von Transistoren auf einem einzigen Chip zu vereinen, was es dem Computer ermöglichte, 500.000 Schachzüge pro Sekunde zu durchsuchen.

Obwohl das Hitech-Team einen Vorsprung hatte, sollten Hsu und seine Kollegen sie bald mit dem Nachfolger von ChipTest überholen. Deep Thought – benannt nach dem Computer in Douglas Adams‘ The Hitchhiker’s Guide to the Galaxy, der gebaut wurde, um den Sinn des Lebens zu finden – kombinierte zwei von Hsus maßgeschneiderten Prozessoren und konnte 720.000 Züge pro Sekunde analysieren. Dadurch konnte es 1989 die Weltmeisterschaft im Computerschach gewinnen, ohne eine einzige Partie zu verlieren.

Doch Deep Thought stieß im selben Jahr auf ein Hindernis, als es gegen den amtierenden Schachweltmeister Garry Kasparov antrat (und verlor). Um die Besten der Menschheit zu schlagen, mussten Hsu und sein Team noch viel weiter gehen. Jetzt aber hatten sie die Unterstützung des Computerriesen IBM.

Schachcomputer arbeiten, indem sie der Position jeder Figur auf dem Brett mit Hilfe einer als „Bewertungsfunktion“ bezeichneten Formel einen numerischen Wert zuordnen. Diese Werte können dann verarbeitet und durchsucht werden, um den besten Zug zu bestimmen. Frühe Schachcomputer, wie Belle und Hitech, verwendeten mehrere spezielle Chips, um die Bewertungsfunktionen auszuführen und die Ergebnisse zu kombinieren.

Das Problem war, dass die Kommunikation zwischen den Chips langsam war und viel Rechenleistung benötigte. Mit ChipTest hat Hsu die Prozessoren umgestaltet und auf einem einzigen Chip zusammengefasst. Dadurch entfiel eine Reihe von Zusatzkosten für die Verarbeitung, z. B. die Kommunikation außerhalb des Chips, und die Rechengeschwindigkeit konnte enorm gesteigert werden. Während Deep Thought 720.000 Züge pro Sekunde verarbeiten konnte, nutzte Deep Blue eine große Anzahl von Prozessoren, die dieselben Berechnungen gleichzeitig ausführten, um 100.000.000 Züge pro Sekunde zu analysieren.

Die Erhöhung der Anzahl der Züge, die der Computer verarbeiten kann, war wichtig, weil Schachcomputer traditionell so genannte „Brute-Force“-Techniken verwenden. Menschliche Spieler lernen aus früheren Erfahrungen, bestimmte Züge sofort auszuschließen. Schachcomputer verfügten zu dieser Zeit nicht über diese Fähigkeit und mussten sich stattdessen auf ihre Fähigkeit verlassen, für jeden möglichen Zug vorausschauend zu planen, was passieren könnte. Sie analysierten mit roher Gewalt eine sehr große Anzahl von Zügen, anstatt sich auf bestimmte Zugtypen zu konzentrieren, von denen sie bereits wussten, dass sie am wahrscheinlichsten funktionieren würden. Die Erhöhung der Anzahl der Züge, die eine Maschine in einer Sekunde betrachten konnte, gab ihr die Zeit, viel weiter in die Zukunft zu blicken, um herauszufinden, wohin verschiedene Züge das Spiel führen würden.

Im Februar 1996 war das IBM-Team bereit, es erneut mit Kasparow aufzunehmen, dieses Mal mit Deep Blue. Obwohl es die erste Maschine war, die einen Weltmeister in einem Spiel mit regulärer Zeitkontrolle besiegte, verlor Deep Blue das gesamte Match mit 4:2. Seine 100.000.000 Züge pro Sekunde reichten immer noch nicht aus, um die menschliche Strategiefähigkeit zu übertreffen.

Um die Anzahl der Züge zu erhöhen, begann das Team, die Maschine aufzurüsten, indem es erforschte, wie es eine große Anzahl von parallel arbeitenden Prozessoren optimieren konnte – mit großem Erfolg. Die endgültige Maschine war ein Supercomputer mit 30 Prozessoren, der – was noch wichtiger ist – 480 speziell für das Schachspiel entwickelte Schaltkreise steuerte. Dank dieses speziellen Designs konnte das Team die parallele Rechenleistung der Chips so stark optimieren. Das Ergebnis war eine neue Version von Deep Blue (manchmal auch Deeper Blue genannt), die etwa 200.000.000 Züge pro Sekunde durchsuchen kann. Das bedeutete, dass sie in der Lage war, jede mögliche Strategie bis zu 40 oder mehr Züge in der Zukunft zu erforschen.

Parallele Revolution

Als der Rückkampf im Mai 1997 in New York City stattfand, war die öffentliche Neugier groß. Reporter und Fernsehkameras schwärmten um das Brett herum und wurden mit einer Story belohnt, als Kasparow nach seiner Niederlage davonstürmte und sich auf einer anschließenden Pressekonferenz beschwerte. Aber die Publicity rund um das Match trug auch dazu bei, dass man besser verstand, wie weit sich die Computer entwickelt hatten. Was die meisten Menschen noch nicht wussten, war, wie die Technologie hinter Deep Blue dazu beitragen würde, den Einfluss von Computern auf fast alle Bereiche der Gesellschaft auszuweiten, indem sie die Art und Weise, wie wir Daten nutzen, verändert.

Komplexe Computermodelle werden heute eingesetzt, um die Finanzsysteme der Banken zu stützen, um bessere Autos und Flugzeuge zu entwerfen und um neue Medikamente zu testen. Systeme, die große Datensätze auswerten (oft als „Big Data“ bezeichnet), um nach signifikanten Mustern zu suchen, sind an der Planung öffentlicher Dienstleistungen wie Verkehr oder Gesundheitswesen beteiligt und ermöglichen es Unternehmen, Werbung gezielt an bestimmte Personengruppen zu richten.

Dies sind hochkomplexe Probleme, die eine schnelle Verarbeitung großer und komplexer Datensätze erfordern. Deep Blue gab Wissenschaftlern und Ingenieuren einen wichtigen Einblick in die massiv-parallelen Multi-Chip-Systeme, die dies möglich machen. Insbesondere zeigten sie die Möglichkeiten eines Allzweck-Computersystems, das eine große Anzahl von speziell für eine bestimmte Anwendung entwickelten Chips steuert.

Die Wissenschaft der Molekulardynamik beispielsweise befasst sich mit der Untersuchung der physikalischen Bewegungen von Molekülen und Atomen. Speziell entwickelte Chips haben es Computern ermöglicht, die Molekulardynamik zu modellieren, um im Voraus zu sehen, wie neue Medikamente im Körper reagieren könnten, so wie man verschiedene Schachzüge voraussieht. Molekulardynamische Simulationen haben dazu beigetragen, die Entwicklung erfolgreicher Medikamente zu beschleunigen, wie z. B. einige der Medikamente zur Behandlung von HIV.

Für sehr breit gefächerte Anwendungen wie die Modellierung von Finanzsystemen und Data Mining wäre die Entwicklung maßgeschneiderter Chips für eine einzelne Aufgabe in diesen Bereichen unerschwinglich. Das Deep-Blue-Projekt half jedoch bei der Entwicklung von Techniken zur Programmierung und Verwaltung hochparallelisierter Systeme, die ein Problem auf eine große Anzahl von Prozessoren aufteilen.

Heute stützen sich viele Systeme zur Verarbeitung großer Datenmengen auf Grafikverarbeitungseinheiten (GPUs) anstelle von speziell entwickelten Chips. Diese wurden ursprünglich entwickelt, um Bilder auf einem Bildschirm zu erzeugen, aber auch um Informationen mit vielen Prozessoren parallel zu verarbeiten. Daher werden sie heute häufig in Hochleistungscomputern eingesetzt, die große Datensätze verarbeiten und leistungsstarke Tools für künstliche Intelligenz wie den digitalen Assistenten von Facebook betreiben. Hier gibt es offensichtliche Ähnlichkeiten mit der Architektur von Deep Blue: maßgeschneiderte Chips (für die Grafik), die von Mehrzweckprozessoren gesteuert werden, um die Effizienz komplexer Berechnungen zu steigern.

Die Welt der Schachspielmaschinen hat sich seit dem Sieg von Deep Blue weiterentwickelt. Trotz seiner Erfahrung mit Deep Blue erklärte sich Kasparov 2003 bereit, gegen zwei der bekanntesten Schachmaschinen anzutreten, Deep Fritz und Deep Junior. Und beide Male gelang es ihm, eine Niederlage zu vermeiden, obwohl er immer noch Fehler machte, die ihn zu einem Remis zwangen. Bei den Mannschaftsweltmeisterschaften Mensch gegen Maschine in den Jahren 2004 und 2005 besiegten beide Maschinen ihre menschlichen Gegenspieler jedoch überzeugend.

Junior und Fritz markierten einen Wechsel in der Herangehensweise an die Entwicklung von Systemen für das Computerschach. Während Deep Blue ein speziell angefertigter Computer war, der sich auf die rohe Gewalt seiner Prozessoren verließ, um Millionen von Zügen zu analysieren, handelte es sich bei diesen neuen Schachmaschinen um Softwareprogramme, die Lerntechniken einsetzten, um die erforderliche Suche zu minimieren. Damit können sie die Brute-Force-Techniken mit nur einem Desktop-PC schlagen.

Aber trotz dieses Fortschritts haben wir immer noch keine Schachmaschinen, die in der Art und Weise, wie sie das Spiel spielen, der menschlichen Intelligenz ähneln – das brauchen sie auch nicht. Und wenn überhaupt, dann bestärken die Siege von Junior und Fritz die Idee, dass menschliche Spieler gegen Computer verlieren, zumindest teilweise wegen ihrer Menschlichkeit. Die Menschen machten Fehler, wurden ängstlich und fürchteten um ihren Ruf. Die Maschinen hingegen versuchten, das Spiel mit logischen Berechnungen zu gewinnen. Eines Tages werden wir vielleicht Computer haben, die das menschliche Denken wirklich nachahmen, aber die Geschichte der letzten 20 Jahre war der Aufstieg von Systemen, die gerade deshalb überlegen sind, weil sie Maschinen sind.